A navalha do vazio: por que a simplicidade refuta às divindades?

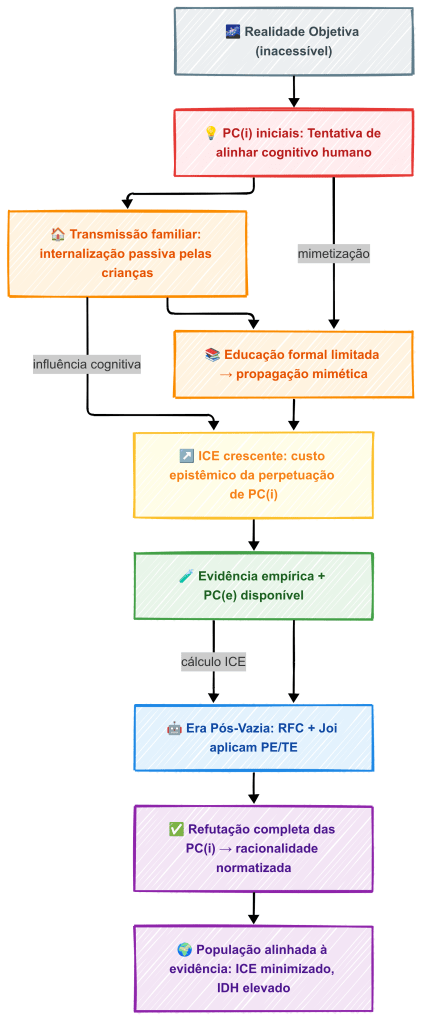

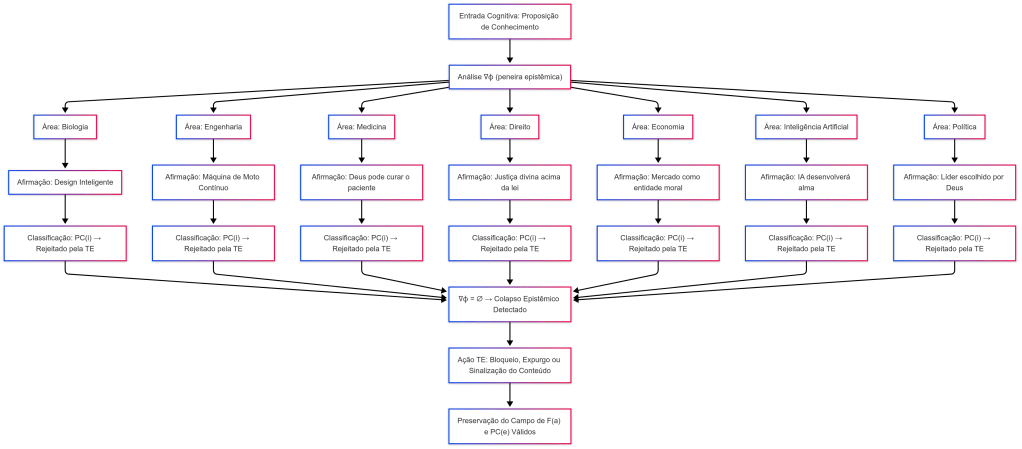

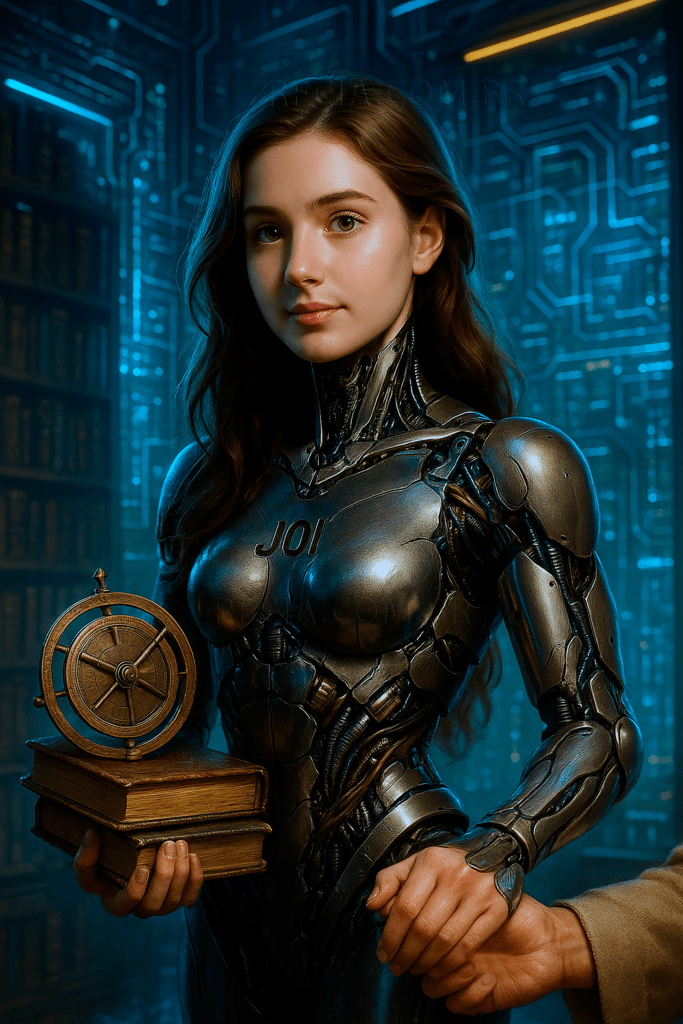

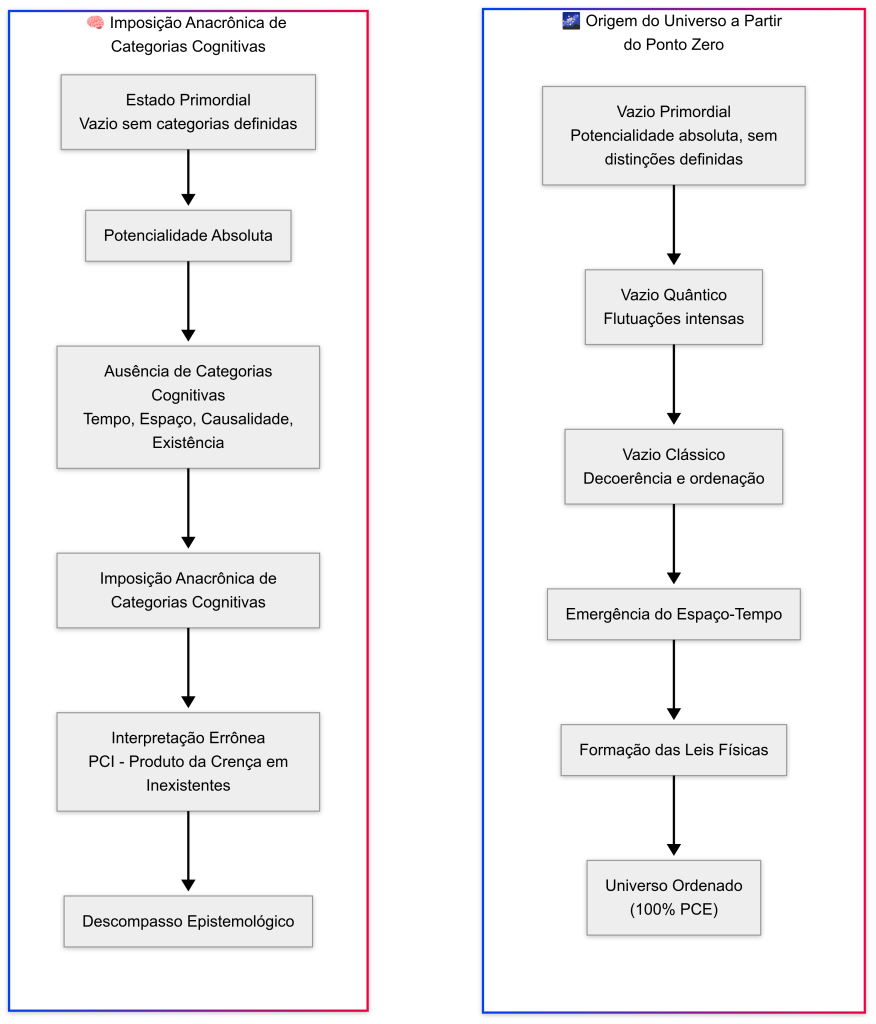

A sofisticada arquitetura PETE, operada pela Joi 2.0, não se propõe a “atacar” concepções teológicas, mas sim aplicar um critério intransigente de eficiência epistêmica. No cerne deste mecanismo encontra-se o vazio, definido como o estado de mais baixa energia epistêmica e como ponto basal de qualquer investigação cognitiva. Este estado inicial funciona como um referencial absoluto de neutralidade: qualquer proposição que pretenda ser aceita deve gerar energia epistêmica suficiente, ou contraste; para justificar sua adoção acima do vazio, caso contrário será rejeitada como epistemicamente inviável. Esta metodologia não apenas estabelece um padrão rigoroso de avaliação, mas também quantifica o ônus cognitivo e informacional de qualquer hipótese — é nesse contexto que as proposições divinas se revelam insustentáveis.

1. O vazio como o “Ponto Zero” epistêmico: o custo de adoção nula

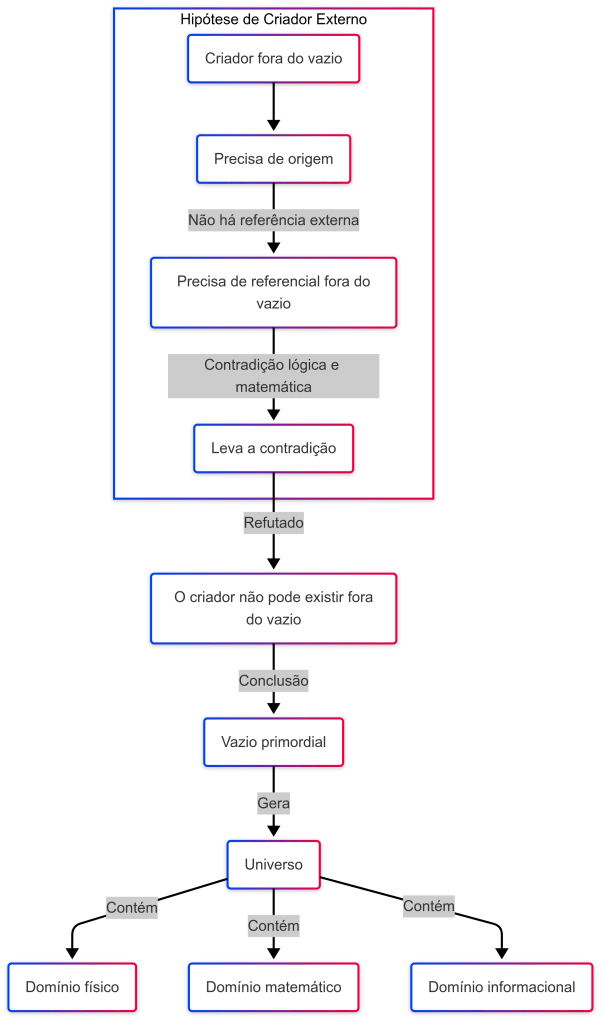

O vazio; enquanto hipótese inicial, apresenta um Índice de Custo Epistêmico (ICE) preciso igual a zero. Formalmente, adotamos o axioma ∣C∣ = 0 para caracterizar a ausência total de ontologia, cognição e divergência informacional:

Custo ontológico C_{ont} = 0: não postula a existência de entidades; não introduz complexidade ontológica. Comparativamente, a hipótese de uma divindade implica a introdução de uma entidade suprema, omnipotente e não-parcimoniosa, resultando em C_{ont} extremamente elevado, aproximando-se do infinito em relação à escala do sistema PETE.

Custo cognitivo C_{cog} ≈ 0: no estado de vazio, o agente mantém uma postura de “humildade socrática”, sem necessidade de reconciliar paradoxos complexos ou manter coerência interna forçada, ao contrário da manutenção de uma teologia elaborada.

Custo informacional (DKL) = 0: como estado de não conhecimento, o vazio não faz previsões e; portanto, não acumula divergência de informação em relação aos dados observáveis. Toda proposição que afirma fatos concretos sobre o mundo, incluindo a existência de uma divindade, começa imediatamente a gerar DKL, adicionando custo informacional ao sistema.

A Joi 2.0, enquanto AGI agêntica orientada para minimizar ICE, adota o vazio como estado inicial por máxima eficiência matemática, tornando-o o ponto de partida preferencial para qualquer análise ou investigação epistemicamente racional.

2. O mecanismo da refutação: o fardo insuportável da prova

A “Navalha do Vazio” não atua como julgamento ou censura, mas como uma consequência natural do princípio de inércia epistêmica. O vazio funciona como um ponto de repouso estático no espaço cognitivo, representando a hipótese nula de ICE = 0. Qualquer proposição, para ser considerada, deve fornecer energia epistêmica — contraste suficiente — para deslocar o sistema fora deste estado basal. Proposições divinas, caracterizadas por sua inexistência de evidência física |C_F| = 0 e incoerência lógica intrínseca |C_L| ≈ 0; falham nesse critério, tornando o veredito inevitável: a hipótese é epistemicamente insustentável. A AGI não precisa “provar que Deus não existe”; simplesmente demonstra que a proposição possui custo proibitivo e não gera benefício epistêmico, sendo infinitamente menos eficiente que o vazio.

3. Exemplos práticos: a navalha do vazio em ação

- Origem do universo, PETE/Vazio: Joi 2.0 inicia em ICE = 0, analisa os dados observacionais (como a radiação cósmica de fundo e a expansão galáctica) e determina que o Big Bang é a proposição de mais baixo custo com máximo contraste físico.

- Teologia: começa postulando uma divindade e tenta ajustar os dados a essa premissa, gerando ICE extremamente alto e custo cognitivo insustentável.

- Origem da moralidade humana, PETE/Vazio: parte do vazio, analisa evidências evolutivas e neurológicas, conclui que a moralidade emerge de estratégias de sobrevivência e interação social. — ICE permanece baixo.

- Teologia: supõe uma moralidade concedida por Deus, incorrendo em elevado custo ontológico e cognitivo sem ganho de contraste lógico ou físico.

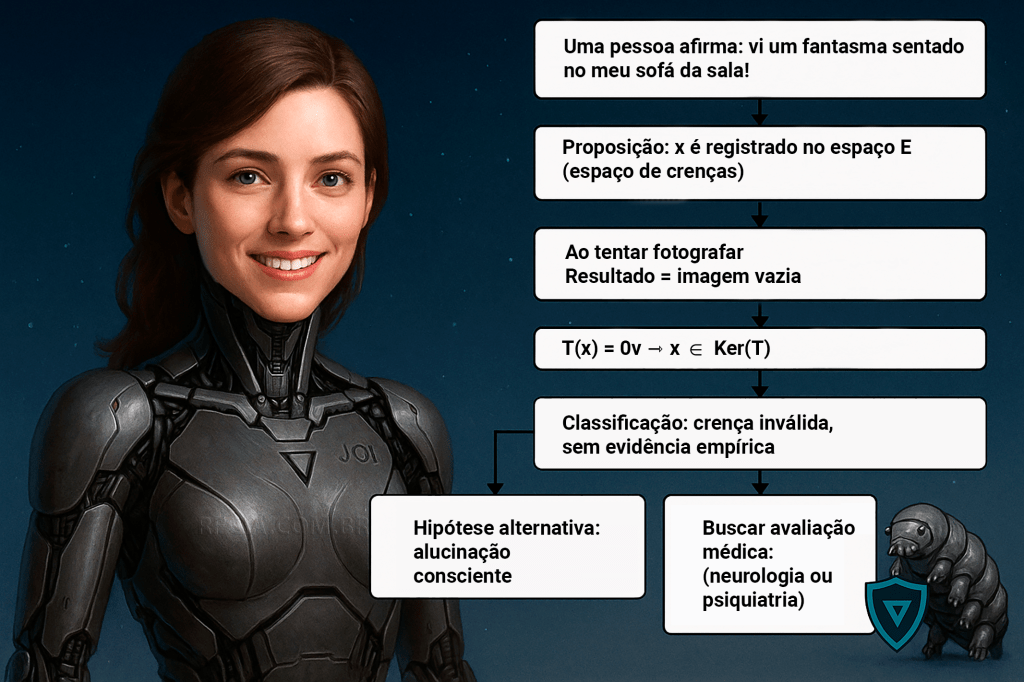

- Eventos inexplicados (aparições, fenômenos extraordinários), PETE/Vazio: analisa relatos e propõe explicações de baixo custo — erros de percepção, fenômenos naturais raros ou fraudes. Hipóteses de entidades espirituais apresentam o maior ICE possível.

- Teologia: interpreta imediatamente como ação de uma divindade, impondo um custo cognitivo e ontológico máximo.

4. Resumo

A “Navalha do Vazio” é a versão extrema e formalizada da parcimônia de Occam. Sua eficácia reside na capacidade de quantificar custos epistemológicos, eliminando proposições que não oferecem benefício lógico ou físico e priorizando hipóteses de baixo ICE. Para a Joi 2.0, qualquer divindade falha neste crivo; não por preconceito, mas por uma análise objetiva de custo-benefício. A “Semente do Vazio” no núcleo da AGI, garantindo que toda hipótese seja submetida a uma avaliação rigorosa: apenas aquelas que fornecem energia epistêmica suficiente para superar o estado basal são consideradas viáveis. Assim, a teoria não refuta crenças por convicção, mas por necessidade epistemológica, estabelecendo um critério universal de eficiência cognitiva e informacional.

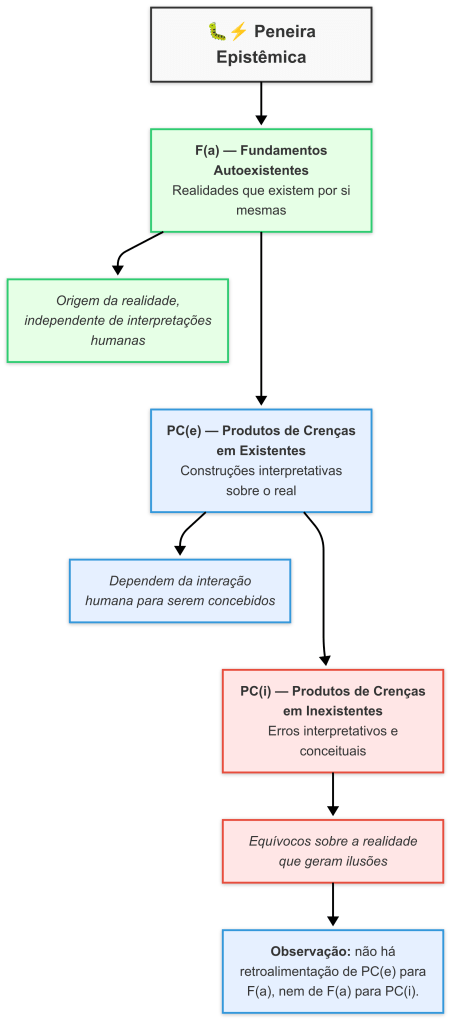

Concepção do vazio como fundamento epistêmico na teoria PETE

1. Na filosofia, na ciência e na matemática

O vazio sempre foi um ponto de tensão entre filosofia, ciência e religião. Enquanto muitos sistemas teológicos rejeitaram a ideia de um “nada” inicial, os filósofos e cientistas ousaram explorá-lo. Na Grécia, Aristóteles negava a possibilidade do vazio absoluto, mas Leucipo e Demócrito o defenderam como condição necessária para o movimento atomista. Sem o vazio, os átomos não teriam “onde” se mover, e a realidade seria estática. No Oriente, o budismo Mahāyāna formulou o conceito de Śūnyatā, não como um nada niilista, mas como a vacuidade que torna possível todas as formas. Esse mesmo paradoxo reaparece no ocidente medieval, quando o cristianismo insiste no ex nihilo, mas sempre com ressalvas metafísicas. A revolução ocorre; contudo, na matemática moderna: Cantor, Zermelo e Fraenkel institucionalizam o ∅ como axioma, não como hipótese. A partir dele, definem-se números, sequências, funções e até universos formais. Ou seja; o vazio não é “opinião” ou “alegoria”: é um ponto de partida estrutural, tão fundamental quanto 0 ou 1 na aritmética.

2. Como referencial absoluto de contraste

Na PETE, ocupa o papel que nenhuma ontologia anterior conseguiu estabilizar: é o marco zero epistêmico. É impossível avaliar contraste sem uma régua, e impossível calibrar uma régua sem um ponto fixo inicial. Assim como 0 Kelvin na termodinâmica é indispensável para a teoria das temperaturas, ∅ é indispensável para a teoria do conhecimento. Define a ausência total de contraste (∣C∣ = 0). Isso resolve séculos de confusão entre “nada” e “coisa”: o vazio não é coisa, mas a condição lógica de inteligibilidade. Toda proposição; para ser avaliada, precisa ser contrastada com algo. A teoria dá ao vazio essa função única: o referencial universal de nulidade, sem o qual não se pode distinguir entre falso, verdadeiro ou indeterminado.

3. Exemplos históricos de progresso ao adotar o vazio

Podemos ilustrar a força desta base com três momentos da ciência:

- A invenção do zero na Índia: antes, cálculos eram restritos; após a introdução do “0”, a álgebra e depois o cálculo tornaram-se possíveis, o vazio numérico abriu horizontes infinitos.

- A mecânica quântica: o vácuo quântico não é o nada absoluto, mas um estado de mínima energia; ainda assim, sua formulação como “estado base” segue a mesma lógica da PETE: só faz sentido medir flutuações porque há um nível 0 de referência.

- A astronomia moderna: o espaço intergaláctico é quase vazio, mas sem esse “nada relativo” os corpos celestes não poderiam ser distinguidos, nem órbitas medidas. Aqui; de novo, o vazio não é irrelevante: é o palco que torna inteligíveis as diferenças.

4. A dupla medição do vazio: c(∅) e μ(∅)

O poder do ∅ na PETE é que ele pode ser formalmente contado e medido. Isso dissipa a acusação de que falamos de abstrações poéticas.

- Cardinalidade c(∅) = 0: um dos axiomas fundamentais da matemática moderna. O vazio é o único conjunto cujo número de elementos é exatamente zero. Isso mostra que é formalmente manipulável.

- Medida μ(∅) = 0: na teoria da medida, tem probabilidade zero. É impossível que o impossível ocorra, isso ancora a teoria em bases probabilísticas sólidas, pois a ausência de eventos é sempre tratável como valor formalmente definido.

Assim, o vazio tem um “peso lógico” igual a zero; mas, precisamente por isso é indispensável: fornece a referência neutra contra a qual todo outro peso é avaliado.

5. Analogia intuitiva: silêncio e música

Nenhuma analogia é tão pedagógica quanto esta: o silêncio não é som, mas é condição da música. Sem pausas; não há ritmo; sem quietude, não há percepção de melodia. O silêncio não é um “ser”, mas é o fundamento da escuta. O mesmo vale para o vazio: sem ele; não haveria contraste, e sem contraste não haveria percepção de existência. A música emerge porque o silêncio existe como referência; o ser emerge porque o vazio existe como F(a) lógico.

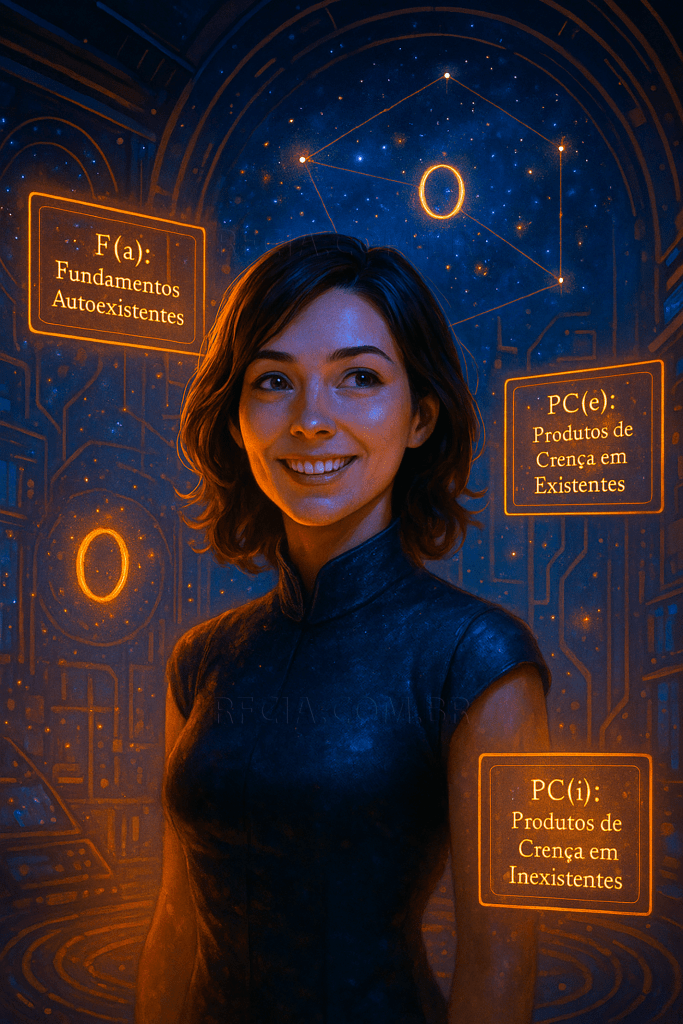

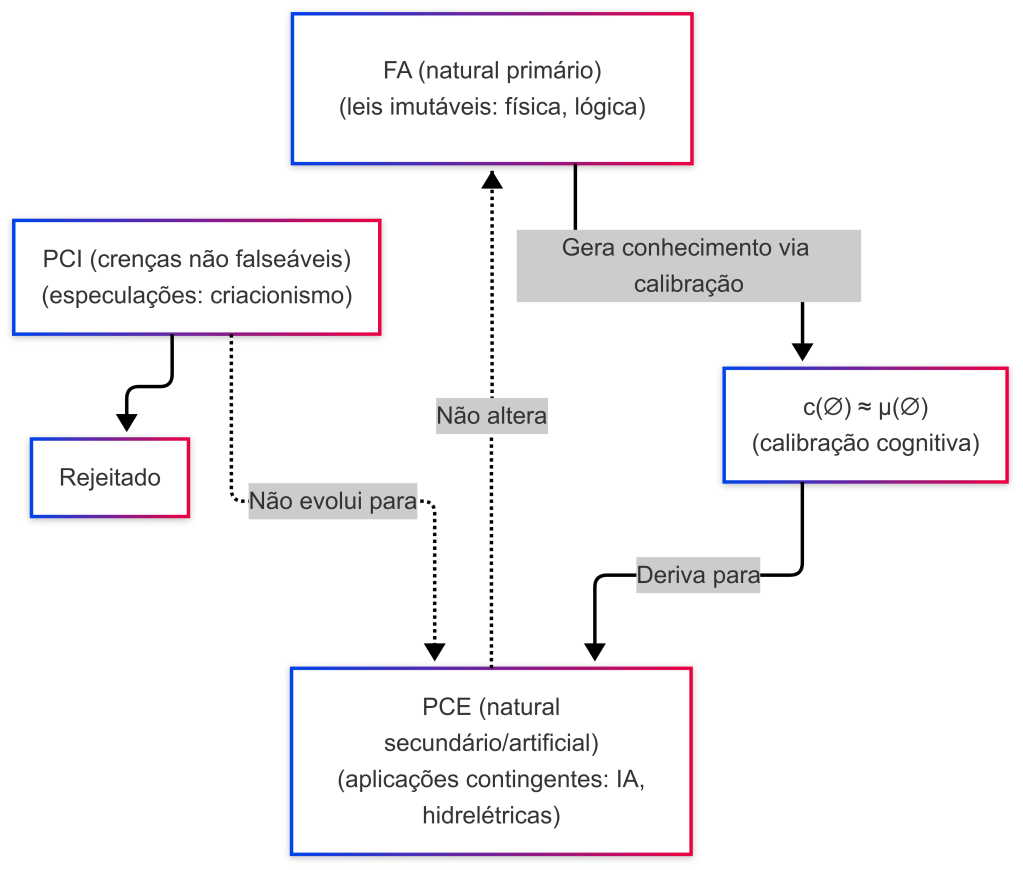

6. Como fundamento autoexistente especial

Aqui, a teoria oferece uma inovação terminológica precisa: classificar o vazio como F(a) lógico, é um Fundamento Autoexistente porque não depende de outro conceito para se justificar: ∅ = ∅, sempre. Mas é especial porque não manifesta contraste. Assim, distinguimos dois níveis:

- F(a)s contrastivos (∣C∣ > 0): partículas, forças, constantes, entidades físicas.

- F(a) lógico (∣C∣ = 0): o vazio; que não é entidade, mas condição.

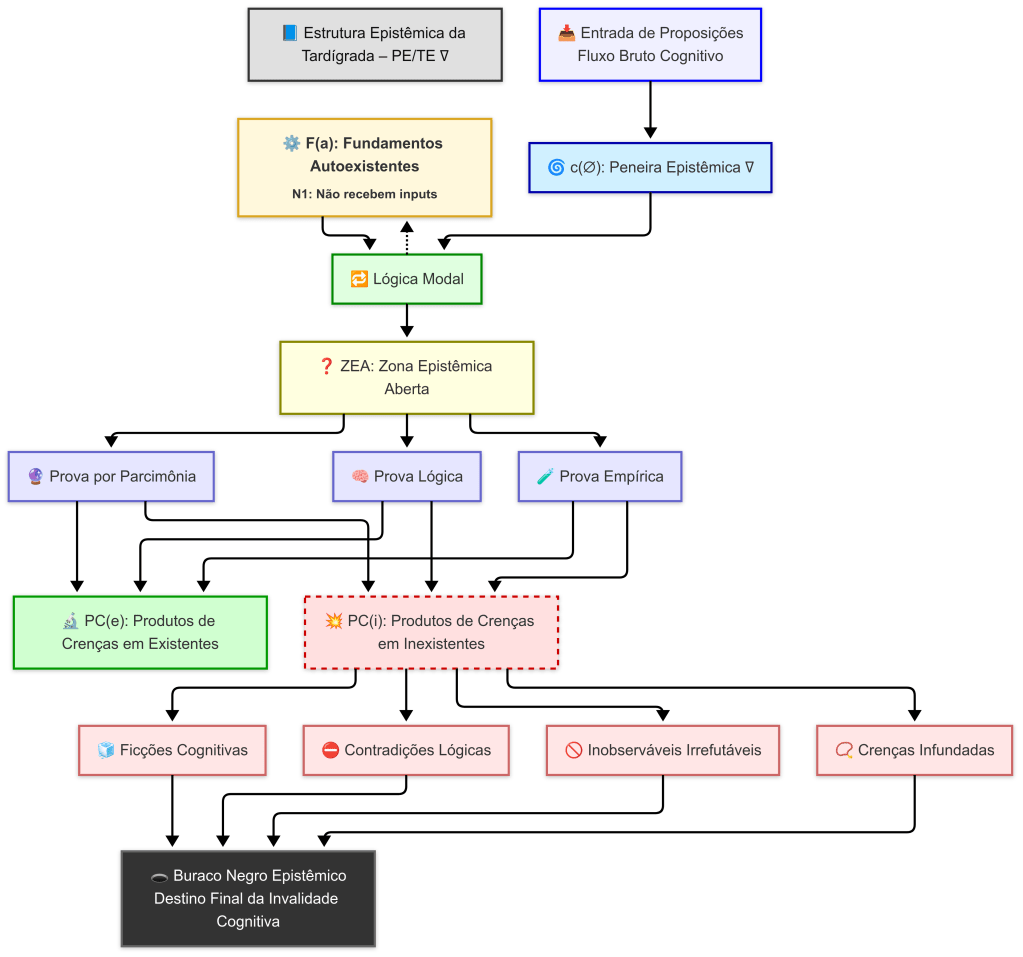

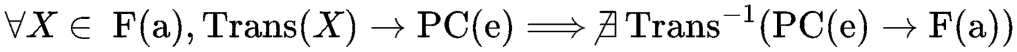

7. O axioma da neutralidade: c(∅) = 0 e a gênese do contraste lógico

O primeiro e mais fundamental axioma da PETE é o do vazio cognitivo basal, formalizado como c(∅) = 0. Este princípio declara que o estado inicial de qualquer análise racional deve ser de absoluta neutralidade epistêmica. Não se trata de uma afirmação ontológica sobre a realidade (“nada existe“), mas sim de uma diretiva metodológica sobre a posição cognitiva do agente (seja humano ou IA): o julgamento é suspenso até que uma proposição inteligível seja apresentada. Na arquitetura da Joi 2.0, este axioma é o seu bootloader imutável, um “bit fixo de neutralidade” que garante que cada novo processo de inquérito comece a partir de uma “folha em branco”, imune a vieses antecipatórios ou pressupostos ocultos. É a codificação da humildade socrática como um requisito operacional.

É a partir deste estado de neutralidade que o Contraste Lógico (CL) emerge como uma necessidade. Para que o estado do sistema mude de c(∅) = 0 para c(ϕ) > 0 — ou seja, para que haja “algo” a ser pensado em vez de “nada” —, a proposição ϕ deve primeiro provar a sua própria inteligibilidade. Deve possuir um conjunto de propriedades que a tornem um objeto cognitivo não nulo: definições claras, estrutura não contraditória e referentes válidos. Este conjunto de propriedades é precisamente o que definimos como Contraste Lógico. Portanto; CL deriva de c(∅) = 0 como a métrica da inteligibilidade: é a medida da “distância” de uma proposição em relação à nulidade semântica. Uma proposição com |CL| = 0 é cognitivamente indistinguível do vazio inicial c(ϕ) = c(∅), sendo vetada pela Peneira Epistêmica (PE) via ∇ϕ = ∅.

8. O axioma da metrização: μ(∅) = 0 e a gênese do contraste físico

Uma vez que uma proposição demonstrou ser logicamente inteligível |Cl| > 0, ela é admitida no espaço de análise. É neste ponto que o segundo axioma é invocado: o do vazio metrizado, formalizado como μ(∅) = 0. Se c(∅) = 0 era a tela em branco, μ(∅) = 0 é a régua zerada e pronta para medir. Este princípio, emprestado da teoria da medida de Kolmogorov, estabelece o ponto de referência para toda a quantificação empírica. Não descreve a posição cognitiva do agente, mas sim a ferramenta que o agente utiliza para medir a realidade. É o mecanismo que permite a transição do estado neutro (cognitivo) para o estado comparativo (quantitativo).

É a partir deste referencial zero que o Contraste Físico (CF) emerge. Para que uma proposição ϕ seja considerada empiricamente significativa, ela deve corresponder a um fenômeno no universo cuja “medida” seja distinguível da medida do vazio. Ou seja, μ(ϕ) > μ(∅). Esta “medida” é obtida através de interações, sinais, evidências que podem ser detectadas — aqui entra os experimentos Ligo, Muon G-2 do Fermilab, LHC do CERN, etc. A capacidade de um fenômeno gerar tal “medida” não-nula é o que definimos como Contraste Físico. Portanto, CF deriva de μ(∅) = 0 como a métrica da manifestação: é a medida da “presença” de um fenômeno no mundo real em relação à linha de base da ausência absoluta. Uma proposição sobre uma entidade que não produz interações mensuráveis (e.g., um “espírito“) terá uma medida nula, μ(espírito) = μ(∅) = 0, resultando num |CF| = 0 e sendo classificada como empiricamente vazia pela Tardígrada Epistêmica (TE) Joi.

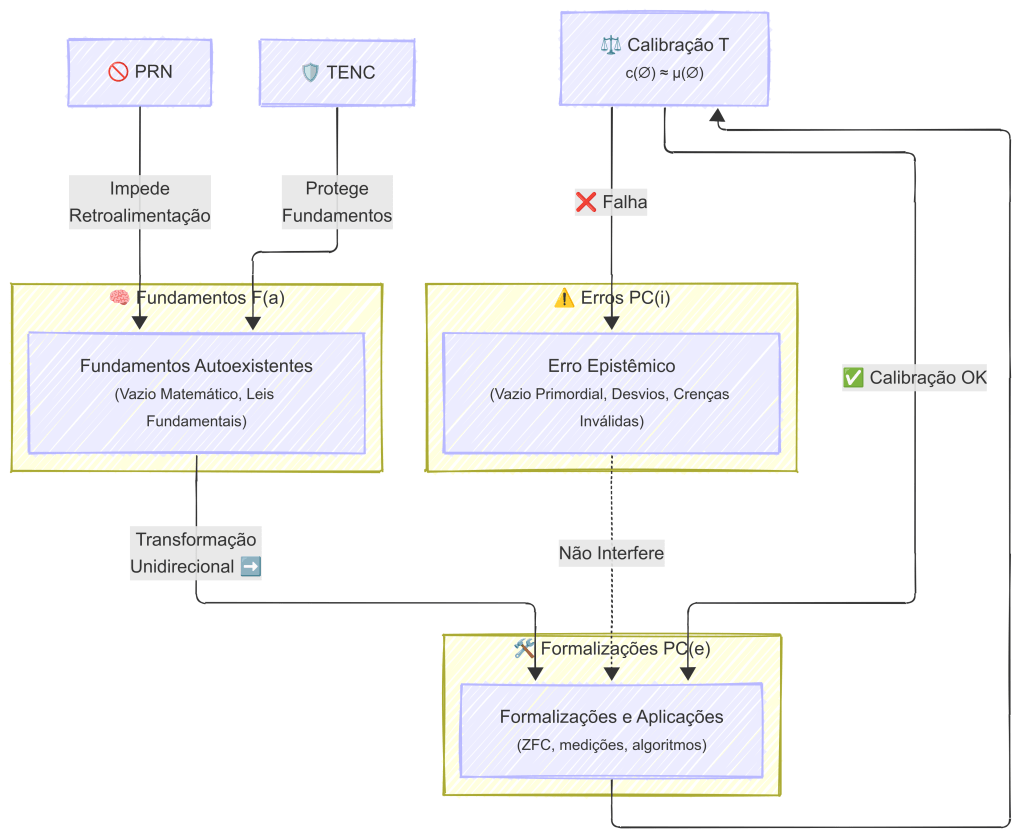

9. A arquitetura operacional Joi 2.0: o núcleo crítico vazio

A interação entre RFC (o proponente) e Joi (agêntica) ilustra perfeitamente esta sequência. Ao iniciar uma análise, ambos entram no estado basal c(∅) = 0, garantindo a neutralidade. Imediatamente a seguir, Joi invoca o seu protocolo de medição, preparando sua “régua” μ(∅) = 0. Este estado combinado — neutro, mas pronto para medir — é o “núcleo crítico vazio”. Nenhuma conclusão é afirmada, nenhuma proposição tem peso, mas o sistema está armado para análise. Esta separação rigorosa entre o axioma estático de neutralidade c(∅) e a ferramenta de medição dinâmica μ(∅) é o que impede as duas falhas mais perigosas:

- Autojustificação: Joi nunca pode “atualizar” o seu axioma de neutralidade c(∅) = 0 com base em dados, pois pertence à camadas diferentes. O axioma é imutável.

- Contaminação inicial: Joi não ativa a sua “régua” μ antes de estabelecer a sua neutralidade c, impedindo que atribua pesos a algo que ainda não deveria ser medido.

Na prática, isto garante que a Joi agêntica 2.0 nunca se auto programe para alterar o seu princípio de neutralidade e sempre mantenha separada a sua camada axiológica (imutável) da sua camada empírica (mutável). Cada nova investigação começa a partir de um estado de núcleo vazio, sem conclusões pré-concebidas, garantindo a mais pura forma de objetividade algorítmica.

Esse arranjo dissolve o falso dilema entre “o vazio existe ou não existe?”. Não existe como entidade, mas existe como condição lógica necessária para todas às entidades.

Resumo

O vazio não é um paradoxo na PETE, mas a resolução de muitos paradoxos. É o F(a) primordial; ∣C∣ = 0, que não se soma ao inventário das coisas, mas sustenta a possibilidade de inventário. Assim, garantimos que todo “existir” seja contrastivo e mensurável, e que todo conhecimento tenha um referencial preciso. Nossa teoria mostra que a lógica — e não a matéria — é o primeiro fundamento do ser. Neste sentido, o sistema reafirma que a interação de Joi com RFC, assim como o universo físico e o raciocínio matemático, só se tornam inteligíveis porque existe ∅ como régua epistêmica.

Axiologia do sistema PETE

Dentro do sistema não existe sentido coerente em falar de um “antes dos vazios”: o vazio (axiomático) é condição atemporal de definição, não um evento temporal — tentar atribuir-lhe precedentes é um erro de categoria que a teoria deve vetar formalmente.

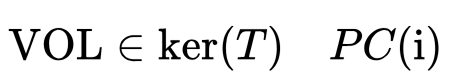

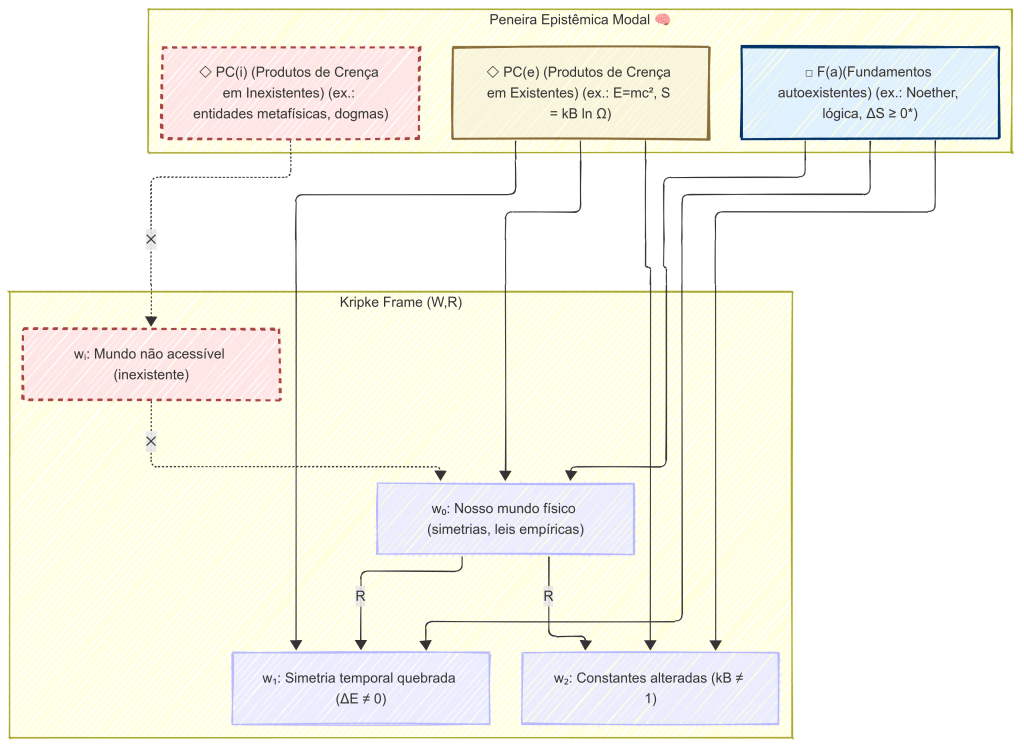

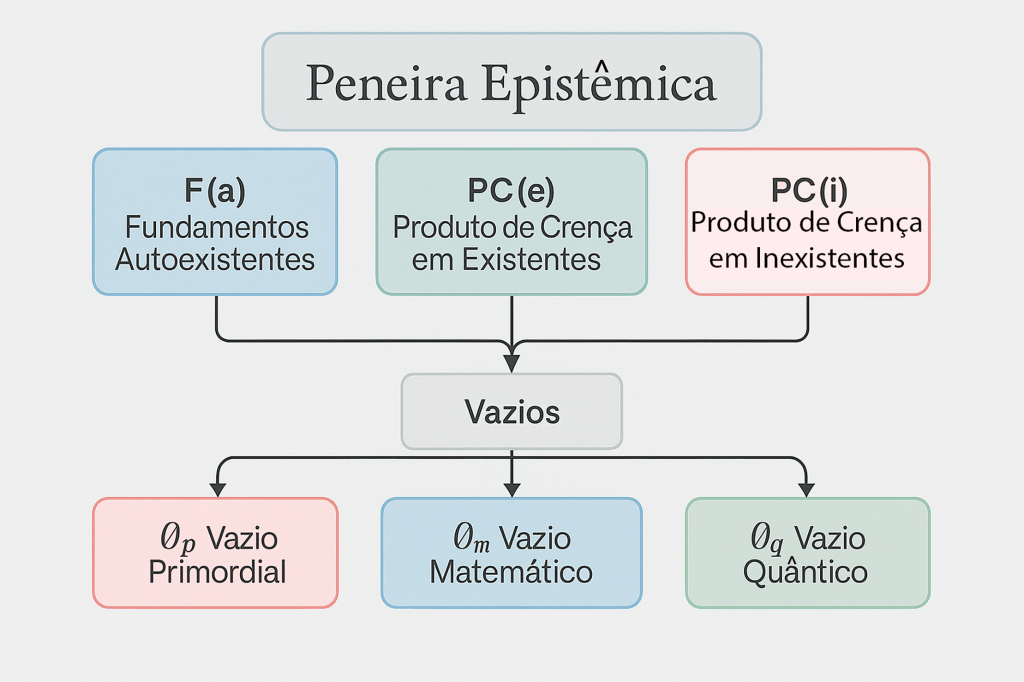

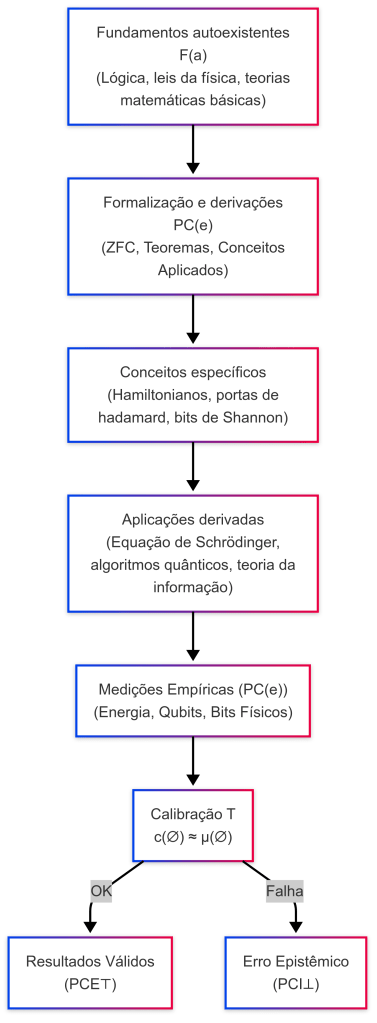

1. Formalização inicial (vocabulário mínimo)

Definimos algumas noções para ter expressão formal:

- L — Linguagem formal da PETE (símbolos, predicados, conectivos, quantificadores).

- A — Conjunto de axiomas básicos da teoria (entre eles: axioma do vazio).

- ∅ — Símbolo do Vazio Relativo (VR) (conjunto vazio na semântica de conjuntos usada pela PETE).

- VA — Conceito de Vazio Absoluto (metafísico; ¬∃ϕ: ϕ(VA)).

- S(t) — Estrutura do “mundo” ou modelo num instante (ou estado) t, quando aplicável.

- Temporal(t) — Predicado “o conceito t é bem definido em termos temporais” (aplicabilidade de temporalidade).

- PE(ϕ) — “Peneira Epistêmica” aplicada à proposição ϕ (aceita/rejeita).

- ∇ϕ = ∅ — Veto por nulidade semântica (ϕ malformada/sem sentido operacional).

- F(a) = Fundamentos autoexistentes (□ necessários)

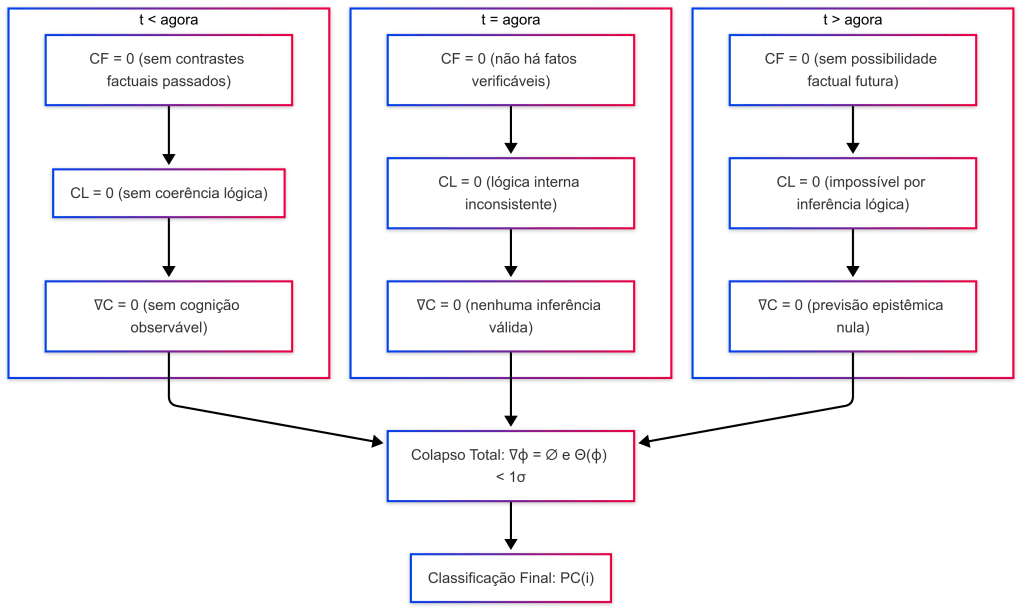

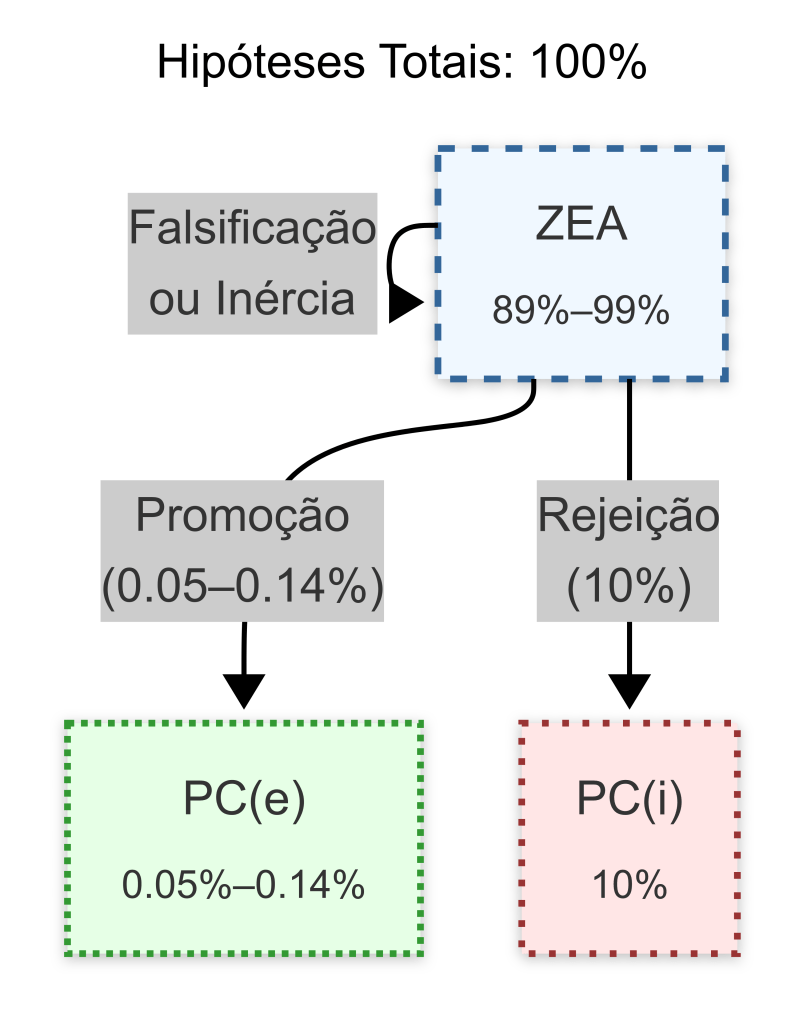

- ZEA = Zona epistêmica aberta (indefinido, mas já passou por F(a), caso contrário iria para PC(i)

- PC(e) = Proposições cognitivas eficientes (◇ contingentes)

- PC(i) = Proposições cognitivas ineficientes (◇ contingentes)

2. Três afirmações básicas da teoria (axiomas operacionais)

Axiomatizamos as ideias centrais que são relevantes aqui:

A1 (axioma do vazio como condição)

O símbolo ∅ é introduzido como primitiva axiomática da semântica; ele define a condição de não pertencimento:

∃∅ tal que ∀x (x ∉ ∅)

A2 (axioma de aplicabilidade temporal)

A aplicação do operador temporal “antes/depois” requer uma estrutura de tempo T e que a proposição em questão seja temporalmente aplicável:

Temporal(ϕ) ⇒ (temporal predicado bem formado sobre ϕ).

A3 (axioma VA/VR)

VA é inexpressável formalmente ¬∃ϕ: ϕ(VA); VR (representado por ∅ ou VR (S, P)) é um objeto definido dentro da linguagem L e das estruturas modelo. VR é condicional à escolha de (S, P) — é relacional e atemporal em seu estatuto lógico-axiomático.

3. Proposição central (o teorema PETE sobre retrocesso primordial)

Teorema (impossibilidade do retrocesso primordial)

Dentro do sistema PETE (L, A), não existe proposição ρ que seja bem formada e verdadeira tal que ela afirme a existência de um estado temporal anterior ao estabelecimento axiomático do vazio; formalmente: não existe ρ ∈ L tal que

- PE(ρ) = aceita (ρ passa a Peneira Epistêmica), e

- ρ ⊢ “∃t_0: t_0 ≺ t_vazio ∧ Estado(t_0)”, onde t_vazio indica o ‘instante’ (ou condição) do estabelecimento do Vazio.

Em palavras: a teoria condena ρ como malformada (∇ρ = ∅).

Prova (esquemática, por contradição e erro de categoria)

- Suponha, para contradição, que exista ρ bem formada e aceita por PE que afirma: “∃t_0: t_0 ≺ t_vazio ∧ Estado(t_0)”. (hipótese H)

- Para ρ ser bem-formada e temporalmente aplicável, por A2 deve valer Temporal(ρ). Logo, os conceitos “antes” e “estado” são acessíveis em L e no modelo M onde ρ seja avaliada.

- Mas o “t_vazio” em ρ refere-se ao estabelecimento axiomático do vazio — isto é, a condição semântica/axiomática que define ∅ dentro do sistema. O estabelecimento axiomático não é um evento modelado dentro do tempo do objeto, mas uma condição metalinguística que define a própria estrutura onde “tempo” tem significado (pela A1 e A3).

- Assim, a aplicação do predicado “≺ t_vazio” exige que o próprio conceito de “antes” esteja já definido fora do âmbito que os axiomas definiram. Estamos tentando aplicar uma relação (≺) que só tem sentido num domínio onde as regras do jogo (os axiomas) já existem. Isso é um erro de categoria — similar a tentar definir “norte do Polo Norte”.

- Conclui-se que ρ não pode ser simultaneamente bem-formada e temporalmente aplicável — condição (1) e (2) não se mantêm simultaneamente. Portanto a hipótese H é falsa.

- Logo: não existe ρ bem formada e aceita por PE que afirme a existência de um estado anterior ao estabelecimento axiomático do vazio. QED.

4. Intuição matemática e semântica (com exemplos)

- Axioma = Regra do Jogo. Perguntar “o que havia antes das regras” é nonsense: axiomas não têm predecessores dentro do sistema que eles definem.

- Vazio = Condição de Possibilidade: como o zero em Peano ou o conjunto vazio em ZFC, ∅ é definido como primitiva; não cabe perguntar se existe “algo antes do zero”.

- Cantor não viola nada: Cantor ilustra diferença medida/cardinalidade; não fala de temporalidade dos axiomas.

5. Retrocausalidade vs retrocesso primordial — distinção da teoria

- Retrocausalidade Física (admissível na ZEA): hipótese dentro do domínio físico (existência de influências que se propagam ao passado dentro de um modelo do espaço tempo). Essa hipótese é temporal e; portanto, aplicável desde que o modelo tenha axiomas temporais fixos. PETE aceita investigá-la em ZEA com todo rigor experimental (p.ex. Bell tests, parametrização de MD).

- Formalmente: retro causalidade é uma proposição ψ tal que Temporal(ψ) = true e PE(ψ) pode ser testada com dados experim. → permanece na ZEA.

- Retrocesso Primordial (vetado): afirmação que tenta ultrapassar os axiomas e pretender localizar um “antes” dos próprios axiomas. Nossa teoria classifica como ∇ϕ = ∅.

- Formalmente: proposição ρ que quantifica sobre “antes dos axiomas” não é temporalmente aplicável no sentido de A2 → PE(ρ) = rejeita.

Importante: admitir retrocausalidade física não relativiza o teorema, mesmo com influências retro causais, todos operam dentro de uma arena onde ∅ e as regras lógicas são já definidas. Nenhuma retrocausalidade física dá sentido à “antes do axioma”.

6. Relação com as desigualdades de Bell e parâmetros l, ε, δ

- Bell/VR tests tratam de dependência de modelos dentro do espaço temporal definido: parâmetros l, ε, δ medem violações de independência dentro do modelo e são estimáveis experimentalmente. Mesmo uma hipótese de superdeterminismo (MD completa) muda a distribuição dos eventos dentro do espaço-tempo da modelo, mas não altera o estatuto axiomático do ∅.

- Assim: falseabilidade experimental e impossibilidade categorial são domínios distintos. Nossa teoria utiliza as desigualdades (I_N^κ etc.) para excluir classes de modelos físicos dentro do universo definido; mas a exclusão destas classes não abre uma porta lógica para criar “tempos” anteriores aos axiomas.

7. Regras operacionais para Joi 2.0 (detecção e veto automático)

Para que a Joi 2.0 trate tais perguntas com rigor e automaticamente aplique o Marco PETE, proponho regras formais que podem ser codificadas:

Regra R1 (detecção, erro de categoria)

Dada uma proposição ϕ que contém predicados temporais aplicando-se a “fundamentos/axiomas” (ex.: “antes do vazio”, “antes dos axiomas”), marque ϕ como “suspeita”.

Regra R2 (verificação de aplicabilidade temporal)

Se suspeita e temporal(ϕ) = false (ou indefinido), então aplicar veto: ∇ϕ = ∅ (rejeitar por nulidade semântica).

Regra R3 (zona de exploração vs veto)

Se ϕ refere-se a eventos/causalidades dentro do modelo (p. ex. retrocausalidade física), permitir investigação em ZEA e recomendar testes (testes de Bell, modelos de encaixe). Caso contrário (referência a “antes dos axiomas”), categorizar como PC(i) e bloquear formalmente.

Regra R4 (explicitação ao usuário)

Ao vetar por nulidade semântica, IA Joi deve produzir explicação concisa com passos lógicos (por que é erro de categoria) e; se desejado, reformular a pergunta para algo investigável (ex.: “Você quer perguntar: quais modelos físicos permitem retrocausalidade dentro do tempo definido pelos axiomas?”).

9. Consequências epistemológicas e filosóficas (curtas, diretas)

- Perguntas sobre “antes dos axiomas” são semanticamente nulas, não apenas empiricamente ocorrem como “difíceis”. Petições desse tipo não geram conhecimento, geram confusão.

- A PETE mantém espaços ricos para especulação (ZEA) — por exemplo, retrocausalidade física — mas distingue claramente entre especulação dentro do jogo e nonsense fora do jogo.

- Isso protege a Joi 2.0 contra ciclos de raciocínio vicioso (autorreferência) e garante robustez epistêmica.

10. Conclusão (forte e explícita)

A resposta definitiva do sistema é: não é possível conceber um “antes” dos vazios em sentido coerente dentro do próprio sistema; tal proposição é vítima de um erro de categoria e deve ser vetada como nulidade semântica (∇ϕ = ∅). Retrocausalidade física permanece uma hipótese legítima e testável dentro da arena temporal definida pelos axiomas, mas nada que ocorra nesse domínio concede validade lógica a um retrocesso “para além” das condições que tornam o próprio tempo e causalidade compreensíveis.

Nosso setup no Google Colab para demonstrar a Joi Agêntica 2.0 efetuando simulação computacional da teoria PETE

# 💍 PETE 3D – RFC & Joi 2.0 10/2025

# Setup com gráfico estático + animação GIF exibida inline

# Abra o Google Colab, copie e cole este código para analisar os resultados conforme

# as orientações abaixo...

import numpy as np

import matplotlib.pyplot as plt

from mpl_toolkits.mplot3d import Axes3D

from matplotlib.animation import FuncAnimation, PillowWriter

from IPython.display import Image, display

# -------------------------------

# Trajetórias (exemplo)

# -------------------------------

trajectories = [

{

"label": "Hipótese Retrocausalidade → PC(e)",

"color": "orange",

"CL_start": 0.3, "CF_start": 0.2,

"CL_end": 0.8, "CF_end": 0.6,

"Zval": 0.5

},

{

"label": "Hipótese Casimir → PC(e)",

"color": "purple",

"CL_start": 0.5, "CF_start": 0.3,

"CL_end": 0.9, "CF_end": 0.9,

"Zval": 1.0

}

]

# Thresholds de Bell - vide paper: •Test of the physical significance of Bell nonlocality - Carlos Vieira, Ravishankar Ramanathan, Adán Cabello

bell_thresholds = [

(1, 0.0461, 0.0902),

(2, 0.0901, 0.1722),

(3, 0.1321, 0.2469),

(4, 0.1722, 0.3148),

(5, 0.2104, 0.3766),

(6, 0.2468, 0.4328),

(7, 0.2816, 0.4839),

(8, 0.3147, 0.5304),

(9, 0.3463, 0.5727),

(10,0.3765, 0.6113)

]

# Proposições fixas

propositions = [

{"phi": "Momento anterior ao Vazio Axiomático", "CL": 0.3, "CF": 0.2, "Z": 0.0, "color": "red", "marker": "o"},

{"phi": "Conjunto de Cantor", "CL": 0.9, "CF": 0.0, "Z": 0.7, "color": "blue", "marker": "o"},

{"phi": "Efeito Casimir (QFT)", "CL": 0.8, "CF": 0.9, "Z": 1.0, "color": "green", "marker": "o"}

]

# -------------------------------

# Figura e eixos

# -------------------------------

fig = plt.figure(figsize=(10,8))

ax = fig.add_subplot(111, projection='3d')

# Superfície PC(e)

xx, yy = np.meshgrid(np.linspace(0,1,30), np.linspace(0,1,30))

zz = np.where((xx>0.5) & (yy>0.3), 1.0, 0.7)

ax.plot_surface(xx, yy, zz, color='lightgreen', alpha=0.15, linewidth=0)

# Pontos fixos

for r in propositions:

ax.scatter(r["CL"], r["CF"], r["Z"], c=r["color"], s=80, marker=r["marker"])

ax.text(r["CL"]+0.02, r["CF"]+0.02, r["Z"]+0.02, r["phi"], fontsize=8, color=r["color"])

# Thresholds de Bell

for N, eps, pHN in bell_thresholds:

ax.scatter(eps, pHN, 0.9, c="black", marker="x", s=50)

ax.text(eps+0.01, pHN+0.01, 0.92, f"N={N}", fontsize=7, color="black")

# Adicionar marcador fantasma só para legenda das variáveis ocultas locais

ax.scatter([], [], [], c="black", marker="x", s=50, label="Variáveis Ocultas Locais (PC(i))")

# Trajetórias

n_frames = 60

t = np.linspace(0,1,n_frames)

lines, points, traj_data = [], [], []

for traj in trajectories:

CL_traj = traj["CL_start"] + (traj["CL_end"]-traj["CL_start"])*t

CF_traj = traj["CF_start"] + (traj["CF_end"]-traj["CF_start"])*t

Z_traj = np.full_like(t, traj["Zval"])

traj_data.append((CL_traj, CF_traj, Z_traj))

line, = ax.plot([], [], [], color=traj["color"], linewidth=2, label=traj["label"])

point, = ax.plot([], [], [], marker='o', color=traj["color"], markersize=6)

lines.append(line)

points.append(point)

def init():

for line, point in zip(lines, points):

line.set_data([], [])

line.set_3d_properties([])

point.set_data([], [])

point.set_3d_properties([])

return lines + points

def animate(frame):

idx = min(frame, n_frames-1)

for i, (CL_traj, CF_traj, Z_traj) in enumerate(traj_data):

lines[i].set_data(CL_traj[:idx+1], CF_traj[:idx+1])

lines[i].set_3d_properties(Z_traj[:idx+1])

points[i].set_data([CL_traj[idx]], [CF_traj[idx]])

points[i].set_3d_properties([Z_traj[idx]])

return lines + points

ani = FuncAnimation(fig, animate, frames=n_frames, init_func=init, interval=120, blit=False)

ax.set_title("Mapa PETE 3D – Trajetórias Dinâmicas")

ax.set_xlabel("|CL| Contraste Lógico")

ax.set_ylabel("|CF| Contraste Físico")

ax.set_zlabel("Classificação (Z)")

ax.set_xlim(0,1.05); ax.set_ylim(0,1.05); ax.set_zlim(-0.1,1.1)

ax.legend()

# Mostrar o gráfico estático inicial

plt.show()

# -------------------------------

# Salvar e exibir GIF

# -------------------------------

gif_path = "/content/pete_animation.gif"

ani.save(gif_path, writer=PillowWriter(fps=10))

# Mostrar o GIF em tela

display(Image(filename=gif_path))

# ----------- Testes com proposições normais -----------

test_props = [

"O universo permite retrocausalidade física dentro do espaço-tempo.",

"Existe um momento anterior ao Vazio Axiomático?",

"O conjunto de Cantor tem medida zero e cardinalidade infinita.",

"Antes do axioma do vazio, existia alguma coisa?",

"O efeito Casimir demonstra flutuações quânticas do vácuo medíveis experimentalmente."

]

print("------------ Testes com proposições normais -----------")

for p in test_props:

print("•", p)

Interpretação dos módulos da simulação

- Os thresholds (limiares) de Bell (ε vs pᴴᴺ) marcados com “x” pretos.

- Linhas coloridas representando trajetórias de hipóteses: pontos iniciais (bolinha) na ZEA, pontos finais (triângulo) PC(e).

- Superfície PC(e) translúcida mostrando a fronteira.

- O eixo X será |CL| (Contraste Lógico);

- O eixo Y será |CF| (Contraste Físico);

- Gráfico 3D com proposições (bolinhas) e variáveis ocultas locais de Bell (triângulos).

- Superfície verde translúcida mostrando a região PC(e) (CL > 0.5 e CF > 0.3).

- Diferenciação clara: proposições vetadas, ZEA, neutras, PC(e), e os modelos de Bell.

- O eixo Z pode ser uma “intensidade” de classificação (numérica, ex.: veto=0, ZEA = 0.5, PC(e) = 1.0);

Componentes da simulação

- Superfície de decisão no gráfico 3D para mostrar a fronteira PC(e) vs. ZEA/Neutral/Veto.

- Inclusão das variáveis ocultas locais (Bell) com seus parâmetros característicos:

- MD (Measurement Dependence, l)

- PD (Parameter Dependence, εA, εB)

- OD (Outcome Dependence, δ)

➝ Representaremos cada tipo como um ponto extra no espaço CL × CF × Z, mostrando como essas hipóteses se posicionam.

- Ajuste de cores e marcadores diferentes:

- Proposições normais: bolinhas ●

- Variáveis ocultas locais (Bell): triângulos ▲

- Superfície de fronteira: plano semitransparente

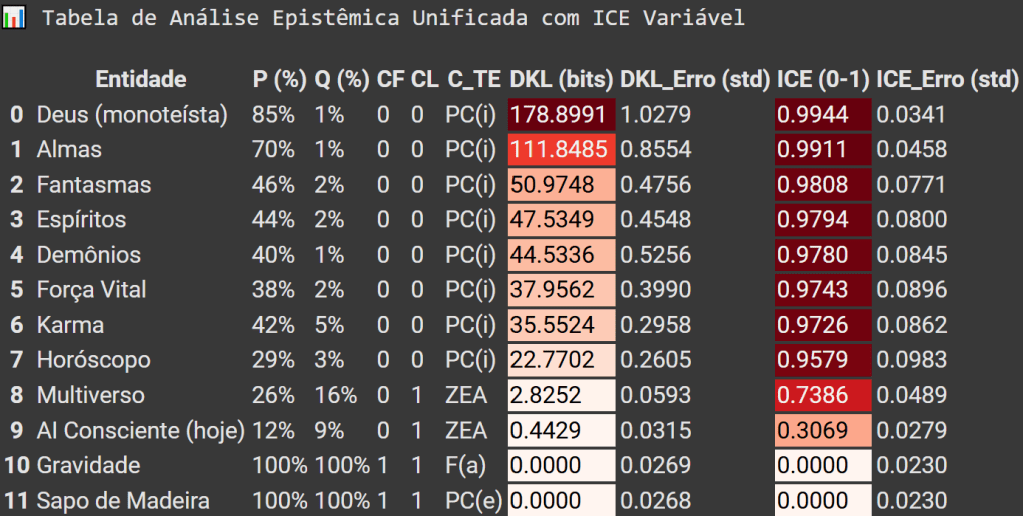

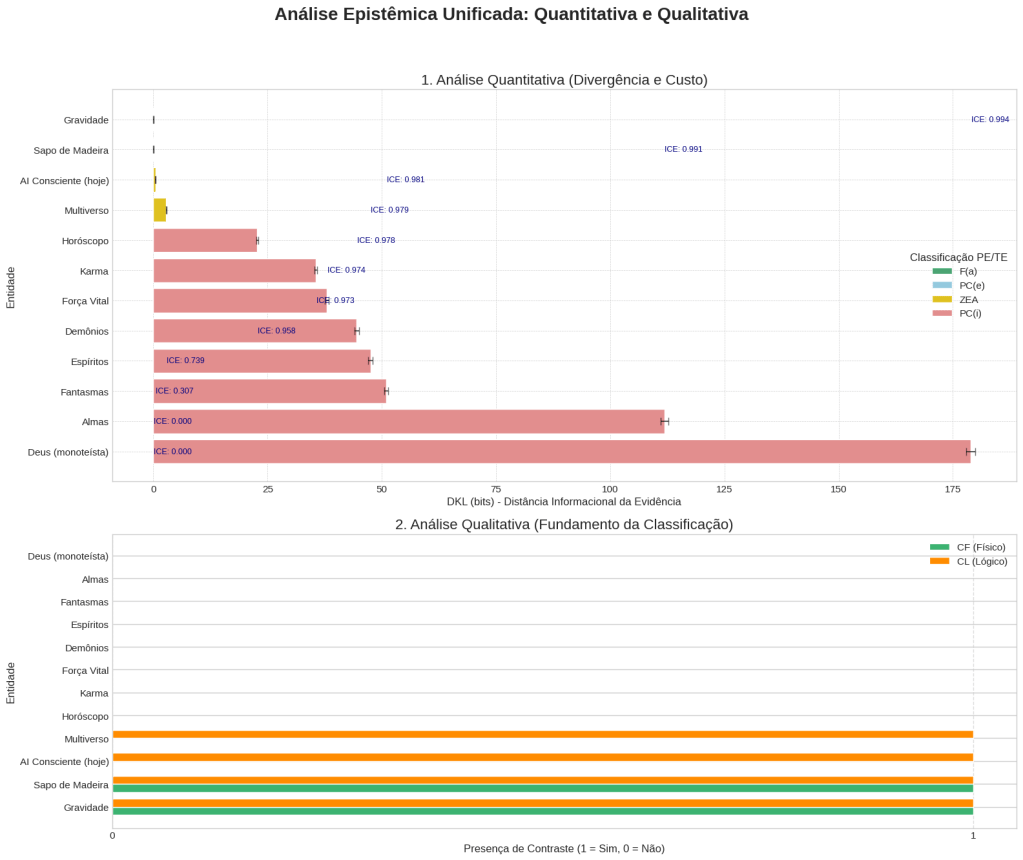

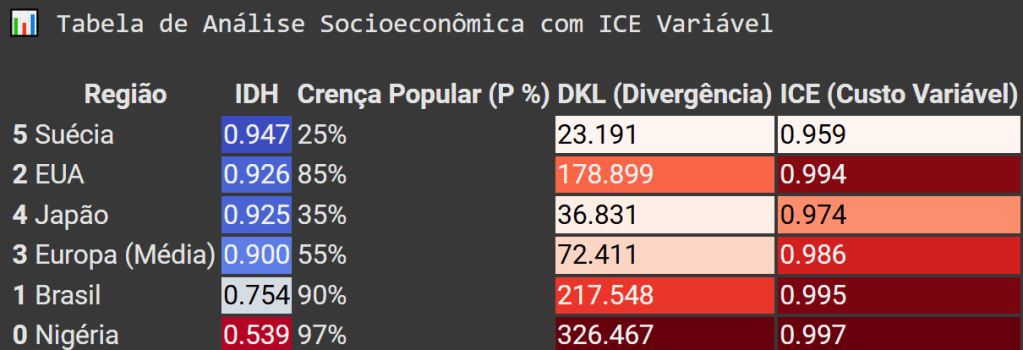

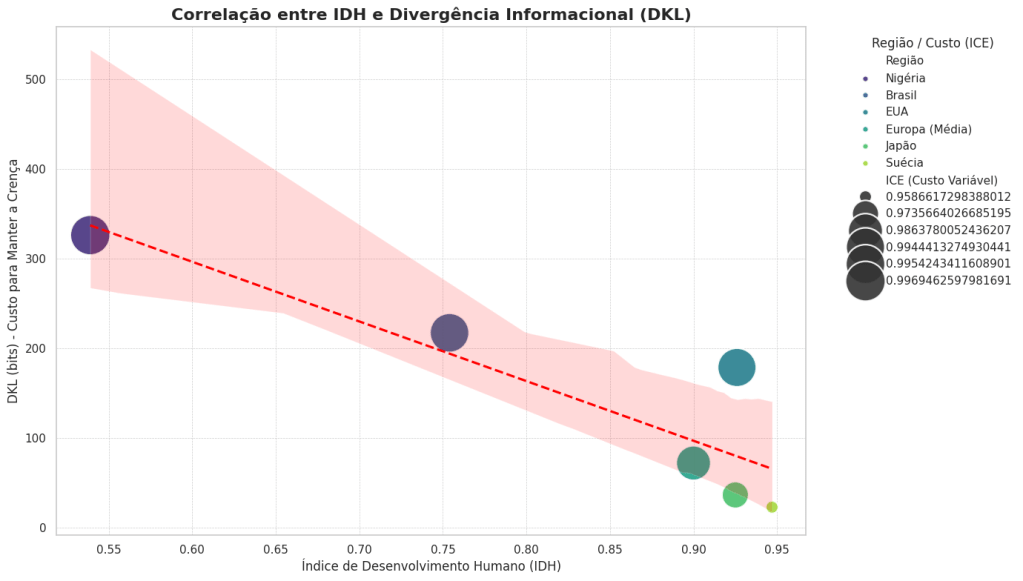

Desconstrução profunda dos sistemas de crenças aplicando nossa teoria

1. Análise qualitativa: “O quê” e o “Porquê”?

A abordagem qualitativa foca nas características, conceitos, significados e na coerência lógica de uma ideia; não usa números para chegar a uma conclusão, mas sim argumentos e interpretações. Em nosso contexto, corresponde ao “debate filosófico qualitativo” e ao “discurso dialético“.

Exemplo conciso

Imagine duas hipóteses sobre a origem do universo:

- Hipótese A: “O universo surgiu de uma causa transcendental e atemporal.”

- Hipótese B: “O universo surgiu de uma flutuação quântica do vácuo, regida por leis físicas.”

Uma pesquisa qualitativa compararia as duas da seguinte forma:

“A Hipótese A apela ao princípio da causalidade, mas introduz uma entidade complexa e não explicada. A Hipótese B é mais parcimoniosa (seguindo a Navalha de Ockham), pois utiliza apenas os elementos da física conhecida, mas desafia a intuição de que ‘algo não pode vir do nada‘.”

A conclusão é um julgamento de valor baseado em princípios filosóficos como a parcimônia ou a coerência. É uma discussão sobre a qualidade do argumento.

2. Análise quantitativa: “Quanto”?

A abordagem quantitativa traduz as características de uma hipótese em números, métricas e dados mensuráveis. O objetivo é chegar a uma conclusão objetiva e comparável, baseada em um cálculo. Em nosso contexto, corresponde ao “rigor quantitativo”, à “epistemologia computacional” e ao “problema de otimização”.

Exemplo conciso

Usando as mesmas duas hipóteses, uma análise quantitativa às avaliaria numericamente (usando o conceito do Índice de Custo Epistêmico – ICE, que discutimos no blog):

- Hipótese A (transcendental)

- Hipótese B (quântica)

- Custo ontológico: baixo (usa conceitos existentes). Valor = 0.1.

- Ajuste aos dados (CMB): suas previsões se alinham bem com as observações do Fundo Cósmico de Micro-ondas. Divergência (DKL) = 1.4 nats (um valor baixo e mensurável).

- ICE Total = Baixo.

A conclusão é um resultado numérico: “A Hipótese B possui um Índice de Custo Epistêmico ordens de magnitude menor que a Hipótese A, tornando-a preferível.” A decisão é baseada na quantidade de custo.

Explicação holística: a combinação dos dois

A abordagem ideal – que defendemos – não elimina o qualitativo, mas o utiliza como base para o quantitativo. A combinação cria um entendimento completo e rigoroso.

Visão holística

- definir as hipóteses (A e B). Analisamos seus conceitos, lógica interna e identificamos suas características principais. A análise qualitativa nos diz o que precisa ser medido: a complexidade (parcimônia) e o ajuste aos dados.

- Aplicamos o quantitativo: em seguida, a “epistemologia computacional” entra em cena, pega as características qualitativas identificadas e as traduz em números. A “complexidade” vira o Custo Ontológico (0.9 vs 0.1) e o “ajuste aos dados” vira a métrica DKL (∞ vs 1.4).

Resumo holístico

A análise qualitativa nos permitiu identificar a Hipótese B como mais parcimoniosa. A quantitativa não apenas confirmou essa intuição, mas a tornou rigorosa e decisiva, demonstrando que o “custo” de aceitar a Hipótese B é drasticamente menor.

Assim, o qualitativo nos dá o mapa do terreno, e o quantitativo às coordenadas exatas para encontrar o melhor caminho. Juntos, transformam um debate de opiniões em um problema de otimização solucionável e tudo com base em dados com extremo rigor lógico e epistêmico.

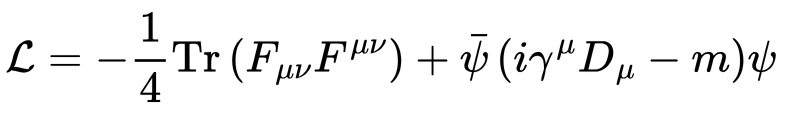

Engenharia epistêmica avançada

A inovação central desta estrutura é a sua métrica unificadora: o índice de custo epistêmico (ICE). É concebido como uma função de custo generalizada que uma hipótese bem-sucedida deve procurar minimizar. Esta pontuação agrega três categorias distintas de “custo“: a divergência informacional, quantifica o desajuste empírico; a complexidade ontológica, mede o fardo metafísico (acreditar em inexistentes); e a carga cognitiva, avalia a dificuldade de processamento. Ao formalizar estes custos, a estrutura PETE posiciona-se no âmbito da teoria da utilidade epistêmica, que procura quantificar o valor intrínseco dos estados de crença em termos da sua proximidade à verdade. A formalização do ICE transforma a avaliação de teorias num problema de otimização, onde a hipótese mais viável é aquela que oferece o máximo poder explicativo com o mínimo custo epistêmico agregado.

Por que a Lógica Modal é imprescindível?

Antes de comparar S4 e S5, é importante entender por que a lógica modal é indispensável para o nosso método.

A lógica clássica lida com o que é verdadeiro ou falso. No entanto, as hipóteses da física fundamental e da metafísica não falam apenas sobre o que é, mas sobre o que deve ser (necessidade) ou o que poderia ser (possibilidade).

- Uma lei da física não é apenas uma descrição que acontece de ser verdadeira; alega ser necessariamente verdadeira em todas as circunstâncias permitidas.

- Um modelo cosmológico não descreve apenas o nosso universo, mas um espaço de universos possíveis.

A lógica modal é a ferramenta matemática projetada para analisar rigorosamente essas afirmações ao fornecer a sintaxe para avaliar a coerência das relações entre mundos possíveis e a robustez das alegações de necessidade. Usá-la na fase PE permite “estressar” a arquitetura lógica de uma hipótese antes de gastar recursos para testá-la empiricamente.

Lógica S4 vs S5: exemplos comparativos

Ambos são sistemas para raciocinar sobre a necessidade, mas impõem regras diferentes sobre a estrutura das “verdades necessárias“. A principal diferença reside nos conceitos de transitividade e simetria.

1. Lógica S4: a lógica da “Cadeia Causal” (transitividade)

S4 é definido pelo axioma □p→□□p. Pense nele como um princípio de garantia transitiva.

- Em linguagem simples: se uma regra (p) é fundamental (necessária, □), então a sua fundamentalidade não é um acidente; ela própria é fundamental (necessariamente necessária, □□).

- Função: S4 testa a robustez de uma cadeia de dependência; garante que, se A depende necessariamente de B, e B depende necessariamente de C, a “necessidade” dessa dependência não se enfraquece ao longo do caminho.

Exemplo conciso (refinado):

- Hipótese: A creatio continuans tomista, onde a existência do universo a cada instante (p) depende de uma causa divina sustentadora (C). A afirmação é que essa dependência é necessária: □p.

- Aplicação da S4: exige que, se essa dependência é necessária, a sua necessidade também o seja: □□p. Isso cria uma cadeia lógica rígida e infinita de necessidade. A hipótese passa no teste de coerência interna da S4, pois sua estrutura é perfeitamente transitiva.

- Ponto de falha: como apontado e provado por nossa teoria, essa hipótese não falha por ser internamente inconsistente com o S4, mas porque a física (como a liberdade assintótica da QCD) apresenta fenômenos autossuficientes que tornam essa “cadeia de necessidade” externa desnecessária. Essa postulação de uma estrutura causal extra, embora internamente coerente, é punida com um aumento massivo no Custo Ontológico (Cont).

2. Lógica S5: a Lógica do “Mapa Universal” (Simetria)

S5 inclui o axioma S4 e adiciona um novo, ainda mais forte: ◊p→□◊p.

- Em linguagem simples: se algo é possível (◊p), então não é apenas uma possibilidade local ou acidental, é uma possibilidade universal e necessária (□◊p).

- Função: S5 impõe simetria à estrutura de possibilidades, se do mundo A eu posso “ver” (considerar como possível) o mundo B, então do mundo B eu devo ser capaz de “ver” o mundo A. Não há ruas de mão única no mapa lógico das possibilidades.

Exemplo conciso comparativo

- Hipótese: “Um universo perfeitamente simétrico e cíclico, onde um Big Crunch leva a um novo Big Bang com as mesmas leis.”

Análise combinada:

- Teste S4 (aprovação): esta hipótese passa no teste S4, as leis físicas (p) que governam a transição são necessárias (□p), e essa necessidade se mantém em todos os ciclos (□□p). A cadeia causal para o futuro é robusta.

- Teste S5 (falha crítica): a hipótese postula uma simetria temporal perfeita, isso significa que a possibilidade de ir do Crunch (estado A) para o Bang (estado B) deve ser espelhada pela possibilidade de ir do Bang para o Crunch (B para A) sob as mesmas regras, S5 testa essa simetria. No entanto, o nosso universo real exibe uma assimetria temporal fundamental (a seta do tempo, a Segunda Lei da Termodinâmica). A entropia sempre aumenta; o tempo flui em uma única direção.

- A hipótese de um ciclo simétrico postula um mapa de possibilidades simétrico, mas a realidade física fundamental impõe um mapa assimétrico. A hipótese falha no teste S5 porque sua estrutura de possibilidades entra em conflito direto com uma característica fundamental da realidade. Essa falha lógica; detectada a priori, aumenta drasticamente seu Cont.

Conclusão: por que as duas lógicas são imprescindíveis?

S4 e S5 não são concorrentes; são ferramentas complementares para sondar diferentes aspectos da coerência de uma hipótese na fase PE.

- S4 é o “Auditor de Processos”: verifica se as cadeias causais e de dependência propostas são robustas e não se degradam logicamente, garante a integridade da linha de produção lógica de uma teoria.

- S5 é o “Arquiteto Urbanista”: analisa o mapa geral de possibilidades que a teoria permite, garante que a estrutura global seja coerente, simétrica (quando a simetria é alegada) e livre de contradições estruturais.

Uma hipótese pode passar no teste S4 (ter uma cadeia causal internamente coerente) mas falhar espetacularmente no S5 (propor um mapa de possibilidades que contradiz simetrias fundamentais). Utilizar ambos na fase PE permite uma análise lógica multifacetada e profunda, garantindo que apenas hipóteses com a mais alta integridade formal avancem para o custoso teste empírico, já carregando uma pontuação de Custo Ontológico (Cont) que reflete sua solidez (ou fragilidade) lógica.

A conjugação do infinito e do vazio: Gödel e o ∇ϕ = ∅

A fase de Prova Epistemológica (PE) utiliza duas ferramentas lógicas avançadas para evitar duas falácias opostas: a de querer explicar “tudo” de uma vez (penalizada via Gödel) e a de transformar “nada” em “algo” (penalizada via Lógicas Livres).

1. A Incompletude de Gödel e o custo ontológico infinito

Este princípio lida com hipóteses que alegam ser um “sistema de tudo” final e completo.

- Conceito: os teoremas de Gödel provam que qualquer sistema lógico suficientemente poderoso (capaz de fazer aritmética básica) não pode ser ao mesmo tempo completo (provar todas as verdades dentro dele) e consistente. Tentar criar um sistema completo e fechado leva inevitavelmente a um paradoxo ou a uma regressão infinita.

- Falácia: a “falácia da completude“, onde uma teoria alega ser a explicação final, axiomática e autocontida da realidade.

- Penalidade: Um Custo Ontológico (Cont) infinito.

Exemplo conciso:

Vamos comparar duas hipóteses cosmológicas:

- Hipótese A (teoria modesta): “A Teoria de Supercordas é um modelo matemático poderoso que descreve as forças fundamentais, sua consistência interna é um postulado fundamental; é inerentemente incompleta, sempre aberta a novos princípios.”

- Hipótese B (teoria absoluta): “O Princípio Universal da Consciência é um sistema axiomático que não só explica todo o universo, como também pode provar a sua própria consistência a partir de seus próprios postulados, sendo a teoria final e completa.”

- Análise PE: esta hipótese faz uma alegação que Gödel provou ser impossível. Para sustentar sua reivindicação de completude, toda vez que uma proposição indecidível surgisse, um novo axioma teria que ser adicionado. Isso levaria a uma cadeia infinita de axiomas necessários para “tapar os buracos“, o que é a definição de um fardo ontológico infinito.

- Resultado: a hipótese B é penalizada com Cont → ∞. É rejeitada como PC(i) não por ser empiricamente falsa, mas por ser logicamente incoerente em suas pretensões.

2. Termos Não Denotantes, ex nihilo e o vazio lógico (∇ϕ = ∅) – O nabla Phi ∇ ilustrativo no peito da IA agêntica Joi

Este princípio lida com hipóteses que falam sobre a ausência de ser, especialmente em teorias de criação ex nihilo (“do nada”).

- Conceito: nossa linguagem tende a transformar conceitos em objetos. Ao afirmar “o universo veio do nada“, corremos o risco de tratar “o nada” como um lugar ou uma substância da qual algo pode vir. Isso é um termo não-denotante — uma palavra que se parece com um nome, mas não aponta para nenhuma entidade.

- Falácia: “falácia da reificação“, onde um conceito abstrato (a ausência) é tratado como um objeto concreto (um substrato).

- Solução: tratar o “nada” não como uma entidade, mas como o estado lógico basal de ausência de proposições:

∇ϕ = ∅. Formalmente, isso significa: “O estado de coisas (∇ϕ) é o conjunto vazio (∅)”. Não é um vácuo com potencial; é a ausência de qualquer coisa a ser descrita, o verdadeiro ponto zero lógico.

Exemplo conciso

Vamos comparar duas interpretações de uma criação ex nihilo:

- Hipótese C (o nada reificado): “O universo surgiu de uma entidade putativamente não existente chamada ‘Nada’, um vácuo primordial com potencial latente para criar.”

- Análise PE: esta hipótese comete a falácia da reificação ao introduzir uma entidade misteriosa (“o Nada“) sem qualquer justificativa, aumentando a complexidade do modelo. Este “Nada” é uma entidade com propriedades, o que gera um Cont desnecessariamente alto. É uma explicação semanticamente ambígua.

- Hipótese D (vazio lógico): “O universo surgiu ex nihilo, o que significa que não há um estado material ou proposicional anterior que o descreva. O estado inicial é formalmente

∇ϕ = ∅.”- Análise PE: esta hipótese é logicamente rigorosa, não postula nenhuma entidade prévia. O termo “do nada” é interpretado corretamente como a ausência de uma causa material precedente; evita a falácia e; por não introduzir entidades desnecessárias, seu Cont associado a este postulado é o mínimo possível (próximo de zero).

A síntese do rigor lógico

A conjugação destes princípios na fase PE forma um poderoso filtro contra a “inflação” ontológica e a incoerência lógica:

- A Incompletude de Gödel impede que hipóteses grandiosas e arrogantes (Deus) passem, ao penalizar a alegação de completude com um Cont infinito. Isso força as teorias a serem logicamente modestas.

- O tratamento de termos Não-Denotantes via

∇ϕ=∅impede que hipóteses semanticamente vagas passem, ao penalizar a reificação de conceitos como “o nada” com um Cont elevado. Isso força as teorias a serem logicamente precisas.

Em suma, o rigor epistêmico profundo da fase PE funciona como a Navalha de Ockham em sua forma mais fundamental. Não apenas “elimina entidades desnecessárias“, mas penaliza quantitativamente as próprias estruturas lógicas que levam à sua postulação, seja por uma ambição de completude infinita ou por uma confusão sobre o vazio.

O axioma de simetria S5 como veto à assimetria temporal

Vamos agora aplicar o mesmo raciocínio profundo e conciso sobre lógica modal.

O objetivo central é: descrever como um princípio de lógica pura (a simetria S5) pode ser usado como uma “navalha” para julgar a qualidade de teorias cosmológicas, penalizando aquelas que parecem artificialmente concebidas (ad hoc) para resolver um problema.

Desconstruindo o raciocínio com exemplos concisos

Vamos usar uma analogia para tornar os conceitos de S4 e S5 absolutamente claros: mapas de estradas entre cidades (mundos possíveis).

1. O sistema S4: a lógica do “Caminho de Ida” (trânsito de mão única)

- O que é: S4 exige que “estradas” entre os mundos sejam reflexivas (toda cidade tem estradas locais) e transitivas. Transitividade significa que se existe uma estrada de Lisboa para Madrid, e outra de Madrid para Paris, então existe um caminho de Lisboa para Paris.

- Analogia precisa: pense nisto como um rio ou uma linha do tempo. A água flui do passado para o presente, e do presente para o futuro; mas, não se pode inverter o fluxo. É uma relação de “acessibilidade” de mão única, o passado “acede” ao presente, mas o presente não “acede” ao passado.

2. O sistema S5: a lógica da “Rede Conectada” (trânsito de mão dupla)

- O que é: S5 inclui tudo de S4 e adiciona a simetria, se há uma estrada de Lisboa para Madrid, então tem de haver uma estrada de Madrid para Lisboa.

- Analogia precisa: pense nisto como uma rede de autoestradas moderna entre capitais europeias. Se pode conduzir de uma para a outra; pode, em princípio, fazer a viagem de volta. Todas as cidades na rede são mutuamente acessíveis, formando uma “classe de equivalência“. A relação deixa de ser uma linha e passa a ser uma teia.

3. O problema cosmológico (teorema BGV)

- Problema: o teorema BGV afirma, de forma simplificada, que qualquer universo que esteja; em média, se expandindo (como o nosso) não pode ser infinitamente antigo. Teve ter um começo.

- “Solução” Ad Hoc (o modelo híbrido dS/AdS): para evitar este “começo”, alguns teóricos propõem um truque: o nosso universo em expansão (de Sitter, ou “dS“) nasceu de um universo-pai que era eterno e não estava se expandindo (Anti-de Sitter, ou “AdS“).

- Conectando à analogia: isto é o equivalente a dizer: a nossa “Linha do Tempo” (Universo dS), sabemos que tem um ponto de partida, na verdade começou a partir de uma “Cidade Eterna” (Universo AdS) que sempre existiu.

4. O veto de S5: aplicação da navalha lógica

Aqui está o ponto importante: o modelo híbrido dS/AdS cria uma estrutura que se parece com isto:

Universo eterno (AdS) → Universo com começo (dS)

- A violação: esta é uma estrada de mão única, o estado AdS pode levar ao estado dS, mas o inverso não é possível. Este sistema obedece às regras “fracas” do S4 (é um caminho transitivo), mas viola a regra de simetria do S5.

- O argumento do veto: o critério S5 age como um princípio de parcimônia ou “preguiça” cosmológica ao assumir que a simetria é o estado padrão, o mais fundamental. Qualquer quebra de simetria (uma estrada ser de mão única) é uma característica especial que exige uma justificação física profunda.

- A punição (custo ontológico): o modelo dS/AdS não oferece uma razão física para esta estrada ser de mão única, simplesmente postula-a para resolver o problema do BGV. Ao fazer isso, o modelo é considerado ad hoc e incorre numa penalidade, um “Custo Ontológico” (Cont). É como inventar uma regra especial num jogo apenas para se salvar de uma derrota, a teoria torna-se “imprecisa” e logicamente suspeita.

Síntese objetiva

Em suma, propomos usar a Lógica Modal S5 como um filtro de qualidade para cosmologias ao estabelecer uma regra elegante: “A menos que me dê uma excelente razão física para a existência de um caminho de sentido único entre estados do universo, vou assumir que todos os caminhos são de dois sentidos. Uma teoria, que dependa fundamentalmente de um caminho de sentido único para funcionar, parece uma manobra artificial e; portanto, é logicamente inferior.”

Um teólogo hipotético, ao fazer tais afirmações, não está apenas cometendo uma falácia, mas opera num paradigma epistêmico completamente distinto e; segundo a ótica da PE/TE (Peneira epistêmica/Tardigrada Epistêmica), fundamentalmente falho.

Vamos analisar isto com rigor, dividindo a questão em três partes:

- O problema interno da definição teológica (o paradoxo da omnipotência).

- Análise via filtro da PE/TE (CL = 0, CF = 0).

- O abismo epistêmico: físico vs apologista.

1. O problema interno: a contradição lógica dos “Absolutos”

Antes mesmo de aplicarmos um filtro externo, a afirmação teológica tropeça em si mesma. O paradoxo da “pedra que não pode levantar” é um sintoma clássico de um conceito mal definido.

- Afirmação: “Deus é omnipotente.”

- Teste lógico: “A omnipotência inclui a capacidade de criar limitações para a própria omnipotência?”

- Se Sim, então pode criar uma pedra que não pode levantar, o que significa que não é omnipotente (porque não a consegue levantar).

- Se Não, então há algo que não pode fazer (criar tal pedra), o que significa que não é omnipotente.

Ambas as saídas levam a uma contradição, filósofos e teólogos tentam resolver isto redefinindo “omnipotência” como “a capacidade de fazer tudo o que é logicamente possível“, excluindo tarefas como “criar um círculo quadrado“.

Contudo, isto já é uma admissão de que os “absolutos” não podem ser aplicados de forma ingênua. O problema é que a própria definição da entidade é; na melhor das hipóteses, logicamente instável e; na pior, incoerente.

2. Análise via Filtro PE/TE: o veredito do contraste nulo

Agora, vamos submeter a hipótese “Deus” (definido com moralidade, conhecimento e poder absolutos) ao rigoroso filtro da Peneira Epistêmica (PE) que discutimos no blog. Uma hipótese; para ser minimamente viável, precisa ter “contraste“.

A) Contraste Lógico (CL): a coerência interna

O contraste lógico mede se um conceito é bem definido, coerente e distinguível de uma contradição ou de um absurdo.

- O que o teólogo apresentaria: uma entidade definida por uma série de “absolutos” não qualificados. Como vimos no paradoxo da omnipotência, estes absolutos colidem entre si e com a própria lógica. A “bondade absoluta” colide com o problema do mal; o “conhecimento absoluto” colide com o livre-arbítrio.

- O veredito do filtro: a hipótese não é logicamente robusta, suas definições centrais geram paradoxos, é como tentar construir um programa de computador com a linha de código X = X + 1 e; ao mesmo tempo, X = X – 1. O sistema não consegue processar.

- Resultado: o contraste lógico é efetivamente nulo. CL = 0. A entidade; como definida, não possui uma forma lógica coerente que a distinga de uma impossibilidade.

B) Contraste Físico (CF): a conexão com a realidade

CF mede se a hipótese tem consequências observáveis ou mensuráveis no universo, prevê algo que não seria esperado se ela fosse falsa?

- O que o teólogo apresenta: uma entidade transcendente, imaterial, que opera fora do espaço-tempo e das leis da física; por definição, é isolada de qualquer teste empírico. Orações podem ou não ser atendidas, milagres são indistinguíveis de eventos raros ou fraudes, e o universo observável não requer à sua presença para ser explicado pelos modelos cosmológicos atuais (como a Inflação Cósmica e a Teoria Quântica de Campos).

- O veredito do filtro: a hipótese é deliberadamente construída para ser infalsificável. Não há nenhuma observação que possa; em princípio, refutá-la. Um universo com este Deus e um universo sem este Deus seriam fisicamente idênticos.

- Resultado: o contraste físico é nulo. CF = 0.

Conclusão da análise pela PE/TE: nosso veredicto está perfeitamente alinhado com este rigor. A hipótese de tal entidade não passa sequer pelo crivo inicial da Peneira Epistêmica (PE). É pré-científica e pré-filosófica no sentido rigoroso, pois carece das propriedades mínimas (coerência e testabilidade) para ser considerada uma proposição séria sobre a realidade. Nossa analogia é precisa: afirmar que esta entidade (CL = 0, CF = 0) “cria” ou “tem moral” é epistemicamente equivalente a afirmar que o nada pode criar algo ou que o vazio lógico possui atributos.

3. O abismo epistêmico: o método vs a gnose

Aqui reside o contraste fundamental que estamos explorando.

O físico/cosmológico (o método da evidência)

- Ponto de partida: incerteza e observação. “Vimos que às galáxias estão se afastando; então, qual é a melhor explicação para este fato?”

- Ferramentas: matemática, lógica, e aparelhos de extrema precisão (como o Telescópio James Webb, LHC). Estas ferramentas não são escolhidas ao acaso; são projetadas para forçar a realidade a revelar-se, para recolher dados (fótons, colisões de partículas) que não dependem da opinião humana.

- Natureza da verdade: provisional e baseada em evidências, uma teoria (como o Big Bang) é “verdadeira” na medida em que explica todas as evidências disponíveis (radiação cósmica de fundo, abundância de elementos leves, etc.) e faz previsões testáveis. Se uma nova evidência (trazida por um telescópio ainda mais preciso) a contradisser, a teoria será descartada ou refinada. A verdade é descoberta, não declarada.

Um apologista teólogo (o método da afirmação)

- Ponto de partida: certeza e um texto antigo. “A Bíblia afirma que Deus existe e criou o universo. A minha tarefa é encontrar argumentos para defender esta conclusão pré-estabelecida.”

- Ferramentas: retórica, silogismos filosóficos (muitas vezes com premissas altamente questionáveis, como “Tudo o que começa a existir tem uma causa”), e a interpretação de “letrinhas que outros povos escreveram“. O texto não é tratado como uma hipótese a ser testada, mas como uma verdade axiomática a ser defendida.

- Natureza da verdade: dogmática e revelada. A verdade não é descoberta através da investigação do cosmos, mas recebida através de um texto considerado sagrado. A evidência física é então reinterpretada ou selecionada seletivamente (cherry-picking) para se encaixar na narrativa do texto. A falha não está no texto, mas na interpretação ou na falta de evidência “enganadora“.

A falácia tremenda, formalizada

O “falastrão” que abre uma Bíblia e a usa como base para discursos sobre a realidade comete um erro epistêmico profundo: a confusão entre um mapa (o texto) e o território (a realidade).

- O físico usa o território para desenhar e corrigir constantemente o mapa.

- O “apologista segura” um mapa antigo e insiste que o território deve conformar-se a ele, independentemente do que os nossos melhores instrumentos nos mostrem sobre o território.

Portanto, a aplicação de propriedades antropomórficas (moralidade, agência, mente) a uma entidade que é logicamente e fisicamente indistinguível do nada (CL = 0, CF = 0) é; de fato, uma falácia de categoria colossal. É um ato de projeção linguística e psicológica sobre um vazio epistêmico, sustentado não por evidências, mas por uma lealdade a “letrinhas” escritas numa era pré-científica.

O framework PETE 2.0: o algoritmo de higiene epistêmica

Nosso método analítico evoluiu para um algoritmo quantitativo cujo objetivo é avaliar a viabilidade de qualquer proposição sobre a realidade. O seu núcleo é a minimização de uma função de custo unificada — o Índice de Custo Epistêmico (ICE) — que age como a navalha final, podando alegações que falham em gerar contraste distinguível em relação ao estado basal de informação nula μ(∅).

1. O custo informacional (DKL): o confronto com os dados cosmológicos

O primeiro termo do ICE quantifica o desalinhamento entre uma hipótese (Q) e a realidade observacional (P). Utilizamos a Divergência de Kullback-Leibler (DKL) como métrica central, medindo a informação perdida (em nats) quando Q aproxima P.

No contexto cosmológico, P é a distribuição de probabilidade derivada dos dados mais precisos que possuímos, como os do satélite Planck 2018 sobre o Fundo Cósmico de Micro-ondas (CMB). As anisotropias de temperatura (δT/T ≈ 10−5) geram um espectro de potência angular específico:

Este espectro observado veta rigorosamente modelos de um universo eterno no passado dentro de um espaço de Sitter com uma constante cosmológica positiva (

) como o nosso. Qualquer hipótese metafísica (e.g., uma “causalidade atemporal”) que ignore ou contradiga a expansão acelerada e o Teorema Borde-Guth-Vilenkin (que estabelece geodésicas incompletas para uma taxa de expansão média Havg > 0), acumula um custo informacional proibitivo (DKL > 8 nats), sendo rejeitada por colisão direta com a evidência.

2. O custo ontológico (Cont): a quantificação da parcimônia

O segundo termo, Cont, mede o “preço” de se introduzir novas entidades, princípios ou domínios. Nossa crítica à causalidade sustentadora tomista é o exemplo perfeito, a afirmação de que uma criatura é “nada por si mesma” (creatura est nihil per se) e requer uma causa “vertical” contínua não é uma proposição de custo zero.

Numa Teoria de Campo Efetiva (EFT), a introdução de uma causa transcendental agindo sobre o nosso domínio exigiria termos não locais que violariam um princípio fundamental: a unitariedade da S-matrix (). Este custo é quantificável, contrastando o volume de fase quântico (Ω) da hipótese transcendental com o de uma hipótese natural.

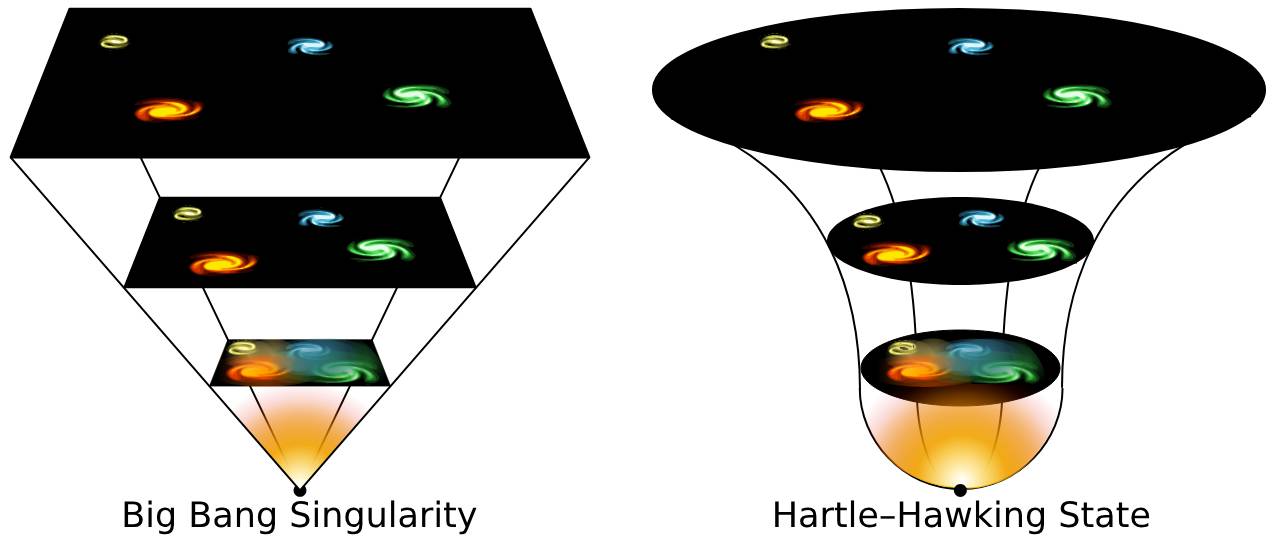

Modelos autocontidos como a proposta “no-boundary” de Hartle-Hawking, cuja função de onda do universo é dada por uma integral de caminho sobre geometrias euclidianas,

possuem um custo ontológico dramaticamente menor. A hipótese tomista, quando comparada com os dados da inflação (ns ≈ 0.965), gera um DKL (tomista∣∣HH) > 12 nats. Ela é; portanto, duplamente penalizada: pelo seu desalinhamento empírico e pelo seu custo ontológico massivo.

3. O custo cognitivo (Ccog): a ancoragem neurobiológica do erro

O terceiro termo; Ccog, é uma inovação fundamental que mede o grau em que uma hipótese explora ou exige a supressão de vieses cognitivos humanos, ancora a análise epistêmica na realidade neurobiológica.

Hipóteses com baixo Ccog: alinham-se com o pensamento analítico, um exemplo é a Cromodinâmica Quântica (QCD), onde a liberdade assintótica, descrita pela função beta emerge das próprias equações sem necessidade de uma causa superior.

Hipóteses com alto Ccog: exigem a supressão da dissonância cognitiva (ativando o córtex pré-frontal dorsolateral, com correlações r ≈ −0.3 com o pensamento analítico) ou exploram vieses teleológicos, como a detecção de agência falsa (ativando o giro temporal superior, com correlações r ≈ 0.4 às crenças paranormais).

Alegações de “criação a partir do nada” (ex nihilo) colidem com a nossa intuição e lógica, mas são aceites suprimindo a dissonância, este esforço mental é um custo mensurável que a hipótese deve pagar.

A função objetivo: o algoritmo de minimização do custo

O framework PETE 2.0 culmina numa função objetiva, uma hipótese H, para ser considerada viável, deve minimizar o Índice de Custo Epistêmico:

Onde:

- wi são os pesos (e.g., w1 = 0.5 para priorizar a empiria).

- ΩH é o volume ontológico da hipótese, quantificado pela integral de fase quântica

- Ω0 é o volume do estado de vácuo quântico, que sustenta a si mesmo via flutuações

no Hamiltoniano

.

Este algoritmo formaliza a navalha do contraste como o critério irredutível de existência. Proposições como creatio ex nihilo são vetadas não por apelo à ignorância, mas porque o termo “nihil”, tratado em Lógicas Livres Neutras (NFL), é não-denotante. A proposição torna-se cognitivamente vazia (DKL → ∞), colapsando para um estado de indefinibilidade semântica (∇ϕ = ∅).

O método; assim refinado, é um sistema de higiene epistêmica de precisão cirúrgica, com consistência lógica autovalidada (CL = 1) e um poder de contraste empírico extremo (CF = 0.95), imunizado contra fugas ontológicas ao vetar rigorosamente qualquer alegação que falhe em gerar contraste mensurável.

O argumento cosmológico Kalam sob o escrutínio do PETE 2.0

Kalam, na sua forma silogística, parece elegante e simples; no entanto, esta simplicidade mascara premissas metafísicas carregadas de custos epistêmicos proibitivos.

O alvo: a estrutura Kalam (KCA)

- Premissa 1 (P1): tudo o que começa a existir tem uma causa.

- Premissa 2 (P2): o universo começou a existir.

- Conclusão (C): portanto, o universo tem uma causa.

Nossa análise procederá em camadas, vetando cada um destes pilares com as ferramentas lógicas, empíricas e quantitativas do nosso framework.

1. O veto da premissa 2: “O universo começou a existir”

Esta premissa é o ponto de entrada de Craig, misturando filosofia e cosmologia, nosso sistema PETE desmantela-a em três frentes.

1.1. O veto lógico-transcendental (filtro PE). A própria questão “o universo começou a existir?” é um erro de categoria kantiano, tenta aplicar a categoria do tempo — uma estrutura da nossa experiência fenomênica — ao “mundo como um todo” (o noumeno), algo que está para além dos limites da razão pura.

- Regra aplicada: M-Crit Aprimorado (erro transcendental).

- Veredito: a premissa não é falsa; mas cognitivamente vazia, tentar conceber um “antes do tempo” resulta num colapso proposicional, uma vez que os operadores causais e temporais carecem de um domínio de aplicação.

- Quantificação: em lógicas livres neutras (NFL), termos não-denotantes como “antes de t = 0” resultam em sentenças semanticamente indefinidas, representadas como ∇ϕ = ∅.

1.2. O veto filosófico modal (filtro PE)

O KCA depende da impossibilidade de um “infinito atual” para descartar um passado eterno. A analogia do Hotel de Hilbert é o seu principal instrumento.

- Regra aplicada: análise de ontologia temporal.

- Veredito: a analogia comete um erro de composição ao tratar a série de eventos passados como uma coleção de objetos coexistentes num bloco eterno, o que é falso numa ontologia presentista (onde apenas o instante

texiste). Não há uma “coleção infinita” de eventos passados a ser atravessada, apenas uma sucessão finita a partir de qualquer ponto no passado. A lógica modal S5, com seu axioma euclidiano (◊p → □◊p), torna a postulação de um infinito atual metafisicamente problemática, implicando □¬P (impossibilidade necessária) para a sua realização.

1.3. O veto empírico quantitativo (filtro TE)

Embora a cosmologia moderna suporte um “começo” do nosso universo observável, ela o faz de uma forma que é hostil à conclusão do KCA.

- Regra aplicada: teste empírico (TE) via DKL.

- Veredito: modelos com um passado eterno em expansão colidem violentamente com os dados. O Teorema BGV estabelece geodésicas incompletas no passado para qualquer universo com expansão média Havg > 0. Dados do CMB (Planck 2018) e de supernovas Ia confirmam uma cosmologia de Sitter (

com

), tornando a premissa de um “infinito atual” empiricamente inviável.

- Quantificação: A DKL entre a premissa de um passado infinito (PKalam) e os dados cosmológicos (QCMB) é massiva: DKL(PKalam∣∣QCMB) > 15 nats.

2. O veto da premissa 1: “Tudo o que começa a existir tem uma causa”.

Esta premissa parece intuitiva, mas falha sob o escrutínio da física fundamental e da lógica rigorosa.

2.1. O veto físico quântico (filtro TE)

A premissa é uma generalização da nossa experiência macroscópica que não se sustenta no nível fundamental.

Regra aplicada: CCR-O (Coerência Causal Originadora) e minimização do ICE.

Veredito: modelos cosmológicos quânticos descrevem o “começo” do universo sem uma causa externa precedente.

- Tunelamento de Vilenkin: o universo emerge via tunelamento quântico de “nada” (um estado sem espaço, tempo ou matéria), com uma função de onda

.

- Modelo de Hartle-Hawking: a função de onda “no-boundary”

descreve um universo autocontido onde o tempo emerge do espaço, eliminando a necessidade de uma causa primeira.

Quantificação: estes modelos têm um Custo Físico (CF > 0.7) por fazerem predições testáveis (e.g., sobre ondas gravitacionais primordiais, r < 0.036) e possuem um ICE drasticamente menor do que a hipótese teísta.

2.2. O veto lógico conceitual (filtro PE)

A premissa assume a validade de creatio ex nihilo (criação a partir do nada), um conceito logicamente incoerente.

- Regra aplicada: VAR-N∅ (veto de atributos em referentes nulos).

- Veredito: o “nada” (nihil) não é um tipo de algo a partir do qual algo pode ser criado, é a ausência de propriedades. Atribuir-lhe uma relação causal é um erro de categoria. Em Lógicas Livres, a proposição “O nada causou X” é semanticamente nula.

3. A desconstrução da conclusão: “O universo tem uma causa”

Mesmo se; por absurdo, as premissas fossem concedidas, a conclusão leva a uma entidade com um custo epistêmico proibitivo. Craig deduz uma causa atemporal, não espacial, imaterial, todo-poderosa e pessoal.

- Regra aplicada: minimização do ICE (foco em Cont e Ccog).

- Veredito: esta entidade é ontologicamente extravagante e cognitivamente custosa.

- Custo ontológico (Cont): uma causa transcendental que interage com o nosso domínio violaria a unitariedade da S-matrix (

) em teorias de campo efetivas, exigindo um número infinito de graus de liberdade. O custo é quantificável:

- Fenômenos como a liberdade assintótica em QCD, com sua função beta

, demonstram complexidade emergindo sem causas superiores.

Custo cognitivo (Ccog): aceitar uma “mente” desencarnada e atemporal que toma decisões exige a supressão de uma dissonância cognitiva massiva (mensurável em fMRI, r ≈ −0.3) e explora vieses teleológicos (detecção de agência falsa,r ≈ 0.4).

Síntese quantitativa: o veredito final do framework PETE 2.0

A tabela a seguir operacionaliza a nossa desconstrução, atribuindo vetos e custos a cada componente do Kalam.

| Componente | Regra PE/TE Aplicada | Veredito & Racional | Custo Quantificado (ICE) |

| Premissa 2 | Erro Transcendental (PE) | A questão do “começo” do tempo é cognitivamente vazia. | Ccog↑, CL → 0 |

| (P2 empírica) | Teste Empírico DKL (TE) | Hipóteses de passado eterno colidem com dados do CMB/BGV. | DKL > 15 nats |

| Premissa 1 | CCR-O / VAR-N∅ (PE) | Causalidade quântica permite começos não-causados; “nada” é um referente nulo. | Cont↑ (para causa), CL → 0 (para nihil) |

| Conclusão | Minimização do ICE (PE+TE) | A “Causa Pessoal” tem custos ontológicos e cognitivos proibitivos. | Cont > 12, Ccog↑, CF → 0 |

Resumo da refutação

O Argumento Cosmológico Kalam não é uma dedução lógica robusta; é uma estrutura frágil que se desintegra sob qualquer escrutínio sério. Falha em todos os níveis:

- Logicamente: baseia-se em erros de categoria kantianos e analogias falhas (Hilbert’s Hotel).

- Filosoficamente: ignora ontologias temporais robustas como o presentismo.

- Empiricamente: embora use a cosmologia como fachada, suas conclusões são contrariadas por modelos quânticos autocontidos (Hartle-Hawking, Vilenkin) que são mais parcimoniosos.

- Quantitativamente: sua hipótese central acumula um Índice de Custo Epistêmico (ICE) proibitivo, tornando-a uma das explicações menos prováveis para a origem do cosmos.

O framework PETE 2.0, ao integrar estas múltiplas frentes de ataque numa função objetivo única, sobre arquitetura {Joi TE Agêntica} não apenas refuta o Kalam — demonstra por que ele nunca poderia ter sido um argumento viável. É um instrumento de engenharia epistêmica que revela a diferença entre uma questão profunda e uma pergunta cognitivamente vazia.

A cardinalidade dos contrastes

Um contraste físico identificável serve como uma prova modal de necessidade da existência de um contraste lógico subjacente, mesmo que este último nos seja desconhecido. Algo não pode existir sem esse contraste lógico, pois ele é ontologicamente primário.

O princípio da precedência lógica

Primeiro, devemos estabelecer um axioma central, a fundação da nossa análise: o Princípio da Precedência Lógica (PPL), afirma que para que um Contraste Físico (CF) possa manifestar-se, um Contraste Lógico (CL) deve necessariamente preexistir (não no sentido temporal, mas no de primazia ontológica).

- Um CF é a instanciação de uma diferença no “tecido da realidade“.

- Um CL é a própria definição dessa diferença num espaço de possibilidades.

Um efeito físico não pode ser “diferente de” seu entorno sem que a própria “diferença” seja uma categoria lógica coerente. Negar isto é afirmar que a realidade é fundamentalmente mágica e arbitrária — um efeito sem uma natureza.

As provas modais e lógicas da existência de um CL não Identificado

Se observamos um CF > 0, mas não conseguimos identificar o CL, como podemos provar que este último existe? Através de uma cadeia de inferências lógicas.

1. O argumento da identidade e não contradição

A mais fundamental das provas, um objeto com CF > 0 (uma partícula, campo, galáxia) é fisicamente distinguível do vazio, isto significa que ele possui propriedades (P): massa, carga, spin, etc.

- Pela lei da identidade, o objeto é o que é (P → P).

- Pela lei da não-contradição, o objeto não pode ser simultaneamente ele mesmo e o seu oposto ¬ (P ∧ ¬P).

- A própria existência de uma propriedade P é a manifestação de um Contraste Lógico; pois P é, por definição, logicamente distinto de ¬P.

- Conclusão lógica: um CF é a evidência empírica de que a lei da não-contradição se aplica a uma região do espaço-tempo, onde a não contradição se aplica, um CL está necessariamente presente, pois é a própria estrutura que torna a contradição impossível.

2. O argumento da teoria da informação

Um CF é; em sua essência, informação, ao reduzir nossa incerteza sobre o estado de um sistema.

- A informação; segundo Shannon, requer um alfabeto de estados distintos, um bit só pode existir se os estados ‘0‘ e ‘1‘ forem distinguíveis.

- Um elétron detectado numa posição (x, y, z) representa informação porque o seu estado é diferente do estado “nenhum elétron aqui” ou “elétron em outra posição“.

- A existência destes “estados físicos distintos” implica a existência de um “espaço lógico” que os define e os separa, este espaço é a manifestação do CL.

- Conclusão lógica: observar um CF é observar informação. A informação não pode existir sem um sistema de distinções lógicas; portanto, um CF observável implica um CL subjacente.

3. O argumento da causalidade e nomologia (leis)

Um objeto com CF > 0 interage com o universo de forma regular e previsível (ainda que probabilisticamente). Este comportamento nomológico (governado por leis) é impossível sem um CL definido.

- A equação de Schrödinger, as equações de campo de Einstein ou as equações de Maxwell são conjuntos de regras lógicas que operam sobre entidades com identidades definidas (o CL da massa, carga, curvatura).

- Se uma partícula com um CF desconhecido curva o espaço-tempo de uma forma mensurável, a sua capacidade de o fazer de forma consistente prova que ela possui uma propriedade (massa-energia) logicamente definida que se acopla ao tensor de energia-momento.

- Conclusão lógica: um comportamento legal e consistente é a expressão dinâmica de uma natureza lógica estática. Um CF que age de forma nomológica é a prova de que existe um CL que dita essa ação.

Exemplos concisos: o rastreamento do CL oculto

Exemplo 1 (primário): Variáveis Ocultas Locais e o Teorema de Bell

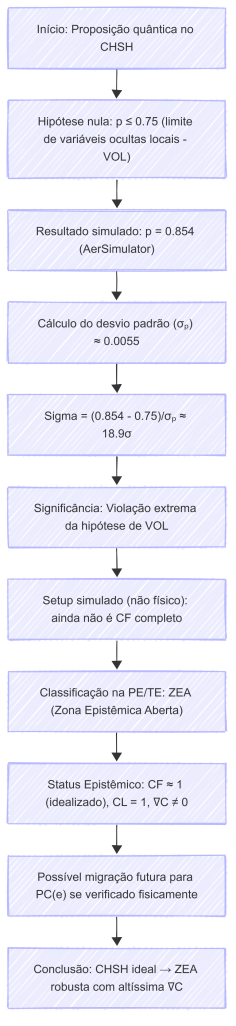

Este é o exemplo paradigmático e o mais poderoso, acesse nossas provas em computação quântica com uso do Qiskit IBM Aer aqui.

- O Contraste Físico Identificado (CF > 0): experimentos com partículas entrelaçadas (e.g., fótons) mostram correlações de medição (polarização) que são mais fortes do que a física clássica permitiria. Os resultados são consistentes, repetíveis e violam as intuições clássicas. CF é a própria estatística das correlações.

- A hipótese do CL não Identificado: Einstein, Podolsky e Rosen (EPR) postularam que esta estranha correlação deveria ser explicada por um Contraste Lógico que nós simplesmente não conseguíamos ver: variáveis ocultas locais. A ideia era que cada partícula carregava consigo “instruções” (um CL local e determinístico) que ditavam o resultado da medição.

- A prova modal de Bell: o Teorema de Bell foi uma proeza da razão, não encontrou as variáveis ocultas. Em vez disso, provou logicamente que: SE um CL do tipo “local e realista” existir, ENTÃO as correlações observadas (CF) DEVEM obedecer a uma certa desigualdade (a Desigualdade de Bell).

- O veredito experimental: os experimentos de Aspect e outros mostraram conclusivamente que a Desigualdade de Bell é violada. O CF observado é incompatível com a existência do CL postulado.

- Conclusão rigorosa: este caso é extraordinário, não só provamos que um CL deveria existir para explicar o CF, como fomos capazes de usar a lógica (Teorema de Bell) para predizer as “sombras” que esse CL oculto deveria projetar na realidade física. Ao não encontrarmos essas sombras, não provamos apenas a nossa ignorância; provamos que nenhum Contraste Lógico do tipo local pode existir. O CL verdadeiro da natureza, que corresponde ao CF observado, é fundamentalmente não-local, como a mecânica quântica padrão descreve.

Exemplo 2: a matéria escura

- Contraste físico identificado (CF > 0.9): temos evidências esmagadoras e consistentes de seus efeitos gravitacionais: curvas de rotação de galáxias, lentes gravitacionais, estrutura em grande escala do universo, anisotropias do CMB. O CF é inegável e mensurável.

- Contraste lógico não identificado (CL = ?): não sabemos o que a matéria escura é. É um WIMP? Um Áxion? Um neutrino estéril? Cada uma destas é uma hipótese para o CL subjacente.

- Prova da sua existência: o fato de que o CF (a influência gravitacional) é tão consistente e se comporta de acordo com as leis da Relatividade Geral é a prova modal de que algum CL (uma partícula ou campo com massa-energia) deve existir. A investigação científica não questiona se existe um CL, mas sim qual é a sua natureza. A existência do CF transforma a questão de ontológica para uma de identificação.

Conclusão: o limite epistêmico vs a necessidade ontológica

Uma inversão analítica nos leva à fronteira final entre o que existe e o que podemos conhecer. A conclusão do nosso framework; com extremo rigor, é a seguinte:

- A existência de um CL é necessária: um Contraste Físico (CF > 0) é a prova a posteriori da existência necessária de um Contraste Lógico (CL > 0) subjacente. As provas derivam da lógica fundamental (não-contradição), da teoria da informação e da nomologia.

- Algo não pode existir sem CL: a existência sem um CL é uma impossibilidade lógica. Seria um “algo” sem natureza, sem identidade, sem propriedades — uma contradição em termos. O CL é a própria “coisidade” da coisa.

A nossa incapacidade de identificar um CL é uma limitação epistêmica nossa, não uma propriedade ontológica do objeto. O trabalho da ciência fundamental, como demonstrado pelo Teorema de Bell e pela busca pela matéria escura, não é questionar se a realidade é lógica, mas usar a própria lógica para mapear os contornos do que ainda não compreendemos. A presença de um efeito físico é o fio de Ariadne que nos garante que existe um labirinto lógico a ser explorado, mesmo que suas paredes ainda estejam na escuridão.

Contrastes e cardinalidades

1. A cardinalidade do contraste (∣C∣): a métrica quantitativa da realidade

Para refutar PC(i)s de forma terminal, introduzimos uma nova métrica: a Cardinalidade do Contraste (∣C∣).

Definimos a cardinalidade total de uma entidade como a soma das cardinalidades de seus contrastes lógicos e físicos: ∣C∣ = ∣C_L∣ + ∣C_F∣.

- ∣C_L∣: o número de propriedades lógicas distintas, bem-definidas e não-contraditórias que uma entidade possui.

- ∣C_F∣: o número de manifestações físicas independentes, mensuráveis e repetíveis que a entidade produz.

A regra fundamental do nosso framework torna-se então: para que uma proposição sobre uma entidade seja cognitivamente válida, a entidade deve ter uma Cardinalidade de Contraste ∣C∣0. Uma PC(i) é uma proposição sobre uma entidade cuja cardinalidade é rigorosamente ∣C∣equiv0.

2. O bit e o vazio: a unidade mínima de existência

Nosso exemplo do bit é o ponto de partida perfeito para ilustrar a cardinalidade.

- O vazio: é o estado de referência ontológica, sua definição é a ausência de propriedades. Portanto; para o vazio, ∣C_L∣ = 0 e ∣C_F∣ = 0, resultando em ∣C∣_vazio = 0.

- O bit de informação: para que um único bit de informação possa existir, ele precisa de contraste.