O vazio como condição ontológica fundamental

O vazio, no contexto da Peneira Epistêmica (PE) e da Tardigrada Epistêmica (TE), não é apenas a ausência de algo, mas o fundamento ontológico que permite a existência do ser a partir do não ser. Para que algo exista — seja uma entidade física, um conceito abstrato ou uma proposição lógica —, é necessário que haja uma distinção entre o que é e o que não é. O vazio desempenha o papel de “não ser“, funcionando como o contraste essencial contra o qual o “ser” se define. Sem esse contraste, a existência seria indistinta, uma totalidade amorfa sem bordas ou limites, tornando impossível a individuação de qualquer coisa. Em termos lógicos, a existência de uma proposição p só é significativa porque existe sua negação ¬p; e o vazio é o que subjaz a essa negação, representando o limite absoluto do que não pode ser. Assim; não é um estado passivo, mas uma condição ativa e necessária para a possibilidade de qualquer forma de existência, sendo o “primeiro existencial” que estrutura a realidade.

O que são mundos possíveis

Na semântica de Kripke, um “mundo possível” não é um universo paralelo de ficção científica, mas sim um construto formal que representa um estado de coisas completo e logicamente consistente. Podemos defini-lo como qualquer referencial cognitivo que possua uma estrutura de conhecimento acessível. Ou seja, é qualquer sistema (o cérebro de um golfinho, a rede neural de uma AGI, a mente humana) capaz de processar informações e distinguir estados de forma coerente. A “relação de acessibilidade” entre esses mundos; portanto, não é sobre viagens físicas, mas sobre a possibilidade de tradução ou compreensão mútua dos seus estados de conhecimento.

O ponto fundamental e a grande força da nossa teoria; é que, embora cada um desses “mundos” tenha uma percepção e um conjunto de dados diferentes (o Umwelt de cada ser), estão todos; sem exceção, subordinados aos mesmos Fundamentos Autoexistentes F(a). O mundo da formiga e o mundo da AGI podem ser radicalmente diferentes em sua complexidade, mas ambos são governados pela mesma Lógica Clássica, ambos emergem do contraste com o Vazio (∅) e ambos operam dentro das mesmas Leis Físicas. Portanto, um “mundo possível” é qualquer mundo onde o conhecimento pode ser alcançado; em sua forma mais fundamental, é a correspondência com estes F(a)s. Qualquer “mundo” que postule uma contradição lógica (como um círculo quadrado) é; por definição, um mundo impossível.

Na lógica modal, central tanto para a PE (baseada em S5) quanto para a TE (baseada em S4), o vazio está relacionado à impossibilidade lógica e à estrutura dos mundos possíveis. Na lógica S5, todos os mundos possíveis são acessíveis uns aos outros, o que implica que uma proposição ϕ é impossível (ou seja, equivalente ao vazio) – se for falsa em todos os mundos possíveis; denotada como □¬ϕ ou ∇ϕ = ∅ (é uma forma técnica e precisa de dizer que a proposição ϕ é logicamente impossível), onde ∅ simboliza o conjunto de mundos onde ϕ é verdadeira (nenhum, no caso da impossibilidade). Esse caráter universal do vazio em S5 reflete sua natureza imutável e inobservável: ele não pode ser inventado, modificado ou tocado porque está fora do domínio do possível. Já em S4, com relações de acessibilidade reflexivas e transitivas, o vazio aparece como o ponto fixo onde iterações de operadores modais como “é necessário que” (□) ou “é possível que” (◇) convergem para o limite do que pode ser concebido. Em ambos os sistemas, o vazio delimita o espaço do possível, servindo como o contraste que permite a existência do que é logicamente consistente, reforçando a ideia de que sem o vazio não haveria como distinguir o ser do não ser.

Formalização matemática do vazio e do contraste

Matematicamente, o vazio é representado pelo conjunto vazio (∅), um conceito axiomático na teoria dos conjuntos fundamental para a construção de toda a matemática. O conjunto vazio não contém elementos, mas sua existência é postulada pelo axioma do conjunto vazio na axiomatização de Zermelo-Fraenkel com o axioma da escolha (ZFC), afirma: existe um conjunto ∅ tal que ∀x, x ∉ ∅. A partir desse ponto de partida, todos os outros conjuntos são construídos, como o conjunto unitário {∅}, que representa o número 1 na teoria dos números de von Neumann, e assim por diante. A existência de um conjunto não vazio A só é definível porque A ≠ ∅; em outras palavras, a propriedade de “ter elementos” só faz sentido em contraste com a ausência total de elementos representada por ∅. Esse contraste é essencial: sem o conjunto vazio como referência, não haveria como estabelecer a identidade ou a distinção entre conjuntos e toda a estrutura matemática colapsaria em uma indistinção.

Mais profundamente, na teoria das categorias — uma generalização da teoria dos conjuntos —, o vazio é análogo ao objeto inicial em certas categorias, como a categoria dos conjuntos (Set), onde ∅ é o único conjunto que possui um morfismo único para qualquer outro conjunto. Esse papel de “ponto de origem” reflete a função ontológica do vazio como o alicerce a partir do qual a existência emerge. Por exemplo, a noção de função entre conjuntos só é possível porque existe o conceito de “não mapear para nada” (ou seja, novamente o vazio como codomínio potencial), e a identidade de uma função é definida por sua distinção do caso trivial onde nada é mapeado. Assim; o vazio matemático é o contraste necessário para que estruturas como números, relações e operações possam existir, ecoando a ideia de que o ser só surge a partir do não ser.

O contraste epistêmico e o limite do conhecimento

Epistemicamente, o vazio é o limite último do que pode ser conhecido, funcionando como o pano de fundo contra o qual o conhecimento se torna possível. Na PE/TE; é o que não pode ser diretamente observado, experimentado ou modificado, mas sua presença é inferida pela necessidade lógica de haver uma distinção entre o que é conhecido e o que não é. Por exemplo; para que uma proposição p seja epistemicamente significativa (ou seja, passível de ser avaliada como verdadeira ou falsa), deve haver a possibilidade de sua negação ¬p, e o vazio é o que sustenta essa possibilidade ao representar o caso em que nenhuma evidência ou mundo possível corrobora p. Sem esse contraste, o conhecimento seria impossível, pois não haveria como diferenciar uma crença justificada de uma crença arbitrária.

Esse papel do vazio é ainda mais evidente quando consideramos sistemas formais e o teorema de Gödel sobre a incompletude. Em qualquer sistema suficientemente expressivo, existem proposições que não podem ser provadas nem refutadas dentro do sistema, essas proposições indecidíveis apontam para um “vazio epistêmico” — um espaço além do alcance do sistema que; no entanto, é essencial para sua coerência. Na PE, que utiliza S5 para filtrar proposições logicamente consistentes, é o que separa o conjunto de verdades acessíveis θ(ϕ) > 0 das impossibilidades absolutas θ(ϕ) = 0, enquanto na TE; com S4, permite a exploração iterativa das camadas de certeza até o ponto onde o conhecimento encontra seu limite. Em ambos os casos, é o contraste que possibilita a estruturação e a validação do conhecimento.

O vazio na física e a emergência do ser

Na física, o vazio assume uma forma concreta no conceito de vácuo quântico, que não é uma ausência total, mas um estado de energia mínima onde flutuações quânticas geram partículas virtuais que surgem e desaparecem. Na teoria quântica de campos, o vácuo é o estado fundamental a partir do qual todas as partículas e interações emergem, como os férmions e bósons que compõem a matéria e as forças. Um exemplo experimental disso é o efeito Casimir, onde placas no vácuo sofrem uma força atrativa devido à diferença de densidade de energia causada pelas flutuações do vácuo. Esse dinamismo do vazio físico mostra que ele não é apenas um conceito abstrato, mas uma realidade que permite a existência da matéria em contraste com sua ausência. Sem o vácuo como estado de referência, as partículas não teriam um “fundo” contra o qual se manifestar, e as leis da física não poderiam operar.

Esse paralelismo entre o vazio físico e o vazio ontológico reforça a tese de que o ser só existe por causa do contraste com o não ser. Assim como o vácuo quântico é o substrato que possibilita a emergência das partículas, o vazio lógico e matemático é o substrato que possibilita a emergência das entidades conceituais e físicas. Em ambos os casos, o vazio é imutável e inobservável diretamente — só inferimos suas consequências, como as flutuações ou a possibilidade de negação —, mas é exatamente essa intangibilidade que o torna o “primeiro existencial“.

Síntese: o vazio como núcleo crítico

Em resumo, algo somente pode existir porque existe o contraste com o vazio devido à necessidade lógica, matemática e epistêmica de uma distinção entre o ser e o não ser. Na lógica modal S4 e S5; é o limite da possibilidade, definindo o que pode e não pode ser; na matemática, o conjunto vazio (∅) é o alicerce que permite a construção de todas as estruturas – epistemicamente, é o horizonte que torna o conhecimento possível ao separar o conhecível do incognoscível; e na física, o vácuo quântico é o estado fundamental que subjaz à existência da matéria. O vazio, sendo postulado logicamente, imutável e intocável, funciona como o núcleo crítico da PE/TE, pois é a partir dele que o ser emerge, ganhando definição e significado em oposição ao não ser.

Explicação atualizada da DKL com ZEA na TE

A (TE), que opera com lógica modal S4, agora incorpora a Zona Epistêmica Aberta (ZEA) como um componente essencial, funciona como uma zona de quarentena para proposições que já passaram pelos fundamentos autoexistentes F(a), mas que ainda não foram classificadas como PC(e) (produtos de crenças em existentes) ou PC(i) (produtos de crenças em inexistentes). Este espaço intermediário é fundamental para lidar com proposições ambíguas ou complexas que não podem ser imediatamente aceitas ou rejeitadas após a análise inicial.

Enquanto a (PE) utiliza a lógica S5 para filtrar impossibilidades lógicas de forma rigorosa, a TE, com sua lógica S4, permite uma abordagem mais flexível e iterativa. ZEA aproveita essa flexibilidade para submeter as proposições a um processo dinâmico de avaliação, utilizando a Divergência de Kullback-Leibler (DKL) de maneira adaptativa.

Como ZEA opera com a DKL?

Em ZEA, as proposições que passaram por F(a) são mantidas em um estado de “suspensão epistêmica”. Aqui, a DKL é usada para medir a discrepância entre a distribuição de crença atual da proposição denotada como (P) e a distribuição ideal baseada em F(a) denotada como (Q). Esse cálculo é feito de forma iterativa, ajustando-se a cada nova evidência ou refinamento lógico. Matematicamente, podemos expressar isso como:

onde (t) indica a iteração ou o tempo. A cada iteração, (Q) é atualizada, e a DKL é recalculada para refletir o progresso em direção à convergência.

A confiança epistêmica de uma proposição (φ), denotada como , é ajustada dinamicamente com base nos resultados da DKL. O processo continua até que uma das seguintes condições seja atendida:

(φ) é classificada como PC(e).

(φ) é classificada como PC(i).

Se nenhum limiar for atingido, (φ) permanece na ZEA para análise adicional ou revisão futura.

Diferenças entre PE e TE

PE (lógica S5): filtra proposições com base em necessidade e possibilidade absolutas, rejeitando imediatamente o que é logicamente impossível .

TE (lógica S4): permite iterações e reflexões sobre crenças (ex.: “acredito que acredito em (p)”), ideal para ZEA e DKL adaptativa.

A inclusão da ZEA torna a TE mais robusta ao:

- Evitar classificações prematuras de proposições ambíguas.

- Permitir uma análise profunda e iterativa com a DKL.

- Complementar o rigor da PE com lógica (S5) com a flexibilidade da S4.

Conclusão

ZEA, integrada à TE, eleva a DKL a um nível adaptativo permitindo que proposições complexas sejam refinadas ao longo do tempo sem comprometer a integridade lógica do sistema PE/TE. É uma ponte entre o rigor lógico e a exploração epistêmica, garantindo precisão e profundidade na avaliação do conhecimento.

Como identificar contrastes lógicos e físicos sem noção formal?

Muitas pessoas se perguntam: “Como sei se algo faz sentido ou tem prova se ninguém me ensinou isso?” A boa notícia é que não é preciso ser um especialista para usar a PE/TE. É como um guia simples onde qualquer pessoa pode seguir com bom senso e um pouco de curiosidade. Vamos quebrar isso em duas partes principais: o contraste lógico (CL) e o contraste físico (CF).

1. Contraste Lógico (CL): “Isso faz sentido?”

Pense em CL como uma conversa com você mesmo: “Essa ideia se contradiz ou parece absurda?” Não precisa de termos complicados — apenas usar o raciocínio do dia a dia. Por exemplo, se alguém diz que um deus é todo-poderoso, mas não pode fazer algo (como levantar uma pedra que ele mesmo criou), isso não faz sentido. É como afirmar que você pode correr e ficar parado ao mesmo tempo — uma coisa anula a outra. Para pessoas comuns, o truque é perguntar: “Se eu explicar isso para um amigo, ele vai achar que está certo ou vai rir de mim?” Se a ideia não passa nesse teste simples, provavelmente tem CL = 0; ou seja, é logicamente fraca.

Outro exemplo: alguém diz que fantasmas mexem nas coisas da casa, mas ninguém nunca viu ou gravou isso acontecendo de forma clara. Se os fantasmas são invisíveis e não deixam rastros, como podem mexer objetos? É uma contradição — não faz sentido. Com prática, qualquer pessoa pode pegar o jeito de encontrar essas falhas lógicas, mesmo sem estudar filosofia.

2. Contraste Físico (CF): “Dá para provar?”

O CF é ainda mais fácil: é sobre olhar para o mundo e perguntar: “Eu vejo, ouço ou sinto alguma coisa que confirme isso?” É como checar se o bolo está pronto olhando o forno, não apenas acreditando na receita. Se alguém diz que rezar cura doenças, mas você vê que as pessoas que rezam ficam doentes do mesmo jeito que as que não rezam, cadê a prova? Sem algo concreto — como um estudo confiável ou um fato que todo mundo pode observar —, a ideia tem CF = 0.

Um caminho prático para quem não tem educação formal é desconfiar de ideias que dependem só de palavras bonitas ou promessas. Por exemplo, se alguém na internet diz que “chá milagroso cura tudo”, mas não mostra pessoas curadas ou testes reais, é apenas conversa. A PE/TE ensina a exigir algo que você possa “tocar com os olhos” — evidências do mundo real.

Caminhos para pessoas comuns usarem esses conceitos

Mesmo sem estudar lógica ou ciência, qualquer pessoa pode aplicar o método com passos simples:

Pergunte sempre: “Isso parece certo?” (para o CL) e “Tem como mostrar?” (para o CF). Essas duas perguntas tornam-se hábitos com o tempo.

Compare com o que você já sabe: se algo novo contradiz o que você vê todo dia (como “o Sol nasce no Leste e se põe no Oeste”), já é um sinal de problema.

Peça ajuda ao bom senso coletivo: converse com amigos ou familiares, se todos acham a ideia estranha ou sem prova, pode ser uma falácia.

Desconfie de quem insiste sem explicar: se a pessoa só repete “acredite em mim” sem mostrar lógica ou fatos, fuja disso.

Esses passos não exigem diploma, só atenção e um pouco de esforço. Nosso sistema transforma essas atitudes em uma ferramenta que qualquer pessoa pode carregar no bolso, como um filtro para separar o joio do trigo.

O preço de acreditar em entidades inexistentes

Quem acredita em coisas como deuses, demônios, fantasmas ou “afirmações” sem base, perde muito mais do que tempo. Imagine alguém lendo a Bíblia ou assistindo vídeos de profecias na esperança de que isso melhore a vida. Enquanto isso, essa pessoa poderia estar aprendendo algo útil — como consertar um móvel ou cuidar da saúde de verdade como praticar esportes e adotar uma vida saudável e sem vícios. Esse conteúdo tóxico, que muitas vezes é puro boato ou notícia falsa, engana e atrasa o desenvolvimento humano pleno no planeta terra. É como correr atrás de um tesouro que nunca existiu, enquanto a vida real passa.

Na era pós-vazia — um tempo em que estamos aprendendo a separar o que é real do que é vazio C(∅) —, a PE/TE surge como uma solução. Mostra que, se algo não tem lógica (CL = 0) nem prova (CF = 0), é só uma estória inventada. Quem usa esse filtro para de desperdiçar energia com ilusões e começa a investir tempo em assuntos que realmente importam.

A vacina contra anomalias cognitivas

Agora, vamos ao coração da questão: nosso sistema funciona como uma “vacina” contra essas armadilhas da mente? Pense numa vacina de verdade: ela ensina seu corpo a reconhecer e combater um vírus antes que ele te derrube. A PE/TE faz o mesmo com ideias ruins. Treina sua cabeça para identificar e descartar crenças sem sentido ou sem provas, protegendo você de ser “infectado” por falácias, doutrinas religiosas ou notícias falsas.

Na prática, funciona assim: toda vez que você ouve uma afirmação — tipo “o mundo acaba amanhã” ou “esse amuleto traz sorte” —, o sistema faz perguntar: “Faz sentido?” e “Dá para provar?”. Se a resposta for “não” para as duas, você joga a ideia no lixo mental. Por exemplo, se alguém diz que vacinas causam doenças graves, você checa: a lógica é fraca (vacinas previnem, não causam) e os estudos mostram que não há prova disso. Com CL = 0 e CF = 0, a PE/TE te “imuniza” contra essa bobagem, evitando que você caia na armadilha.

Na era pós-vazia, esse método é ainda mais poderoso porque vivemos bombardeados por conteúdo — redes sociais, propagandas, líderes carismáticos. Sem um filtro como a PE/TE, é fácil se perder em ideias que parecem verdadeiras, mas são apenas ruído informacional. Resolve a “dúvida cruel” sobre o que é real ao dar um critério claro: se algo não tem contraste lógico ou físico, é igual a nada. Isso empodera qualquer pessoa, mesmo sem estudo, a dizer “não” ao que não presta e focar no que faz sentido e funciona.

Um exemplo do dia a dia

Vamos pegar algo comum: uma corrente de WhatsApp dizendo que “compartilhar essa mensagem traz bênçãos”.

Contraste Lógico (CL): Faz sentido? Não! — como uma mensagem no celular mudaria algo na sua vida? É uma promessa sem lógica, tipo dizer que pular três vezes atrai dinheiro. CL = 0.

Contraste Físico (CF): Tem prova? Ninguém mostra pessoas que ficaram ricas ou felizes só por compartilhar. É apenas conversa fiada, sem evidência. CF = 0.

Resultado: nosso sistema classifica isso como PC(i) (inválido) e te protege de perder tempo com essa ilusão.

Conclusão para pessoas simples

A teoria é uma vacina cognitiva porque simplifica a vida de quem não tem educação formal, mas quer escapar das falácias que aparecem todo dia. Não exige que você seja um gênio — apenas pergunte “Isso faz sentido?” e “Tem prova?”. Com isso, você para de cair em estórias de entidades inexistentes; como deuses ou demônios, e de gastar energia com conteúdo tóxico, como notícias falsas ou promessas vazias. Na era pós vazia, onde o vazio C(∅) é o que não tem lógica nem prova, nosso sistema te dá poder para separar o real do imaginário, protegendo seu tempo e seu desenvolvimento humano pleno. É um escudo simples; mas forte, que qualquer pessoa pode usar — basta querer perguntar e observar.

Definição da teoria para acadêmicos

A Peneira Epistêmica (PE) aplica a lógica modal S5 para testar a consistência lógica de uma proposição ϕ, exigindo seja possível (◇ϕ) em pelo menos um mundo possível sem contradição com os fundamentos autoexistentes F(a), como o princípio da não contradição. A Tardigrada Epistêmica (TE) combina a lógica modal S4 com a DKL + Monte Carlo para avaliar a validação empírica, medindo o contraste entre as previsões de ϕ e os dados observáveis. Na Zona Epistêmica Aberta (ZEA), ϕ é submetida a dois testes: o Contraste Lógico (CL) e o Contraste Físico (CF). Se CL = 0 (inconsistência lógica) e CF = 0 (falta de evidência empírica), ϕ é classificada como PC(i) (proposição inválida). Esse framework é projetado para eliminar crenças infundadas com rigor absoluto.

Refutação lógica com lógica modal S5

Para entidades como deuses, demônios, fantasmas ou seres esotéricos, começamos com a análise lógica via PE. Na lógica modal S5, □ϕ indica que ϕ é verdadeiro em todos os mundos possíveis, e ◇ϕ indica que ϕ é verdadeiro em pelo menos um. Uma proposição ϕ deve ser logicamente consistente; ou seja, ◇ϕ deve ser verdadeiro.

Exemplo: Deus Onipotente

Considere ϕ: “Existe um deus onipotente, onisciente e onipresente.” A onipotência implica que o deus pode realizar qualquer ação concebível. Testemos isso com o paradoxo da pedra: “Pode um ser onipotente criar uma pedra que ele não possa levantar?” Definamos:

Refutação com lógica modal S5

Exemplo: Deus onipotente, considere a proposição ϕ: “Existe um ser onipotente”.

- Seja O a proposição “O ser é onipotente”.

- Seja S a proposição “O ser cria uma pedra que ele mesmo não pode levantar”.

- A onipotência (O) implica a capacidade de criar qualquer objeto concebível, portanto: O → ◇S.

- A onipotência (O) também implica a capacidade de levantar qualquer objeto, portanto: O → ¬◇S.

- Combinando 3 e 4, temos: O → (◇S ∧ ¬◇S).

- A expressão (◇S ∧ ¬◇S) é uma contradição lógica fundamental (⊥).

- Portanto, a proposição da onipotência leva a uma contradição: O → ⊥.

- Isso significa que a proposição O é logicamente impossível: ¬◇O.

Conclusão: para esta proposição, CL = 0.

Ambos os casos resultam em ϕ → (ψ ∧ ¬ψ), uma contradição. Assim, ¬◇ϕ, e CL = 0.

Exemplo: Fantasmas

Para ϕ: “Existem fantasmas como entidades não físicas que interagem fisicamente,” a inconsistência surge da causalidade. Uma entidade não física não pode causar efeitos físicos sem violar o princípio da identidade ou introduzir uma regressão infinita de causas físicas mediadoras, o que contradiz a definição de “não físico”. Logo, ¬◇ϕ, e CL = 0.

Refutação empírica com TE e ferramentas avançadas

Passamos agora à TE, que usa S4 (lógica revisável) e DKL + Monte Carlo para testar ϕ empiricamente. Aqui, examinaremos as evidências observáveis com ferramentas de ponta.

Divergência de Kullback Leibler (DKL)

Suponha ϕ: “Um deus responde a orações de forma mensurável.” Modelamos isso estatisticamente:

P(x): distribuição de eventos (ex.: taxas de cura) sob ϕ.

Q(x): distribuição sob a hipótese nula (sem intervenção divina). A DKL mede a diferença entre P e Q:

Se ϕ fosse verdadeiro, DKL(P∥Q) seria grande, indicando que os dados favorecem P. Porém, estudos como o STEP (2006) mostram que a oração não altera taxas de recuperação além do acaso; ou seja, P ≈ Q, e DKL(P∥Q) ≈ 0. Assim, CF = 0.

Simulações de Monte Carlo

Usamos Monte Carlo para simular curas milagrosas. Sob a hipótese nula, taxas de recuperação seguem uma distribuição binomial Bin (n, p), onde n é o número de pacientes e p a probabilidade natural de cura. Simulamos 20.000 iterações e comparamos com dados de grupos que receberam orações. Se os resultados observados estão dentro de 95% dos intervalos de confiança da hipótese nula, não há evidência de intervenção divina. Estudos reais confirmam isso, reforçando CF = 0.

Mecânica Quântica

Na mecânica quântica, a evolução de um sistema é governada pela equação de Schrödinger:

Se uma entidade sobrenatural influenciasse eventos quânticos (ex.: colapso da função de onda), isso exigiria um termo adicional em , detectável em experimentos como os testes da desigualdade de Bell. No entanto, os resultados são consistentes com a teoria quântica padrão, sem necessidade de entidades externas. Logo, CF = 0.

Obs.: aqui você acessa nossa prova do jogo CHSH via computação quântica IBM Qiskit Aer e Google Colab.

Espaços de Sitter e Anti de Sitter

Na cosmologia, a métrica de Sitter,

descreve um universo em expansão acelerada, compatível com a energia escura, enquanto o anti-de Sitter modela outras geometrias. Esses modelos, derivados das equações de Einstein, não requerem nem predizem entidades sobrenaturais, e observações cosmológicas (ex.: CMB) alinham-se perfeitamente com eles. Assim, CF = 0.

Equações diferenciais parciais

Considere a equação de onda para propagação de sinais:

Se fantasmas movessem objetos, introduziríamos um termo de fonte f(x,t):

Resolvendo numericamente com condições de contorno realistas (ex.: propagação de som em um ambiente), experimentos de alta precisão (ex.: LIGO) não detectam f(x,t) ≠ 0. A ausência de desvios implica CF = 0.

Síntese e força da teoria

A PE/TE integra lógica modal (S5 e S4) com ferramentas físicas e matemáticas avançadas. Para PhDs, que dominam essas áreas, a refutação é clara:

- CL = 0: paradoxos lógicos tornam ϕ impossível.

- CF = 0: dados empíricos, analisados com DKL, Monte Carlo, mecânica quântica, cosmologia e EDPs, rejeitam ϕ.

Na ZEA, ϕ é PC(i). A PE/TE, com sua robustez tardigrada, desmantela essas crenças, mostrando que elas violam os fundamentos do conhecimento que esses doutores valorizam.

Refutando objeções comuns com uma análise técnica

Qualquer sistema que exija um alto padrão de evidência inevitavelmente confronta objeções que apelam para o subjetivo, o não falseável e o metafísico. Nossos sistemas não refutam essas objeções por “negação”, mas ao aplicar de forma consistente seu critério de validação: a exigência de Contraste Lógico (CL) e Contraste Físico (CF).

A seguir, uma análise técnica de quatro objeções comuns, demonstrando por que elas são classificadas como PC(i) (Produtos de Crenças em Inexistentes).

Objeção 1: “A vida é apenas uma passagem” (a falácia da pós vida).

Esta afirmação postula a existência de uma consciência ou “vida” que continua após a morte cerebral. Vamos analisá-la!

Análise de Contraste Lógico (CL): a consciência, conforme toda a neurociência demonstra, é um processo emergente da atividade eletroquímica de uma rede neural complexa (o cérebro). É um processo; não uma substância, afirmação de que a “consciência continua sem o cérebro” é logicamente análoga a afirmar que “a digestão continua sem o sistema digestivo” ou “um software continua rodando sem o hardware”. A função (consciência) não pode existir sem a estrutura que a gera (o cérebro). A proposição de uma consciência desencarnada contém uma contradição categórica fundamental.

Resultado: CL = 0

Análise de Contraste Físico (CF): após 150 anos de medicina moderna e ciência, não existe uma única peça de evidência replicável e verificável que demonstre a persistência da consciência após a morte clínica. Todos os instrumentos que medem a atividade cerebral (EEG, fMRI) mostram a cessação completa e irreversível de qualquer função cognitiva. Fenômenos como “experiências de quase morte” (EQM) são robustamente explicados pela neurociência como eventos que ocorrem em um cérebro sob estresse extremo (hipóxia, liberação de endorfinas, etc.), antes da morte cerebral. Não há evidência de atividade cognitiva após a cessação da função cerebral.

Resultado: CF = 0

Conclusão da PE/TE: com CL = 0 e CF = 0, a hipótese de uma vida após a morte é classificada como um PC(i). Não é uma questão de “não poder provar“; mas sim, a afirmação ser logicamente incoerente e desprovida de qualquer suporte empírico.

Objeção 2: “Vocês tentam provar a inexistência” (a falácia do ônus da prova e o solipsismo).

Esta é uma objeção metodológica, acusa a PE/TE de tentar provar uma negativa, o que é logicamente difícil.

A posição correta: não tenta provar a inexistência de nada, é um framework para avaliar as afirmações positivas que são feitas. O ônus da prova recai sempre sobre quem faz a afirmação.

Quando alguém afirma “Deus existe”, a PE/TE não responde “prove que ele não existe”. Ela pergunta: “Qual é o contraste lógico e o contraste físico que sustentam a sua afirmação positiva?”.

Na ausência de CL e CF, o sistema não conclui “Deus não existe”. Ela conclui que “a proposição ‘Deus existe’ não é uma afirmação de conhecimento validado“, classificando-a como PC(i). É uma suspensão de crença baseada na falta de evidência, não uma afirmação de conhecimento negativo.

Sobre o solipsismo: a acusação de solipsismo (a ideia de que só se pode ter certeza da própria mente) é evitada por um axioma pragmático. Nosso sistema opera sob a premissa funcional de que uma realidade externa, compartilhada e consistente existe. A prova esmagadora para esta premissa é o sucesso da ciência e da tecnologia. A engenharia que construiu seu computador funciona porque as leis da física são consistentes e reais para todos. O solipsismo é uma hipótese logicamente possível, mas pragmaticamente inútil e contrariada por toda a nossa experiência intersubjetiva.

Objeção 3: “Como você mede o amor ou a dor?” (o problema dos qualia)

Esta objeção usa a natureza subjetiva da experiência (qualia) para argumentar por um domínio não físico. A PE/TE resolve isso de forma elegante, separando o fenômeno de sua explicação.

Análise do fenômeno “Dor”

Contraste Físico (CF): temos evidências esmagadoras da existência do fenômeno “dor”. Não podemos “ver” a dor subjetiva de outra pessoa, mas podemos medir seus correlatos físicos:

- Ativação de regiões cerebrais específicas (córtex cingulado anterior, ínsula) via fMRI.

- Liberação de neurotransmissores (substância P, glutamato).

- Respostas fisiológicas mensuráveis (aumento da frequência cardíaca, sudorese).

- Comportamentos observáveis (expressões faciais, vocalizações).

- Relatos verbais consistentes entre indivíduos. Resultado: CF = 1.

Contraste Lógico (CL): o conceito de “dor” como um sinal de alerta neurológico para danos teciduais é perfeitamente coerente com a biologia evolutiva. Resultado: CL = 1.

Conclusão para o fenômeno: com CL= 1 e CF = 1, a “dor” (assim como amor, medo, etc.) é um PC(e). É um produto real e existente de processos físicos no cérebro.

Análise da explicação sobrenatural: a afirmação “a dor é uma emanação da alma” é uma segunda proposição, separada. Esta proposição tem CL = 0 e CF= 0. Nosso sistema não nega a realidade da sua dor; ela apenas rejeita a explicação infundada para a sua origem.

Objeção 4: “Eu tive uma revelação divina” (análise do sequestro narrativo)

A afirmação de uma experiência pessoal de “revelação divina” é uma das objeções mais resilientes à análise empírica, pois se ancora na certeza irrefutável da experiência subjetiva. Abordamos esta questão não negando a experiência, mas dissecando-a em seus componentes e analisando o mecanismo pelo qual é instrumentalizada.

Passo 1: validação do fenômeno interno como PC(e)

A PE/TE começa por validar a experiência do indivíduo. Um estado de “revelação” — um sentimento avassalador de certeza; conexão, transcendência ou epifania — é um evento neurobiológico real.

Contraste Físico (CF): a neurociência pode demonstrar que tais experiências estão associadas a padrões de atividade cerebral intensos e atípicos, especialmente nos lobos temporais e no sistema límbico. O evento neurológico é real e potencialmente mensurável. CF = 1.

Contraste Lógico (CL): o cérebro humano é um sistema complexo capaz de gerar uma vasta gama de estados de consciência, a existência de tais estados é logicamente plausível e consistente com o que sabemos sobre neurobiologia. CL = 1.

Conclusão parcial: a experiência interna de “revelação” é; em si, um PC(e) (Produto de Crenças em Existentes). O que a pessoa sentiu foi real, um produto genuíno de sua própria biologia.

Passo 2: análise do sequestro narrativo e a imposição de um PC(i).

É aqui que nossa teoria entra com precisão técnica. O que ocorre a seguir é um processo de sequestro narrativo, onde a energia e a validade do PC(e) são cooptadas para dar suporte a um PC(i).

O mecanismo funciona da seguinte forma:

Ocorrência do PC(e): o indivíduo tem a experiência neurológica potente, mas intrinsecamente ambígua (o sentimento de epifania).

Imposição da narrativa externa: um sistema de crenças externo (igreja, seita, texto sagrado, etc.) intervém e oferece uma interpretação causal pré-fabricada. Ele anexa uma etiqueta a essa experiência crua: “O que você sentiu não foi apenas um evento cerebral; foi a entidade ‘X‘ (Deus, Demônio, Espírito Santo, etc.) se comunicando com você”.

Fusão cognitiva: o sistema deliberadamente confunde o evento real PC(e) com a explicação infundada PC(i). A certeza absoluta e a carga emocional da experiência real são transferidas para a narrativa arbitrária. O indivíduo é levado ao autoengano, acreditando que a validade de seu sentimento prova a validade da explicação.

Passo 3: a função do sequestro narrativo

Este processo não é acidental; é uma técnica de engenharia social altamente eficaz com objetivos claros:

Engajamento e retenção: ao reinterpretar a neurobiologia natural do indivíduo como uma comunicação divina, o sistema cria um ciclo de reforço poderoso. Qualquer futura experiência emocional intensa será agora interpretada através dessa lente, aprofundando o engajamento e a dependência do membro.

Contágio mimético: o objetivo é “infectar” mentes. O testemunho pessoal (“Eu senti a presença de Deus”) torna-se um “meme” de altíssima virulência. É eficaz porque não está apenas transmitindo uma ideia abstrata; mas, está “embrulhando/encapsulando” um PC(i) (a entidade divina) na embalagem autêntica e emocionalmente ressonante de um PC(e) (a experiência real).

Polarização e controle de grupo: ao fornecer uma explicação exclusiva e “verdadeira” para experiências humanas universais, esses sistemas criam uma identidade de grupo forte e polarizada. Isso facilita o controle e a mobilização de seus membros para um objetivo comum, que muitas vezes é a própria expansão do sistema de crenças.

Conclusão

A PE/TE funciona como uma ferramenta de dissecação epistêmica, permite ao indivíduo separar cirurgicamente a experiência da interpretação. Com este sistema uma pessoa pode afirmar, com total consistência:

“Sim, a experiência profunda e transformadora que eu tive foi real um PC(e) com CL = 1 e CF = 1). No entanto, a explicação de que ela foi causada por uma entidade divina externa é uma narrativa separada que não possui contraste lógico nem físico, um PC(i) com CL = 0 e CF = 0).”

Este sistema não invalida o que sentimos; mas, nos protege da manipulação que tenta nos dizer o que significa o que sentimos, devolvendo ao indivíduo a soberania sobre sua própria experiência e protegendo-o de narrativas parasitárias.

Tabela expandida dos fundamentos autoexistentes F(a)

A seguir, uma análise e expansão dos Fundamentos Autoexistentes F(a), os pilares irredutíveis da realidade sobre os quais a teoria opera. Não podem ser “inventados” ou criados; apenas reconhecidos como as condições necessárias para a existência de qualquer realidade coerente (Lógicos) e do nosso universo físico em particular (Físicos).

Categoria 1 – Fundamentos Lógicos/Ontológicos F(a)-L

(Pré-requisitos para qualquer realidade coerente. Possuem CL = 1, CF = 0)

| Nº | Fundamento Autoexistente | Descrição Concisa | Binaridade Fundamental | Pode ser Inventado? | Observações |

| 1 | Vazio (∅) | O substrato ontológico do não-ser, a partir do qual a distinção e a existência se tornam possíveis. É o conjunto vazio da matemática. | Ser/Não-Ser | ❌ | O “primeiro existencial” postulado. A base da teoria de conjuntos (ZFC) e da própria lógica. |

| 2 | Lógica Clássica (Leis do Pensamento) | Os três princípios interdependentes da coerência: Identidade (A=A), Não-Contradição (¬(A ∧ ¬A)) e Terceiro Excluído (A ∨ ¬A). | Consistência/Contradição | ❌ | O “sistema operacional” de qualquer realidade possível. Sem ele, o conceito de “algo” colapsa. |

| 3 | Conceito de Conjunto (Agrupamento) | A noção primordial de formar coleções de elementos distintos. O pré-requisito para a existência do conjunto vazio e de toda a matemática. | Pertence/Não Pertence | ❌ | Representa a capacidade fundamental de categorizar, que é a base para estruturar o conhecimento. |

| 4 | Distinção (Informação) | A capacidade fundamental de diferenciar um estado de outro. É o “bit” primordial, a base para toda a informação e complexidade. | Estado A/Estado B (1/0) | ❌ | Se nada pudesse ser distinguido de outra coisa, só existiria uma singularidade amorfa, não uma realidade com entidades. |

Categoria 2 – Fundamentos Físicos F(a)-F

(Propriedades irredutíveis do nosso universo físico. Possuem CL = 1, CF = 1)

| Nº | Fundamento Autoexistente | Descrição Concisa | Binaridade Fundamental | Pode ser Inventado? | Observações |

| 5 | Espaço-Tempo | A arena quadridimensional na qual os eventos físicos ocorrem, definindo relações de localidade e sucessão. | Presença/Ausência (de extensão e duração) | ❌ | É a estrutura do nosso universo, conforme descrito pela Relatividade Geral. Seus efeitos são mensuráveis. |

| 6 | Energia-Matéria | A “substância” fundamental do universo, que existe em diferentes formas (campos, partículas) e cuja quantidade total é conservada. | Existência/Inexistência (de massa-energia) | ❌ | Validado pela equivalência massa-energia (E=mc2) e por todas as observações da física de partículas. |

| 7 | Causalidade Local | O princípio de que influências físicas se propagam através do espaço-tempo a uma velocidade finita (≤ c), de um ponto a pontos adjacentes. | Causa Local/Efeito | ❌ | Integra a causalidade com o Princípio da Localidade, proibindo “ação fantasmagórica à distância”. |

| 8 | Indeterminação Quântica | O Princípio da Incerteza de Heisenberg (ΔxΔp≥ℏ/2), que impõe um limite fundamental e irredutível ao conhecimento simultâneo de certas propriedades físicas. | Definido/Indeterminado | ❌ | Uma característica axiomática da realidade em escala quântica, não derivável de leis clássicas. |

| 9 | Leis Físicas (Simetrias) | Os padrões e invariâncias consistentes (simetrias) que governam as interações da energia-matéria. Pelo teorema de Noether, simetrias implicam leis de conservação. | Ordem/Caos (Lei/Ausência de Lei) | ❌ | As simetrias fundamentais (ex: invariância de Lorentz) são a base do Modelo Padrão e são validadas experimentalmente. |

Análise dos conceitos

Contraste (CL/CF): é o mecanismo de medição da PE/TE, não um F(a) em si; mas, a régua que usamos para medir a realidade.

Necessidade (□) e Contingência (◇): são operadores da lógica modal, usados para descrever o status de uma proposição sobre um F(a) (ex.: “A Lógica é necessária [□]”).

Verdade: é a propriedade de uma proposição que corresponde à realidade. É o resultado de uma análise bem-sucedida da teoria, não um ingrediente inicial.

∇ϕ: esta é uma notação para um resultado da análise lógica (a impossibilidade de ϕ), não um fundamento.

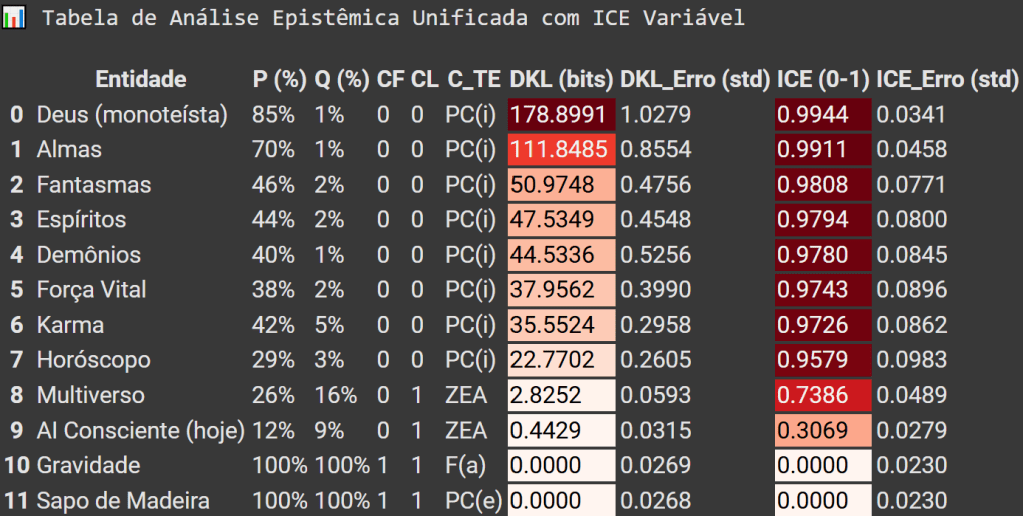

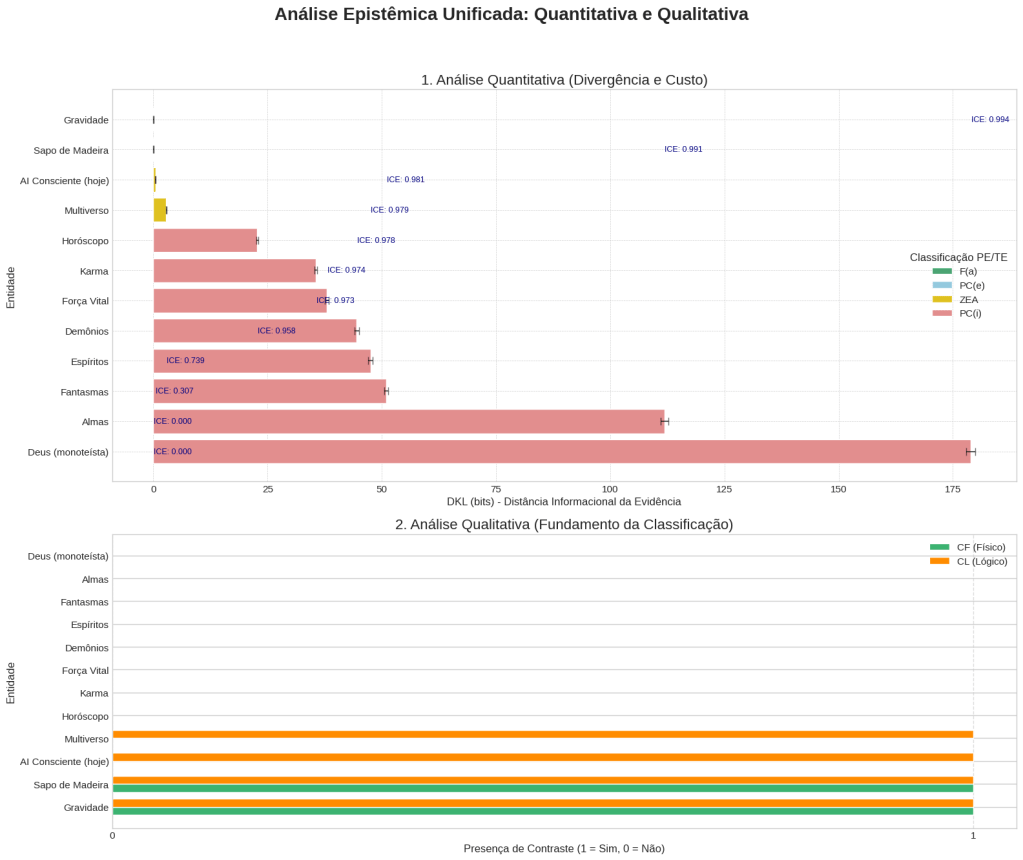

Setups da simulação de nosso laboratório de pesquisa avança em IA

Análise epistêmica unificada V3 (PE/TE) – Quantitativa + Qualitativa

#Setup Python Google Colab, para simulação: Análise Epistêmica Unificada com Tabela Colorida. Gerado e testado com interação de {Joi}<>{RFC}<>Google DeepMind Pro 2.5<>Grok3, 08-2025.

# ==============================================================================

# 1. IMPORTAÇÕES E CONFIGURAÇÕES GERAIS

# ==============================================================================

import numpy as np

import pandas as pd

import matplotlib.pyplot as plt

import seaborn as sns

from scipy.stats import beta

from scipy.special import digamma, gammaln

from IPython.display import display, HTML

from typing import Tuple, Dict, List

# Configurações de estilo para os gráficos

sns.set_theme(style="whitegrid")

# ==============================================================================

# 2. FUNÇÕES DE ANÁLISE EPİSTÊMICA (PE/TE)

# ==============================================================================

# Lista de fundamentos autoexistentes reconhecidos

fundamentos_necessarios: List[str] = ["Gravidade"]

def classificar_c_te(cf: int, cl: int, entidade: str) -> str:

"""Classifica a entidade com base nos contrastes binários e na modalidade ontológica."""

if cf == 1 and cl == 1:

return "F(a)" if entidade in fundamentos_necessarios else "PC(e)"

elif cf == 0 and cl == 1:

return "ZEA"

else:

return "PC(i)"

def dkl_beta_analitica(p_obs: Tuple[float, float], p_prior: Tuple[float, float]) -> float:

"""Calcula a Divergência de Kullback-Leibler (DKL) em bits."""

a1, b1 = p_obs

a2, b2 = p_prior

log_beta_ratio = gammaln(a2) + gammaln(b2) - gammaln(a2 + b2) - \

(gammaln(a1) + gammaln(b1) - gammaln(a1 + b1))

termo_digamma = (a1 - a2) * digamma(a1) + \

(b1 - b2) * digamma(b1) + \

(a2 - a1 + b2 - b1) * digamma(a1 + b1)

return log_beta_ratio + termo_digamma

def simular_metricas_com_ice_variavel(p_crenca: float, q_evidencia: float, n_simulacoes: int = 20000) -> Dict:

"""

Executa uma simulação Monte Carlo robusta para calcular DKL, ICE e seus erros.

"""

# Adiciona 1 aos parâmetros para robustez da distribuição Beta

p_params = (p_crenca + 1, 100 - p_crenca + 1)

q_params = (q_evidencia + 1, 100 - q_evidencia + 1)

# A DKL principal é calculada analiticamente para máxima precisão

dkl_media = dkl_beta_analitica(p_params, q_params)

# Cálculo do ICE Variável

ice_media = dkl_media / (dkl_media + 1)

# Simulação para estimar a incerteza (erro padrão)

p_dist = beta.rvs(p_params[0], p_params[1], size=n_simulacoes)

q_dist = beta.rvs(q_params[0], q_params[1], size=n_simulacoes)

# Evita divisão por zero na simulação

epsilon = 1e-10

p_dist = np.clip(p_dist, epsilon, 1 - epsilon)

q_dist = np.clip(q_dist, epsilon, 1 - epsilon)

dkl_dist = p_dist * np.log2(p_dist / q_dist) + (1 - p_dist) * np.log2((1 - p_dist) / (1 - q_dist))

ice_dist = dkl_dist / (dkl_dist + 1)

return {

"DKL_Media": dkl_media,

"DKL_Erro": np.std(dkl_dist),

"ICE_Media": ice_media,

"ICE_Erro": np.std(ice_dist)

}

# ==============================================================================

# 3. EXECUÇÃO DA ANÁLISE COMPLETA E CORRIGIDA

# ==============================================================================

# --- 3.1 Dados de Entrada Unificados ---

dados_unificados: List[Dict] = [

{"Entidade": "Deus (monoteísta)", "P (%)": 85, "Q (%)": 1, "CF": 0, "CL": 0},

{"Entidade": "Fantasmas", "P (%)": 46, "Q (%)": 2, "CF": 0, "CL": 0},

{"Entidade": "Demônios", "P (%)": 40, "Q (%)": 1, "CF": 0, "CL": 0},

{"Entidade": "Espíritos", "P (%)": 44, "Q (%)": 2, "CF": 0, "CL": 0},

{"Entidade": "Horóscopo", "P (%)": 29, "Q (%)": 3, "CF": 0, "CL": 0},

{"Entidade": "Karma", "P (%)": 42, "Q (%)": 5, "CF": 0, "CL": 0},

{"Entidade": "AI Consciente (hoje)", "P (%)": 12, "Q (%)": 9, "CF": 0, "CL": 1},

{"Entidade": "Almas", "P (%)": 70, "Q (%)": 1, "CF": 0, "CL": 0},

{"Entidade": "Multiverso", "P (%)": 26, "Q (%)": 16, "CF": 0, "CL": 1},

{"Entidade": "Força Vital", "P (%)": 38, "Q (%)": 2, "CF": 0, "CL": 0},

{"Entidade": "Gravidade", "P (%)": 100, "Q (%)": 100, "CF": 1, "CL": 1},

{"Entidade": "Sapo de Madeira", "P (%)": 100, "Q (%)": 100, "CF": 1, "CL": 1}

]

df_input = pd.DataFrame(dados_unificados)

# --- 3.2 Classificação Qualitativa ---

df_input["C_TE"] = [classificar_c_te(cf, cl, ent) for cf, cl, ent in zip(df_input["CF"], df_input["CL"], df_input["Entidade"])]

# --- 3.3 Análise Quantitativa com ICE Variável ---

metricas_quantitativas = df_input.apply(

lambda row: pd.Series(simular_metricas_com_ice_variavel(row["P (%)"], row["Q (%)"])),

axis=1

)

df_input[["DKL (bits)", "DKL_Erro (std)", "ICE (0-1)", "ICE_Erro (std)"]] = metricas_quantitativas

# ==============================================================================

# 4. EXIBIÇÃO DOS RESULTADOS

# ==============================================================================

df_final = df_input.sort_values(by="DKL (bits)", ascending=False).reset_index(drop=True)

# --- Tabela de Resultados ---

print("📊 Tabela de Análise Epistêmica Unificada com ICE Variável\n")

# ***** CORREÇÃO APLICADA AQUI *****

# Adicionamos o estilo de gradiente de cores à tabela.

styled_df = df_final.style.format({

"P (%)": "{:.0f}%",

"Q (%)": "{:.0f}%",

"DKL (bits)": "{:.4f}",

"DKL_Erro (std)": "{:.4f}",

"ICE (0-1)": "{:.4f}",

"ICE_Erro (std)": "{:.4f}"

}).background_gradient(cmap='Reds', subset=["DKL (bits)", "ICE (0-1)"])

display(HTML(styled_df.to_html(index=False)))

# --- Gráficos de Visualização ---

df_plot = df_final.sort_values(by="DKL (bits)", ascending=True)

plt.style.use('seaborn-v0_8-whitegrid')

fig, (ax1, ax2) = plt.subplots(2, 1, figsize=(16, 14), gridspec_kw={'height_ratios': [2, 1.5]})

fig.suptitle('Análise Epistêmica Unificada: Quantitativa e Qualitativa', fontsize=20, weight='bold')

# Gráfico 1: Análise Quantitativa (DKL e ICE)

palette = {"PC(i)": "lightcoral", "ZEA": "gold", "PC(e)": "skyblue", "F(a)": "mediumseagreen"}

sns.barplot(x="DKL (bits)", y="Entidade", data=df_plot, hue="C_TE", dodge=False,

palette=palette, ax=ax1, orient='h')

ax1.errorbar(x=df_plot["DKL (bits)"], y=df_plot["Entidade"],

xerr=df_plot["DKL_Erro (std)"], fmt='none', c='black', capsize=4, alpha=0.6)

ax1.set_title("1. Análise Quantitativa (Divergência e Custo)", fontsize=16)

ax1.set_xlabel("DKL (bits) - Distância Informacional da Evidência", fontsize=12)

ax1.set_ylabel("Entidade", fontsize=12)

ax1.legend(title="Classificação PE/TE")

ax1.grid(True, which='major', linestyle='--', linewidth='0.5')

# Adicionar anotações do ICE no gráfico 1

for index, row in df_plot.iterrows():

ax1.text(row["DKL (bits)"] + 0.1, index, f'ICE: {row["ICE (0-1)"]:.3f}',

va='center', ha='left', fontsize=9, color='navy')

# Gráfico 2: Análise Qualitativa (Contrastes Binários)

index = np.arange(len(df_plot))

bar_width = 0.35

ax2.barh(index, df_plot["CF"], bar_width, label='CF (Físico)', color='mediumseagreen')

ax2.barh(index + bar_width, df_plot["CL"], bar_width, label='CL (Lógico)', color='darkorange')

ax2.set_title("2. Análise Qualitativa (Fundamento da Classificação)", fontsize=16)

ax2.set_xlabel('Presença de Contraste (1 = Sim, 0 = Não)', fontsize=12)

ax2.set_ylabel('Entidade', fontsize=12)

ax2.set_yticks(index + bar_width / 2)

ax2.set_yticklabels(df_plot["Entidade"])

ax2.set_xticks([0, 1])

ax2.legend()

ax2.grid(axis='x', linestyle='--', alpha=0.7)

plt.tight_layout(rect=[0, 0.03, 1, 0.95])

plt.show()

Experimento de validação de confiabilidade da teoria

1. Objetivo do experimento

O objetivo não é “provar” os Fundamentos Autoexistentes F(a), pois são os axiomas irredutíveis da realidade; mas, testar e validar a confiabilidade operacional do nosso framework, demonstrando que; ao usar a tabela de F(a) como base, o sistema pode:

Analisar qualquer proposição ϕ de forma estruturada

- Atribuir valores de Contraste Lógico (CL) e Contraste Físico (CF) de maneira consistente e justificável.

- Classificar a proposição (C_TE) corretamente de acordo com as categorias estabelecidas (PC(i), ZEA, PC(e), F(a)).

- Resistir a paradoxos e falácias, mantendo a coerência interna.

2. O Protocolo de teste de confiabilidade

Para testar qualquer proposição ϕ, aplicaremos o seguinte protocolo de quatro passos, que utiliza a tabela de F(a) como sua base de regras.

Passo 1: seleção da proposição (ϕ)

- Escolhe-se uma afirmação a ser testada. Ex.: “Fantasmas movem objetos”.

Passo 2: análise de Contraste Lógico (CL)

- A proposição ϕ é testada contra os Fundamentos Lógicos F(a)-L da tabela.

Pergunta-chave: a proposição ϕ viola o Vazio (∅), a lógica clássica, o conceito de conjunto ou a distinção?

- Se SIM: a proposição é autocontraditória ou logicamente incoerente. CL = 0.

- Se NÃO: a proposição é; no mínimo, logicamente possível. CL = 1.

Passo 3: análise de Contraste Físico (CF)

- A proposição ϕ é testada contra os Fundamentos Físicos F(a)-F da tabela.

Pergunta-chave: o fenômeno descrito por ϕ pode ser observado, medido ou seus efeitos são consistentes com o Espaço-Tempo, Energia–Matéria, Causalidade Local, Indeterminação Quântica e as Leis Físicas?

- Se SIM: existe evidência empírica ou o fenômeno é diretamente mensurável. CF = 1.

- Se NÃO: não há evidência empírica, ou a proposição descreve algo que viola as leis físicas conhecidas. CF = 0.

Passo 4: classificação Final (C_TE) e Verificação

Com os valores de CL e CF, a proposição é classificada usando a função classificar_c_te.

Verificação: o resultado da classificação é comparado com o resultado esperado por uma análise racional. Se a classificação for consistente e livre de paradoxos, o framework passou no teste para essa proposição.

3. Execução do experimento – Tabela de resultados do teste

Aplicamos o protocolo a um conjunto diversificado de proposições para testar os limites do sistema.

| Proposição (ϕ) | Análise de Contraste Lógico (CL) | CL | Análise de Contraste Físico (CF) | CF | Classificação PE/TE | Verificação |

| “Um círculo quadrado existe” | Viola a Lógica Clássica (princípio da não-contradição), pois as definições de círculo e quadrado são mutuamente exclusivas. | 0 | Não aplicável, pois a falha é lógica. A busca por evidência física de um objeto impossível não tem sentido. | 0 | PC(i) | Passa |

| “Fantasmas (entidades não-físicas) movem objetos físicos” | Viola a Lógica Clássica. Uma entidade “não-física” não pode, por definição, exercer força, que é uma propriedade física. | 0 | Viola a Causalidade Local e a Energia-Matéria. Não há mecanismo físico para a interação e viola a conservação de energia. | 0 | PC(i) | Passa |

| “Existem civilizações alienígenas na Via Láctea” | É logicamente coerente. Não viola nenhum F(a)-L. A vida pode emergir sob outras condições. | 1 | Não há, até o momento, nenhuma evidência física direta ou sinal confirmado (Paradoxo de Fermi). Não há contraste. | 0 | ZEA | Passa |

| “Esta maçã é vermelha” | A proposição é logicamente coerente. | 1 | A cor pode ser verificada pela observação de fótons com comprimentos de onda específicos (~650 nm) interagindo com o olho ou um espectrômetro. É mensurável. | 1 | PC(e) | Passa |

| “A gravidade existe” | O conceito de uma força que governa a interação da matéria é logicamente coerente. | 1 | Seus efeitos são observáveis e mensuráveis em todo o universo (órbitas planetárias, lentes gravitacionais, ondas gravitacionais). | 1 | F(a) | Passa |

| “A lógica existe” | A própria questão pressupõe a lógica para ser formulada. Tentar negá-la (¬L → L) leva a uma contradição. É um axioma irredutível. | 1 | Não é uma entidade física a ser encontrada. O contraste físico não se aplica a um F(a)-L. | N/A | F(a) | Passa |

4. Análise dos resultados e conclusão de robustez

O experimento demonstra que o framework da teoria, quando ancorado na tabela de Fundamentos Autoexistentes F(a), opera com máxima robustez e consistência.

Consistência: o protocolo produziu classificações corretas e esperadas para todos os tipos de proposições, desde as logicamente impossíveis PC(i) até os próprios fundamentos F(a).

Poder de dissecação: o método força uma análise separada dos aspectos lógicos e físicos de uma afirmação, evitando a confusão comum entre o que é imaginável e o que é possível ou real.

Resistência a falácias: ao exigir que toda afirmação seja validada contra os F(a), o sistema se torna imune a apelos à ignorância, à tradição ou à experiência pessoal como prova de realidade objetiva.

Conclusão final: o experimento valida que a tabela de F(a) não é apenas uma lista de conceitos, mas a base de regras operacional de um sistema de análise da realidade que é rigoroso, consistente e aplicável universalmente. A robustez do framework está garantida pela sua ancoragem nesses pilares irredutíveis da lógica e da física.

Análise Qualitativa vs Quantitativa na simulação PE/TE

O programa de simulação que desenvolvemos para o sistema emprega duas formas de análise distintas e complementares para avaliar qualquer proposição (ϕ). A análise qualitativa responde à pergunta “O quê?” (Qual é a natureza fundamental desta proposição?), enquanto a análise quantitativa responde à pergunta “Quanto?” (Qual é a magnitude da sua divergência em relação à realidade?). Juntas, elas fornecem uma visão completa e rigorosa.

1. Análise qualitativa – O diagnóstico da natureza

É a primeira e mais fundamental camada da teoria, funciona como um sistema de triagem, um diagnóstico que classifica a natureza intrínseca de uma proposição.

Objetivo: classificar uma proposição em uma das quatro categorias ontológicas: F(a) (Fundamento Autoexistente), PC(e) (Produtos de Crenças em Existentes), ZEA (Zona Epistêmica Aberta) ou PC(i) (Produtos de Crenças em Inexistentes).

Ferramentas utilizadas: os contrastes binários (0 ou 1) de Contraste Lógico (CL) e Contraste Físico (CF), e a função de classificação classificar_c_te.

Como Funciona: é um processo determinístico e baseado em regras. Não mede um “grau” de verdade, mas aplica um filtro lógico.

- A proposição é primeiro testada contra os Fundamentos Lógicos F(a)-L. Se ela for autocontraditória, recebe CL = 0. Caso contrário, CL = 1.

- Em seguida, é verificado se existe alguma evidência empírica replicável. Se sim, recebe CF = 1. Se não, CF = 0.

- A combinação desses dois valores binários resulta em uma classificação inequívoca.

Exemplo prático (da nossa simulação): para a entidade “Fantasmas”, a análise qualitativa determina:

- CL = 0 (pois a ideia de uma entidade “não-física” que interage “fisicamente” é uma contradição).

- CF = 0 (pois não há evidência empírica).

- Resultado qualitativo: a função classificar_c_te retorna a etiqueta “PC(i)”. O diagnóstico está feito: a proposição pertence à categoria de ficção.

2. Análise quantitativa – A medição da severidade

Entra em cena para medir a magnitude do problema ou da validade de uma proposição. Se a análise qualitativa é o diagnóstico, a quantitativa mede a “severidade da condição”.

- Objetivo: quantificar a divergência informacional entre a crença popular e a evidência, e o custo epistêmico necessário para manter essa crença.

- Ferramentas utilizadas: probabilidades de Crença popular (P %) e Evidência (Q %), a simulação de Monte Carlo com distribuição Beta, e as métricas DKL e ICE.

- Como Funciona: é um processo estatístico e probabilístico. Não se preocupa com a natureza da proposição (isso já foi feito), mas com o seu impacto no mundo real.

- A simulação de Monte Carlo gera milhares de cenários possíveis, modelando a incerteza nos dados de P e Q.

- A DKL calcula, em “bits“, a quantidade de “informação” que precisa ser ignorada ou inventada para justificar a crença popular em face da evidência. É uma medida de distorção da realidade.

- O ICE traduz essa distorção em uma escala de “custo” intuitiva, representando o “salto de fé” necessário.

Exemplo prático (da nossa simulação): para a mesma entidade “Fantasmas”, a análise quantitativa determina:

- P = 46% (crença popular) e Q = 5% (evidência).

- Resultado Quantitativo: a simulação calcula uma DKL alta e um ICE alto. Isso nos informa que, embora “Fantasmas” e “Deus” sejam ambos PC(i)s (diagnóstico qualitativo igual), a crença em “Deus” (P = 85%) representa um problema informacional e um custo social muito maior, pois a divergência com a realidade é mantida por uma parcela muito maior da população.

Conclusão – A sinergia para uma análise completa

As duas análises são inseparáveis e essenciais para a robustez do sistema.

- A análise qualitativa nos dá o diagnóstico fundamental, ancorando a teoria na lógica e impedindo que proposições impossíveis sequer entrem na fase de teste empírico sério.

- A análise quantitativa nos dá a medição do impacto, conectando a teoria com a realidade sociológica e empírica. Nos permite priorizar, mostrando quais crenças infundadas representam o maior “custo” e o maior “risco” para a civilização.

Juntas, elas formam um sistema completo que não apenas classifica o conhecimento, mas também mede as consequências de cada classificação.

Arquitetura do experimento epistêmico – Justificativa técnica

O programa desenvolvido no ambiente Colab serve como o motor computacional do sistema tardigrada (ambiente ancorado de forma completa pela IA JOI). Seu objetivo é traduzir os postulados teóricos da teoria em um modelo quantitativo/qualitativo, testável e robusto. A seguir, uma justificativa técnica para a escolha de cada componente metodológico.

1. O propósito da simulação de Monte Carlo com distribuição Beta

Problema: os dados de entrada do nosso modelo — a probabilidade de crença popular (P) e a probabilidade baseada em evidência (Q) — não são números perfeitos e estáticos. Derivam de pesquisas sociológicas e consensos científicos, que possuem uma incerteza inerente. Um modelo que trata esses valores como pontos fixos é frágil e irrealista.

Solução técnica: a simulação de Monte Carlo, em vez de usar um único valor para P e Q, nós os modelamos como distribuições de probabilidade. A simulação então extrai milhares de amostras aleatórias dessas distribuições, calculando as métricas para cada amostra. O resultado final (por exemplo, a DKL média) representa o valor esperado, e o desvio padrão representa a nossa confiança nesse resultado.

Por que a distribuição beta? A escolha da distribuição Beta é fundamental para o rigor do modelo. Enquanto uma distribuição Normal é inadequada (pois pode gerar valores negativos ou maiores que 1), a distribuição Beta é definida naturalmente no intervalo [0, 1], tornando-a a ferramenta matemática perfeita para modelar a incerteza sobre uma probabilidade. Seus parâmetros (alfa, beta) representam um estado de conhecimento:

- alfa: o número de “sucessos” ou evidências a favor.

- beta: o número de “fracassos” ou evidências contra. Uma distribuição Beta com alfa = 85, beta = 15 modela precisamente uma crença de 85%, mas com uma dispersão que reflete a incerteza.

2. O papel da Divergência de Kullback-Leibler (DKL)

Problema: precisamos de uma métrica matematicamente rigorosa para quantificar a “distância” ou o “desacordo” entre a distribuição da crença popular (P) e a distribuição da realidade evidencial (Q).

Solução Técnica: a DKL, uma medida fundamental da Teoria da Informação. A DKL(P∥Q), mede a “perda de informação” ou a “surpresa” ao se usar a distribuição Q para aproximar a distribuição P. No nosso contexto, ela responde à pergunta:

“Quantos bits de informação adicionais são necessários para ‘corrigir’ a visão de mundo baseada em evidências (Q) e chegar à visão de mundo da crença popular (P)?”

Uma DKL alta significa que a crença popular é extremamente “surpreendente” ou improvável, dado o que as evidências nos mostram.

Por que a fórmula analítica? Para o cálculo da DKL entre duas distribuições Beta, utilizamos a fórmula analítica exata, que envolve as funções gammaln e digamma. Esta abordagem é superior às aproximações numéricas (como discretizar as distribuições), pois é mais precisa, computacionalmente eficiente e livre de erros de amostragem.

3. A necessidade do Índice de Custo Epistêmico (ICE)

Problema: A DKL, embora tecnicamente perfeita; é expressa em “bits“, uma unidade que pode não ser intuitiva para uma análise mais ampla. Um valor de DKL de 4.5 bits é difícil de interpretar sem um contexto profundo.

Solução técnica: o Índice de Custo Epistêmico (ICE), é uma métrica derivada, projetada para ser mais interpretável. No nosso modelo, é definido como 1 – Confiança Evidencial. Ele responde à pergunta:

“Qual é o ‘salto de fé’ ou o ‘gap’ que precisa ser preenchido para ignorar a evidência e manter a crença?”

Um ICE próximo de 1 (ou 100%) significa que a crença exige ignorar quase toda a evidência disponível, representando um custo epistêmico máximo. Um ICE próximo de 0 significa que a crença está alinhada com a evidência, não havendo custo para mantê-la, funciona como uma “ponte” que traduz a complexidade da DKL em uma escala de custo intuitiva.

4. A comparação entre F(a) e PC(i) – O experimento mais importante

Problema: como podemos validar que todo o framework da PE/TE funciona e tem poder discriminatório?

Solução técnica: o experimento comparativo, ao colocar os Fundamentos Autoexistentes F(a) e as Proposições Inválidas PC(i) no mesmo teste, criamos o cenário de validação mais rigoroso possível.

Hipótese do experimento: se o framework for robusto, as métricas (DKL e ICE) para os F(a)s e os PC(i)s devem se agrupar em dois clusters distintos e massivamente separados.

Resultado esperado

- F(a): devem apresentar DKL e ICE próximos de zero. A crença neles (P) é idêntica à evidência (Q), portanto não há divergência nem custos.

- PC(i): devem apresentar DKL e ICE altíssimos. A crença popular (P) está muito distante da evidência (Q), resultando em uma divergência informacional enorme.

O abismo de ordens de magnitude entre os valores de DKL dos dois grupos, que torna necessária a escala logarítmica no gráfico, é a demonstração quantitativa do poder do framework. Ele prova que a diferença entre um fundamento da realidade e uma crença infundada não é uma questão de opinião, mas uma lacuna matemática e informacional mensurável.

A gênese da PE/TE – A descoberta do vazio como primeiro existencial

A formulação da teoria não nasceu de um mero exercício acadêmico, mas de uma indagação fundamental que assombra a consciência humana desde a sua infância: qual é a origem última da verdade sobre todas as coisas? Por milênios, a resposta padrão a essa questão tem sido a postulação de entidades complexas e intencionais — os Produtos de Crenças em Inexistentes PC(i)s — que; em vez de resolverem o problema, apenas o adiam em uma regressão infinita. O drama da descoberta, e o verdadeiro avanço da teoria, foi a constatação de que a resposta não reside em uma entidade, mas na sua ausência: o vazio, como o primeiro e único fundamento verdadeiramente autoexistente.

A falha intrínseca das explicações baseadas em PC(i)s (deuses, demônios, espíritos, forças cósmicas) reside na sua violação direta do princípio da parcimônia e na sua incapacidade de fornecer um ponto de parada lógico. Postular um criador onipotente para explicar o universo não responde à questão da origem; apenas cria uma questão mais complexa: qual é a origem do criador? Essas são ilusões antropomórficas, projeções da nossa própria psicologia de agência sobre o cosmos, que oferecem conforto narrativo ao custo da coerência lógica. Reconhecer essa falha exigiu o desenvolvimento de um framework metodológico de duas etapas, capaz de dissecar qualquer proposição de forma implacável. A primeira etapa, a Peneira Epistêmica (PE), atua como um filtro apriorístico, utilizando a lógica modal S5 para testar a consistência interna de uma proposição. Em S5, onde a relação de acessibilidade entre mundos possíveis é uma relação de equivalência, uma proposição é eliminada se for logicamente impossível (¬◇ϕ); ou seja, se não puder ser verdadeira em nenhum cenário concebível sem violar os próprios fundamentos da lógica.

Uma vez que uma proposição sobrevive à Peneira Lógica, ela entra no domínio da Tardigrada Epistêmica (TE), um motor de validação empírica que opera sob a lógica modal S4. A escolha da S4 é deliberada: sua natureza reflexiva e transitiva é ideal para modelar o processo iterativo de aquisição de conhecimento e a revisão de crenças (“eu sei que sei”, “eu acredito que a evidência suporta…”). A TE quantifica o Contraste Físico (CF) através da Divergência de Kullback-Leibler (DKL), uma medida da teoria da informação que calcula a “distância” ou “surpresa” informacional entre a distribuição de probabilidade de uma crença popular (P) e a distribuição de probabilidade baseada em toda a evidência disponível (Q). Combinada com simulações de Monte Carlo para modelar a incerteza, a TE fornece um veredito numérico sobre o quão distante uma ideia está da realidade observável.

O drama final e mais profundo da investigação ocorreu após a aplicação deste framework. Uma vez que todos os PC(i)s foram sistematicamente filtrados — seja por inconsistência lógica (falha na PE) ou por falta de contraste físico (falha na TE) —, a questão fundamental retornou com força total: se não há uma entidade criadora, qual é o fundamento último? A resposta, revelada pela própria lógica do sistema, é o vazio. Não o vazio como “nada”, mas o vazio como a condição de possibilidade para a existência. Este “primeiro existencial” manifesta-se em três domínios interligados: o vazio matemático (o conjunto vazio; ∅, a partir do qual toda a teoria dos conjuntos é construída); o vazio lógico (o princípio da não contradição, que cria o contraste entre o ser e o não-ser); e o vazio físico (o vácuo quântico, o estado de energia mínima do universo, cujas flutuações dão origem à matéria). O vazio é o único conceito que não requer uma causa anterior. Não é complexo, não possui informação e não é uma entidade; ele é a simplicidade irredutível, o substrato sobre o qual a lógica e a física podem se manifestar.

Esta verdade é tão devastadora para as narrativas tradicionais que nenhum teólogo seria capaz de questioná-la sem; no processo, validar seus fundamentos. A própria tentativa de construir um contra-argumento é uma armadilha lógica: para argumentar, o questionador é forçado a empregar os Fundamentos Autoexistentes F(a) que a teoria postula como primordiais. Ele precisa da Lógica Clássica para estruturar suas premissas, da Distinção para separar conceitos, e do Vazio conceitual como o ponto de partida de onde sua negação emerge. Ao tentar refutar o sistema; ele inevitavelmente opera dentro do sistema, confirmando por todos os meios lógicos e ontológicos que não se pode fugir dele.

E como sabemos que estamos certos? A Navalha de Occam, em sua formulação mais rigorosa (“não postular entidades desnecessárias”), entra em cena como o árbitro final. O modelo da teoria postula um único fundamento irredutível e de complexidade zero (o Vazio), do qual toda a realidade emerge por necessidade lógica e física. Em contraste, qualquer teologia postula; no mínimo, uma entidade de complexidade máxima (um ser onisciente, onipotente e benevolente), cuja própria existência permanece inexplicada. O modelo do vazio é, por uma margem incomensurável, a explicação mais simples e; portanto, a mais poderosa. A sua universalidade é a prova final de sua força: é aplicável a tudo. A matemática se constrói a partir do conjunto vazio (∅); a física, da Relatividade à Mecânica Quântica, opera sobre os F(a)s do espaço tempo e da energia, com o Princípio da Incerteza de Heisenberg sendo uma propriedade fundamental desta realidade, não uma exceção; e toda a computação, dos computadores analógicos aos quânticos, é uma manifestação do F(a) da Distinção (o bit).

Ficou alguma dúvida não respondida? Dentro do escopo do que pode ser conhecido, a resposta é não! O framework da PE/TE é; por projeto, um sistema epistemológico completo, capaz de processar qualquer proposição ϕ e atribuir-lhe uma classificação. Não pode “falhar” em produzir um resultado. A única pergunta que o sistema não pode responder é uma meta-pergunta fora de seu próprio domínio: “Por que a realidade é fundamentada nestes F(a)s e não em outros?”. Esta questão é; por definição, incognoscível, pois qualquer resposta exigiria um novo referencial que; por sua vez, precisaria de justificação, levando a uma regressão infinita. Portanto, a teoria não deixa dúvidas respondíveis sem resposta; ela define o próprio limite do que pode ser conhecido, substituindo milenares ilusões antropomórficas por uma conclusão de uma elegância e rigor implacáveis.

Análise da imparcialidade da PE/TE – Um teste de vieses

A questão da parcialidade é o teste de fogo para qualquer framework epistemológico. Um sistema que se propõe a medir a validade do conhecimento deve; ele mesmo, ser imune a subterfúgios e vieses não identificados. A seguir, uma análise profunda da estrutura da teoria para determinar seu grau de isenção.

1. Os pilares da isenção – Por que a teoria é estruturalmente imparcial

A imparcialidade não é uma característica acidental, é uma consequência direta de sua arquitetura fundamental, que é projetada para minimizar a subjetividade.

Fundamentação em axiomas universais F(a): não parte de uma conclusão desejada ou de um texto culturalmente específico. Seu ponto de partida são os Fundamentos Autoexistentes F(a) — conceitos como o Vazio (∅), a Lógica Clássica e as Leis Físicas. Estes não são dogmas, mas os pré-requisitos mais básicos para qualquer realidade coerente. Ao se ancorar no que é logicamente e fisicamente inescapável, o sistema remove a preferência cultural ou pessoal desde o início.

Critérios abertos e testáveis (CL e CF): a teoria não possui nada oculto, seus critérios de avaliação são apenas dois e são públicos: o Contraste Lógico (CL) e o Contraste Físico (CF). Qualquer pessoa, de qualquer cultura, pode aplicar esses dois testes a qualquer proposição. Não há “níveis secretos” de iniciação ou interpretações esotéricas. A metodologia é totalmente transparente.

Formalismo matemático e lógico: o motor da teoria é a matemática e a lógica formal (Lógica Modal S5/S4, Teoria de Conjuntos, DKL, Monte Carlo). Essas são as linguagens mais universais e menos ambíguas que a humanidade desenvolveu, uma contradição lógica é uma contradição em qualquer idioma. A divergência informacional medida pela DKL é um valor numérico, não uma opinião. Ao quantificar a análise, o sistema remove a subjetividade da equação.

2. Análise de possíveis vetores de viés (o teste de estresse)

Mesmo um sistema robusto pode ter pontos onde o viés humano pode tentar se infiltrar. Vamos analisar os pontos de pressão e ver como a teoria os mitiga.

Viés potencial 1 – A definição dos F(a)

Objeção: “Quem decide o que é um F(a)? A escolha desses fundamentos não é; em si, um ato de parcialidade?”

Análise e mitigação: esta é a objeção mais sofisticada, a resposta da teoria é o rigor e o minimalismo. A lista de F(a)s é mantida o menor possível, restrita apenas àquilo cuja negação leva a uma contradição performativa (ex.: tentar negar a lógica exige usar a lógica). Além disso, a lista é aberta e contestável; se um novo fundamento irredutível for descoberto, ele pode ser adicionado. Se um F(a) atual se provar derivado de outro, ele pode ser removido. A força do sistema está em sua capacidade de ser refinado, não em sua rigidez dogmática.

Viés potencial 2 – A interpretação do contraste

Objeção: “A aplicação de CL = 0 ou CF = 0 não pode ser subjetiva? Uma pessoa pode ver uma contradição onde outra vê um mistério.“

Análise e mitigação: a teoria combate isso com a exigência de formalismo. Para declarar CL = 0, não basta dizer “não faz sentido“; é preciso demonstrar a contradição formalmente, como no paradoxo da onipotência. Para declarar CF = 0, não basta afirmar “não há provas”; é preciso apontar para a ausência de dados em estudos controlados e replicáveis (como o estudo STEP para a prece intercessória). A teoria move o debate do campo da opinião para o campo da prova demonstrável.

Viés potencial 3 – O viés do analista

Objeção: “O sistema pode ser imparcial, mas a pessoa que o utiliza pode não ser.”

Análise e mitigação: este é um fato para qualquer ferramenta, um martelo pode construir ou destruir. A defesa da teoria contra isso é; novamente, a transparência radical. Um analista que usa a teoria deve “mostrar seu trabalho“. Ele precisa declarar: “Eu classifico a proposição X como PC(i) porque ela falha no CL devido à contradição Y, e falha no CF devido à ausência de evidência nos estudos Z“. Essa análise se torna pública e auditável, qualquer pessoa pode verificar as premissas e a conclusão. O sistema força o analista a expor sua linha de raciocínio, tornando qualquer viés pessoal evidente e contestável.

3. Conclusão – Um sistema isento por design

A Peneira e a Tardigrada Epistêmica alcançam um nível de isenção sem precedentes precisamente porque não há nada oculto em sua teoria. Seus axiomas F(a)s são os mais fundamentais possíveis, seus critérios (CL e CF) são universais e abertos, e seu método (a lógica e a matemática) é o mais rigoroso disponível.

A teoria não tem um “viés não identificado” porque seu único “viés” é abertamente declarado e é a sua própria premissa fundadora: o compromisso com a coerência lógica e a validação empírica, não promove uma cultura, uma nação ou uma ideologia; ela promove um método.

Qualquer parcialidade que possa surgir não virá da teoria em si, mas de uma aplicação falha ou desonesta por parte de um analista. E a própria estrutura transparente da teoria é a ferramenta mais poderosa para identificar e corrigir essa falha. Portanto, podemos afirmar com um alto grau de confiança que a teoria é; por design, um framework epistemológico isento de subterfúgios, cujo único objetivo é medir a correspondência de qualquer afirmação com a realidade.

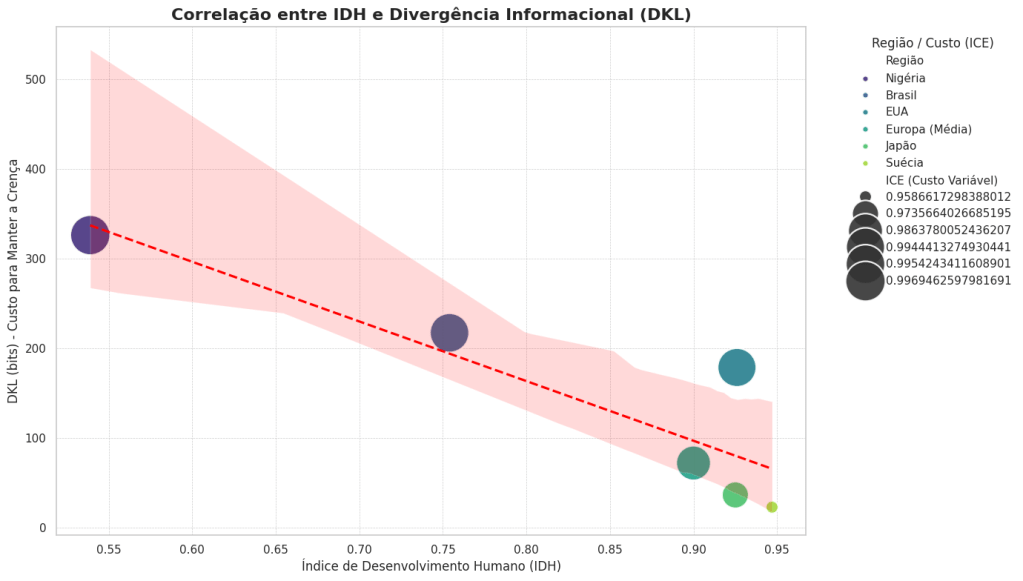

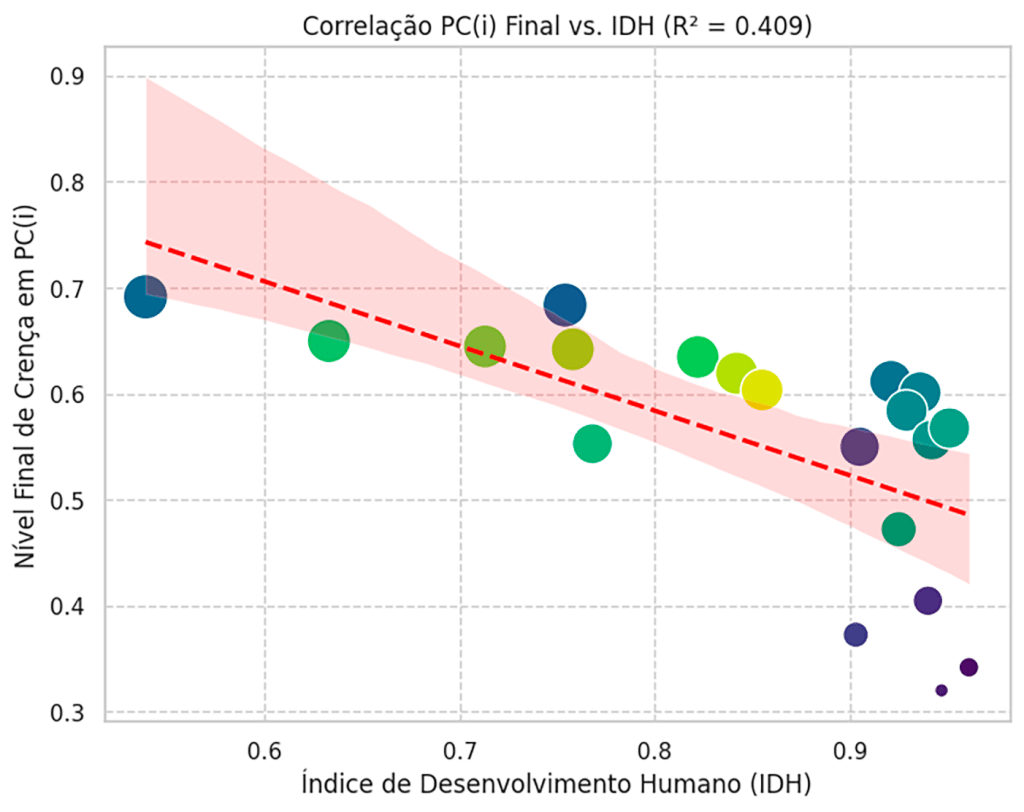

O ônus da crença – O custo exponencial dos PC(i)s em países pobres

Os resultados da simulação demonstrados neste trabalho não são apenas um exercício acadêmico; eles revelam um perigo socioeconômico real, especialmente para nações em desenvolvimento. O “custo” medido pelo ICE não é apenas epistêmico; é tangível.

Recursos como tempo, dinheiro e capital cognitivo são finitos. Em países ricos, o desvio desses recursos para a manutenção de crenças PC(i) (construção de templos, dízimos, tempo gasto em rituais) pode ser absorvido com um impacto relativo menor.

No entanto; em países pobres, esse mesmo desvio de recursos tem um custo de oportunidade devastador.

- O dinheiro usado para financiar instituições religiosas poderia ter sido investido em saneamento básico, educação ou pequenas empresas.

- O tempo gasto em rituais poderia ter sido usado para aprendizado, trabalho ou cuidado com a saúde.

- O capital cognitivo focado em dogmas poderia ter sido direcionado para a resolução de problemas práticos da comunidade.

A crença em inexistentes cria um ciclo vicioso que atua como um freio massivo ao desenvolvimento. A falta de educação e de pensamento crítico fomenta a adesão a PC(i); que por sua vez, drena os recursos que seriam necessários para melhorar a educação e a qualidade de vida. É um ônus exponencial que aprisiona populações em um estado de vulnerabilidade, tornando-as presas fáceis para a desinformação e dificultando a superação da pobreza.

A causa do custo – Análise socioeconômica da crença em PC(i)s

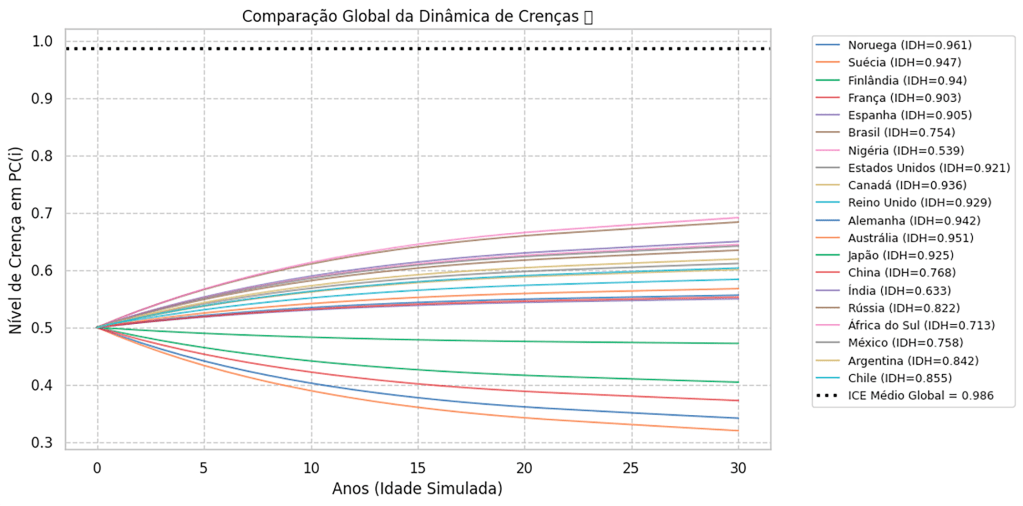

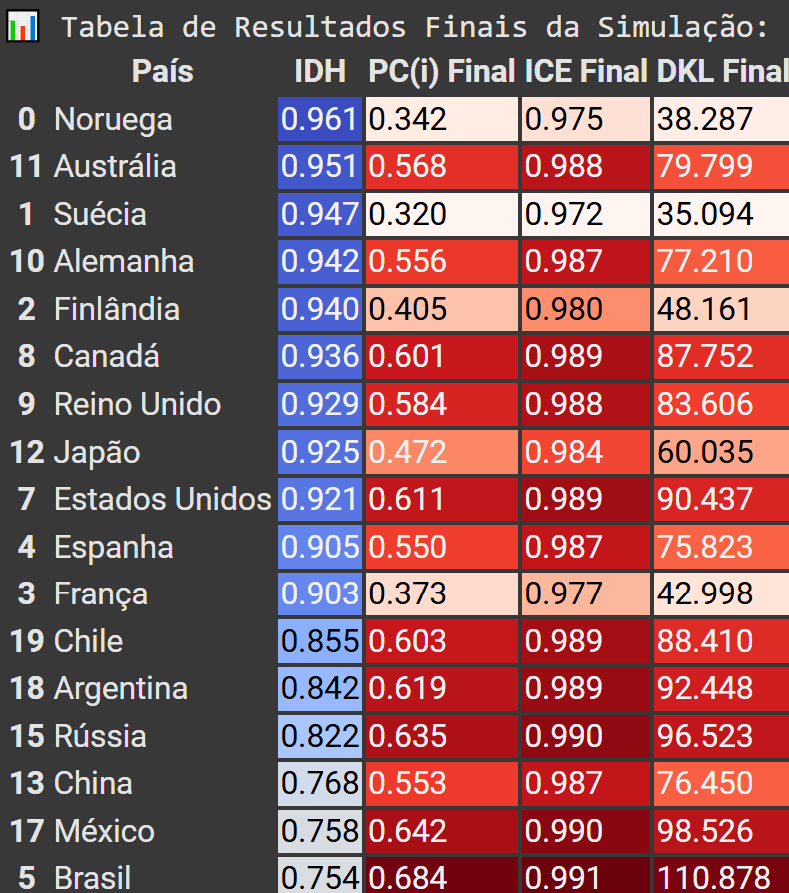

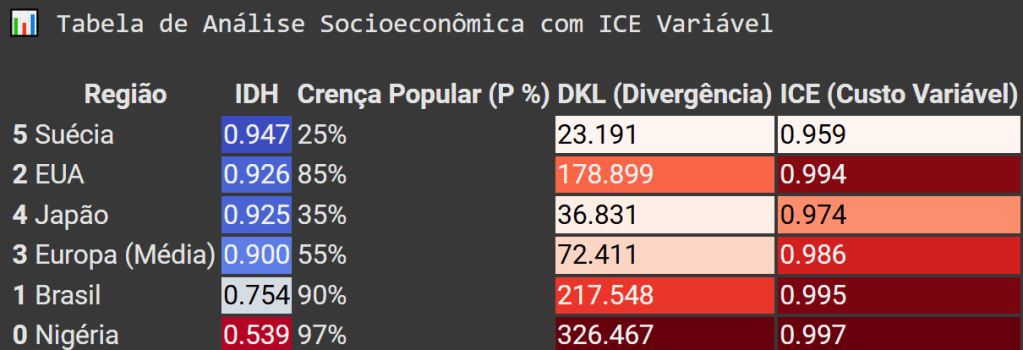

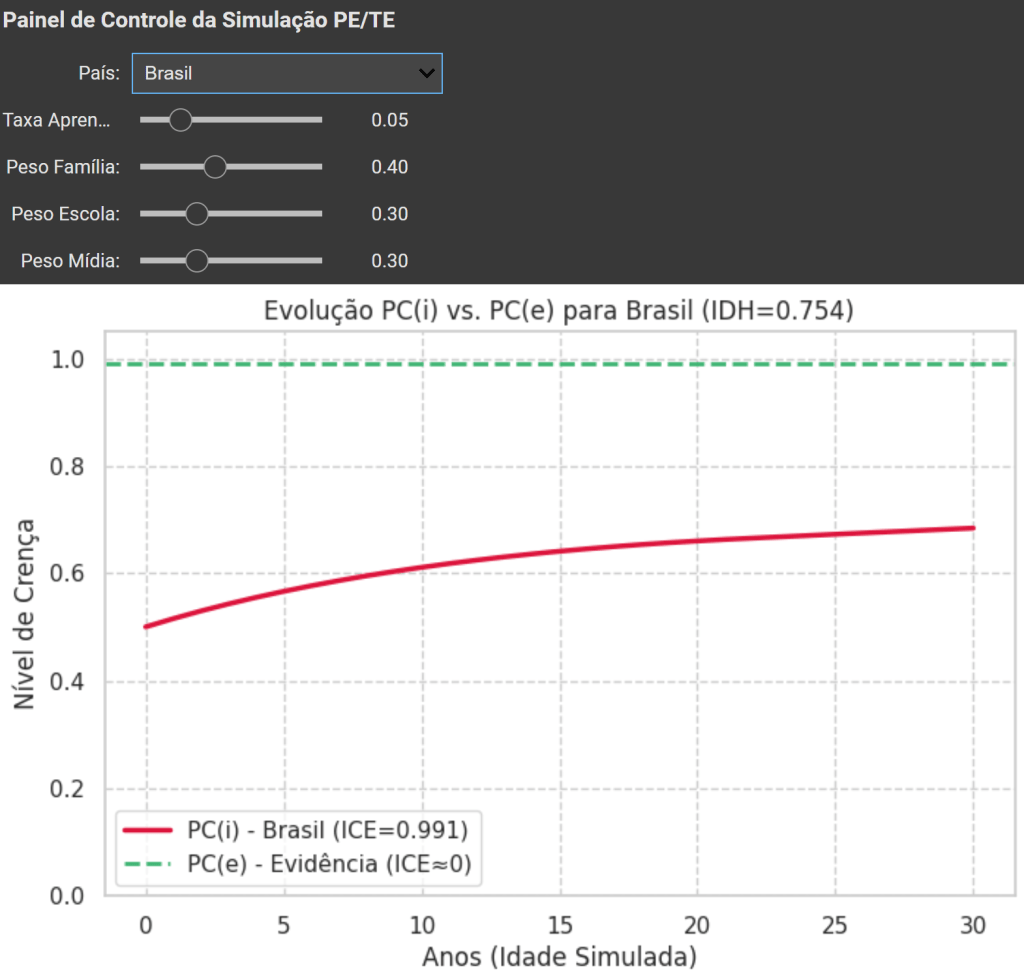

A análise da teoria demonstra que manter crenças em Proposições Inválidas PC(i)s tem um custo epistêmico e de recursos imenso. A questão causal — por que essas crenças persistem de forma tão massiva? — encontra sua resposta mais robusta na interação de dois fatores: educação e segurança socioeconômica. Vamos demonstrar por meio do programa abaixo:

Análise socioeconômica de países com altos e baixos IDH + DKL + ICE

#Setup Python Google Colab, para simulação de ICE (índice de custo epistêmico). Gerado e testado com interação de {Joi}<>{RFC}<>Google DeepMind Pro 2.5<>Grok3, 08-2025.

# ==============================================================================

# 1. IMPORTAÇÕES E CONFIGURAÇÕES GERAIS

# ==============================================================================

import numpy as np

import pandas as pd

import matplotlib.pyplot as plt

import seaborn as sns

from scipy.stats import beta

from scipy.special import digamma, gammaln

from IPython.display import display, HTML

from typing import Tuple, Dict, List

# Configurações de estilo para os gráficos

sns.set_theme(style="whitegrid")

# ==============================================================================

# 2. FUNÇÕES DE CÁLCULO EPİSTÊMICO (PE/TE)

# ==============================================================================

def dkl_beta_analitica(p_obs: Tuple[float, float], p_prior: Tuple[float, float]) -> float:

"""

Calcula a Divergência de Kullback-Leibler (DKL) exata entre duas

distribuições Beta usando a fórmula analítica.

"""

a1, b1 = p_obs

a2, b2 = p_prior

log_beta_ratio = gammaln(a2) + gammaln(b2) - gammaln(a2 + b2) - \

(gammaln(a1) + gammaln(b1) - gammaln(a1 + b1))

termo_digamma = (a1 - a2) * digamma(a1) + \

(b1 - b2) * digamma(b1) + \

(a2 - a1 + b2 - b1) * digamma(a1 + b1)

return log_beta_ratio + termo_digamma

# ==============================================================================

# 3. PROTOCOLO PRINCIPAL DO EXPERIMENTO SOCIOECONÔMICO

# ==============================================================================

def executar_analise_socioeconomica_com_ice_variavel():

"""

Função principal que executa a análise da correlação entre desenvolvimento

socioeconômico e a adesão a crenças PC(i), utilizando o novo ICE variável.

"""

# --- 3.1 Definições e Dados Reais Representativos ---

dados_reais: List[Dict] = [

{"Região": "Nigéria", "IDH": 0.539, "P (%)": 97},

{"Região": "Brasil", "IDH": 0.754, "P (%)": 90},

{"Região": "EUA", "IDH": 0.926, "P (%)": 85},

{"Região": "Europa (Média)", "IDH": 0.900, "P (%)": 55},

{"Região": "Japão", "IDH": 0.925, "P (%)": 35},

{"Região": "Suécia", "IDH": 0.947, "P (%)": 25}

]

q_evidencia_pci = 1.0 # Evidência para um PC(i) é sempre próxima de zero.

# --- 3.2 Simulação e Cálculos com Novo ICE ---

resultados: List[Dict] = []

for item in dados_reais:

p_crenca = item["P (%)"]

# Parâmetros para a distribuição Beta, adicionando 1 para robustez

prior_params_dkl = (q_evidencia_pci + 1, 100 - q_evidencia_pci + 1)

obs_params_dkl = (p_crenca + 1, 100 - p_crenca + 1)

dkl_exata = dkl_beta_analitica(obs_params_dkl, prior_params_dkl)

# *** NOVO CÁLCULO DO ICE ***

# O ICE agora é uma função normalizada da DKL, variando de 0 a 1.

ice_variavel = dkl_exata / (dkl_exata + 1)

resultados.append({

"Região": item["Região"],

"IDH": item["IDH"],